JavaScript中二进制字符串的加法

问题要求我们对两个二进制字符串进行加法运算。二进制字符串是字节序列。要在 JavaScript 中对它们进行加法运算,我们首先需要将它们转换为十进制数,然后计算它们的和。将这些十进制数相加后,我们再将结果转换回二进制字符串并打印输出。

什么是二进制字符串?

二进制数或二进制字符串是基数为 2 的字节序列。它基本上是 0 和 1 的组合,用于表示任何数字。二进制加法是数学中对二进制字符串执行的一种运算。二进制加法与十进制加法类似,但基数为 2。

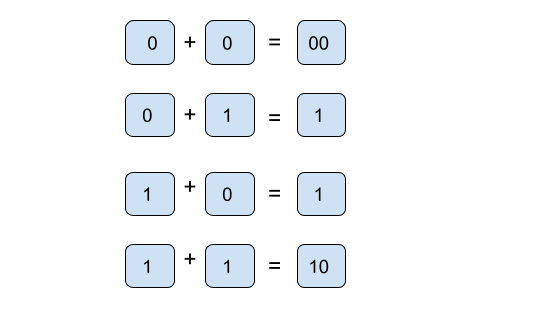

二进制数加法的规则:

二进制数加法有一些规则。如果我们遵循这些规则,那么加法运算将比十进制加法更容易。二进制数加法的规则如下:

理解问题

问题要求我们在 JavaScript 中计算给定二进制字符串的和。为了解决这个问题,我们将创建变量来存储这些二进制字符串。创建变量后,使用 JavaScript 中提供的 parseInt() 函数将其转换为十进制形式。然后计算这些转换后的数字的和。并再次将其转换为字符串格式。

算法

步骤 1:第一步定义一个名为 sumOfStrings() 的函数,并向其中传递两个参数。

步骤 2:声明函数后,定义两个变量 num1 和 num2。这些变量使用 parseInt() 函数将它们解析为基数为 2 的整数。

步骤 3:将十进制数 num1 和 num2 相加。并将它们的值赋给 sum 变量。

步骤 4:使用 toString 方法转换回二进制字符串,并将它的值赋给 binarySum。

步骤 5:最后,在所有流程结束后返回加法结果。

以下是该算法的伪代码

function sumOfStrings(s1, s2): num1 = parseInt(s1, 2) num2 = parseInt(s2, 2) addition = num1 + num2 binarySum = addition.toString(2) return binarySum

示例

// Define a function to calculate sum of strings

function sumOfStrings(s1, s2) {

// Converting binary strings to decimal numbers with parseInt

var num1 = parseInt(s1, 2);

var num2 = parseInt(s2, 2);

// Add decimal numbers num1 and num2 together

var sum = num1 + num2;

// Converting back to binary string with toString method

var binarySum = sum.toString(2);

// Return string

return binarySum;

}

//calling sumBinaryStrings function

var afterSum = sumOfStrings('0111', '1001');

//print on console

console.log("After adding two binary strings together")

console.log(afterSum);

输出

After adding two binary strings together 10000

在上面的代码中,我们使用了两个预定义的方法,即 parseInt() 和 toString()。让我们详细了解一下这些方法。

parseInt() 方法是 JavaScript 的预定义方法。此方法用于将二进制字符串转换为十进制数。为了进行转换,我们将必须传递一个基数(数学系统中的基数)参数。基数指定要使用的数字系统,例如二进制为 2,八进制为 8,十进制为 10,十六进制为 16。

当我们想要以字符串形式打印值时,使用 JavaScript 的 toString() 方法。在我们的代码中,sum.toString(2) 将计算出的 sum 转换为字符串格式。

复杂度

如果我们讨论这个程序的时间复杂度,它将花费 O(n) 时间来完成执行。在这种情况下,n 是两个二进制字符串的长度。因为这两个函数 (parseInt() 和 toString()) 都在给定字符串的长度上运行。而加法运算本身是一个简单的运算,计算和只需要常数时间。因此,该程序的整体复杂度可以通过将字符串的长度相加来计算。

结论

在这个问题中,我们学习了如何使用 JavaScript 方法 parseInt 和 toString。使用这两个方法,我们根据问题说明计算了两个二进制字符串的和。最后,该算法的时间复杂度为 O(n),因为这些方法需要字符串的长度来计算和。

数据结构

数据结构 网络

网络 关系数据库管理系统 (RDBMS)

关系数据库管理系统 (RDBMS) 操作系统

操作系统 Java

Java iOS

iOS HTML

HTML CSS

CSS Android

Android Python

Python C语言编程

C语言编程 C++

C++ C#

C# MongoDB

MongoDB MySQL

MySQL Javascript

Javascript PHP

PHP