基于训练集大小选择分类器

为了使机器学习模型达到最佳性能,选择正确的分类器算法至关重要。由于可用的方法范围很广,选择最佳分类算法可能具有挑战性。在选择算法时,必须考虑一系列因素,因为不同的算法对不同类型的数据效果更好。其中一个因素是训练数据的数量。大型训练数据集会对分类系统的性能产生重大影响。

分类器的性能通常会随着训练数据集大小的增加而提高。但这并非总是如此,因为某些分类器在训练集较少的情况下可能表现更好。为特定用例选择最佳方法需要了解各种分类器如何在各种数据大小下运行。在本篇文章中,我们将讨论一些最流行的机器学习分类器以及训练集大小如何影响它们的性能。

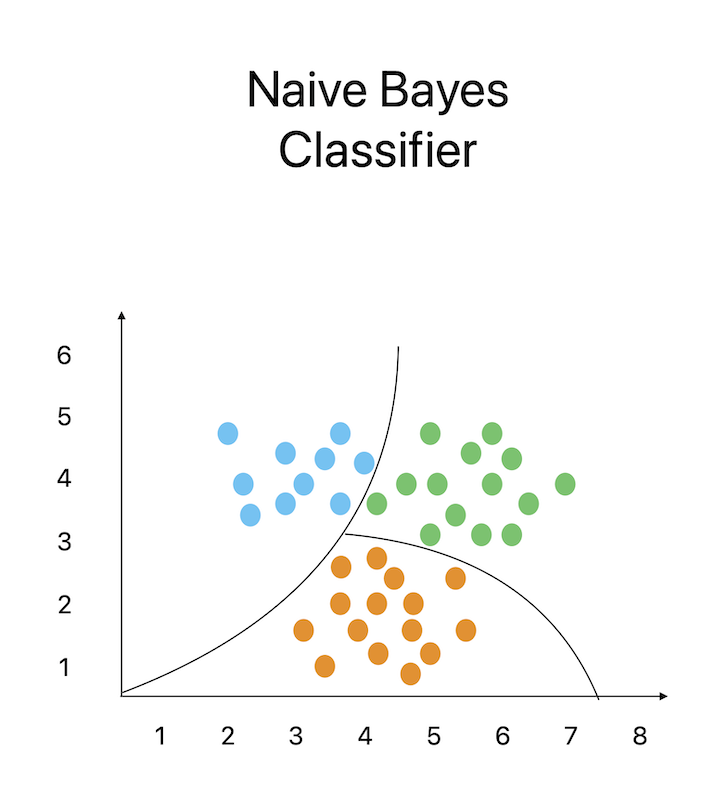

1. 朴素贝叶斯分类器

朴素贝叶斯是一种众所周知的分类技术,它通过应用贝叶斯定理来确定数据点是否属于某个特定类别。它基于这样的假设:一个特征包含在某个类别中的可能性与任何其他特征包含在该类别中的可能性无关。由于独立性假设,该方法可以有效地确定给定类别下每个特征的概率,将这些概率相乘,然后得到给定数据下类别的概率。

朴素贝叶斯特别适用于文本分类任务,例如垃圾邮件过滤和情感分析,在这种情况下,数据稀疏且特征数量众多。因为它即使在缺乏足够数据的情况下,仍然可以对类别和属性之间的关系做出可靠的预测,所以它特别适合小型训练集。就性能而言,朴素贝叶斯在小型训练集上可能非常有效,并且可以用最少的数据产生可靠的结果。一些朴素贝叶斯的应用包括文档分类、情感分析和电子邮件垃圾邮件筛选。

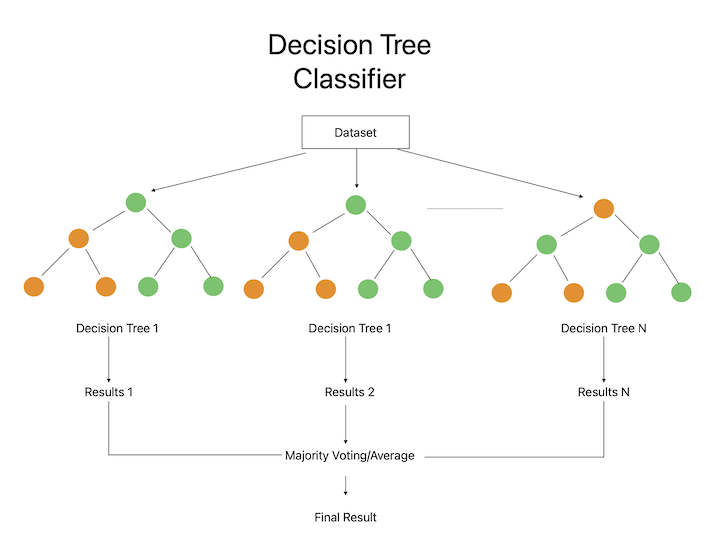

2. 决策树分类器

决策树是一种常见的分类方法,它使用节点的层次结构来表示决策及其结果。该算法从表示整个数据集的根节点开始,根据输入属性的值进行一系列决策,将数据划分为关于目标变量更同质的子集。当算法到达表示最终预测类别的树叶时,分割过程完成。

决策树尤其适用于数据中特征较少的情况,因为它可以快速识别最重要的特征及其与目标变量的关系。它们也可以在最小训练集上表现良好,因为它们可以找到简单的决策规则,这些规则擅长泛化到新数据。然而,当处理包含大量特征的复杂数据集时,它们可能会容易过拟合。决策树的一些应用包括信用风险分析、客户细分和医疗诊断。

3. 随机森林分类器

众所周知的分类方法随机森林结合了许多决策树。该方法通过使用输入特征和训练数据的随机子集来构建大量决策树。然后,使用所有树的预测的总和来创建最终预测。

随机森林尤其适用于数据包含大量特征的情况,因为它可以识别最重要的特征并捕获属性与目标变量之间的非线性关系。它也可以在大型训练集上表现良好,因为它可以容忍缺失值和噪声数据,并且可以扩展到高维数据。随机森林的一些应用包括生成推荐系统、图像分类和欺诈检测。

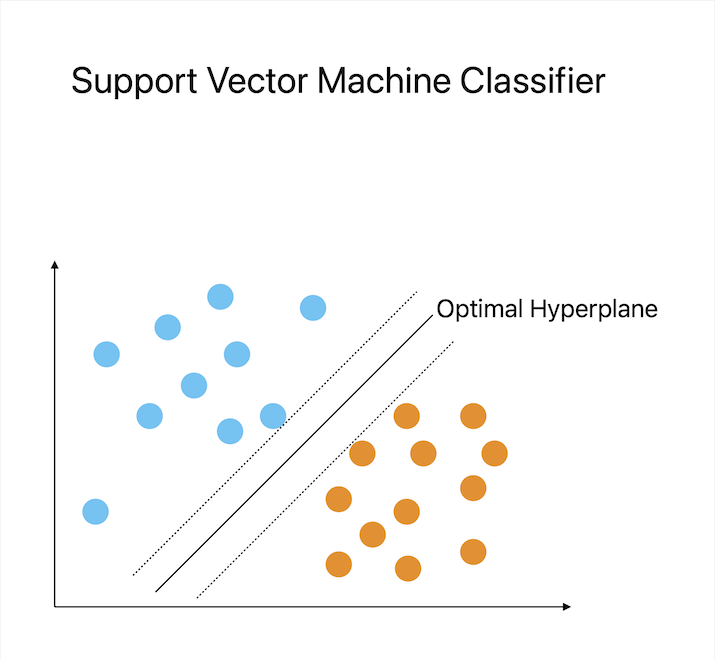

4. 支持向量机分类器

一种流行的分类技术,支持向量机 (SVM) 找到优化类别之间距离的超平面来对数据进行分类。在二元分类任务中,超平面表示将两个类别分开的决策边界。该方法通过将输入数据投影到高维空间来工作,在该空间中,线性分类器可以找到超平面。

SVM 非常适用于类别区分清晰且数据包含中等至大量特征的任务。因为它可以识别最重要的特征并忽略不重要的特征,所以它也可以在从小型到大型的训练集上表现良好。通过应用核函数,SVM 也擅长处理特征与目标变量之间的非线性关系。SVM 的一些应用案例包括图像分类、文本分类和生物信息学。

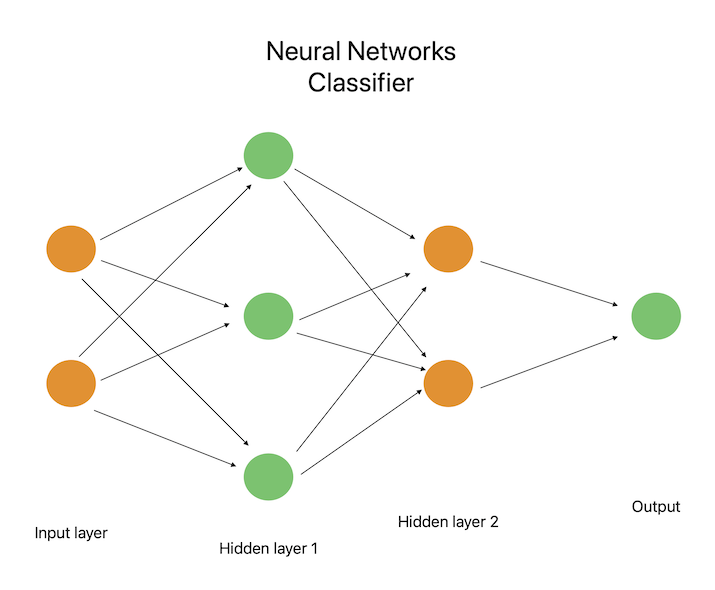

5. 神经网络分类器

神经网络是受人脑结构和功能启发的机器学习算法。神经网络由许多相互连接的节点(也称为神经元)组成,这些节点排列成层。第一层节点处理输入数据,然后继续处理前一层节点的输出,依此类推,最后一层产生网络的输出。在训练过程中,使用反向传播等优化方法来学习节点之间连接的权重和偏差。

对于需要复杂和多维输入的应用,例如语音和图像识别,神经网络非常有用。它们也擅长处理大型训练集,因为它们可以从大量数据中学习并识别特征与目标变量之间复杂的非线性关系。神经网络的一些应用包括自然语言处理、语音识别、自动驾驶和图像分类。

结论

总之,训练集的大小会显著影响分类器系统的性能。大型训练集可以提高泛化能力和准确性,而较大的训练集可以防止过拟合和泛化能力差。但是,某些算法可能在较小或较大的训练集上效果更好,具体取决于它们与之一起使用的数据类型。为了找到特定任务的最佳设置,务必尝试各种算法和训练集大小。

数据结构

数据结构 网络

网络 关系型数据库管理系统 (RDBMS)

关系型数据库管理系统 (RDBMS) 操作系统

操作系统 Java

Java iOS

iOS HTML

HTML CSS

CSS Android

Android Python

Python C语言编程

C语言编程 C++

C++ C#

C# MongoDB

MongoDB MySQL

MySQL Javascript

Javascript PHP

PHP