卷积神经网络的迁移学习

利用卷积神经网络 (CNN) 进行迁移学习彻底改变了计算机视觉领域,使人们能够在新的相关任务上重用预训练模型。这种强大的技术利用从大规模数据集中学到的知识,即使在标记数据有限的情况下,也能实现更快、更准确的模型训练。

通过使用预训练的 CNN 作为特征提取器并在特定任务的数据上微调网络,迁移学习大大减少了对大量训练时间和计算资源的需求。本文探讨了利用 CNN 进行迁移学习的概念、其应用、优势和注意事项,重点介绍了其增强各种计算机视觉任务的潜力。

卷积神经网络的迁移学习

利用卷积神经网络 (CNN) 进行迁移学习是一种方法,它允许将从一项任务中获得的知识转移并应用于另一项类似的任务。CNN 广泛应用于计算机视觉应用中,例如图像分类和目标检测。

迁移学习利用了这样一个事实:在大型数据集(例如 ImageNet)上训练的 CNN 已经学习了与许多视觉任务相关的通用特征。迁移学习不是从头开始在一个新数据集上训练 CNN,而是将预训练的 CNN 作为起点,并在新数据集上对其进行微调。

预训练的 CNN 充当特征提取器,捕获高级视觉表示。然后将这些特征传递给为特定任务设计的新层。在微调期间,预训练层被冻结,而新层被调整。

使用卷积神经网络实施迁移学习的步骤

要使用卷积神经网络 (CNN) 实施迁移学习,请按照以下步骤操作:

选择预训练模型 − 选择适合任务和数据集的预训练 CNN 模型。流行的选择包括 VGG、ResNet、Inception 或 MobileNet。这些模型通常可以在 TensorFlow 或 PyTorch 等深度学习库中找到。

加载预训练模型 − 加载预训练的 CNN 模型,但不包括顶部(全连接)层。这使我们能够利用预训练模型学习到的特征。

自定义模型 − 在预训练模型的顶部添加新层以使其适应您的特定任务。这些层应包含适合您任务的架构,例如全连接层、dropout 层或卷积层。根据您的具体要求调整神经元或类的数量。

冻结预训练层 − 冻结预训练层的权重以防止它们在训练期间更新。这确保了保留预训练的特征并且不会修改它们。

准备数据 − 根据预训练模型的输入要求预处理您的数据集。这可能涉及调整图像大小、归一化或增强图像。

训练模型 − 使用您的数据集训练模型。在预训练层保持冻结的同时,只会训练预训练模型顶部新添加的层。

微调(可选) − 如果您有足够的数据并且想要进一步提高性能,您可以解冻一些预训练层并与新层一起对其进行微调。这允许模型适应数据集的特定特征。

评估和测试 − 使用验证数据或交叉验证技术评估训练后的模型。衡量准确率、损失、精确率或召回率等指标以评估性能。最后,在未见过的数

以下是使用 CIFAR-10 数据集利用卷积神经网络 (CNN) 进行迁移学习的工作代码示例:

示例

import tensorflow as tf

from tensorflow.keras.datasets import cifar10

from tensorflow.keras.applications import VGG16

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Flatten, Dense

from tensorflow.keras.utils import to_categorical

# Load CIFAR-10 dataset

(itrain, ltrain), (itest, ltest) = cifar10.load_data()

# Preprocess the data

itrain = itrain / 255.0

itest = itest / 255.0

ltrain = to_categorical(ltrain)

ltest = to_categorical(ltest)

# Load pre-trained VGG16 model (excluding the top fully-connected layers)

basem = VGG16(weights='imagenet', include_top=False, input_shape=(32, 32, 3))

# Freeze the pre-trained layers

for layer in basem.layers:

layer.trainable = False

# Create a new model on top

semodel = Sequential()

semodel.add(basem)

semodel.add(Flatten())

semodel.add(Dense(256, activation='relu'))

semodel.add(Dense(10, activation='softmax')) # CIFAR-10 has 10 classes

# Compile the model

semodel.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# Train the model

semodel.fit(itrain, ltrain, epochs=10, batch_size=32, validation_data=(itest, ltest))

# Evaluate the model on test data

ltest, atest = semodel.evaluate(itest, ltest)

print("Test accuracy:", atest)

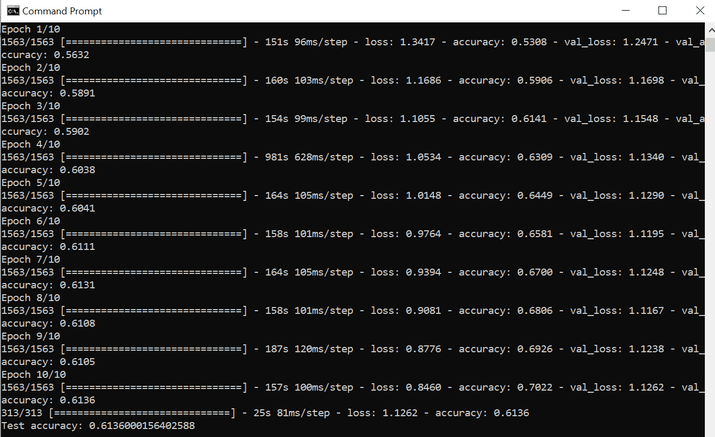

输出

在上面的示例中,我们首先加载了 CIFAR-10 数据集并通过归一化像素值和对标签进行独热编码来预处理数据。然后,我们加载预训练的 VGG16 模型并冻结其层。我们在顶部创建了一个新模型,该模型由基本模型、一个扁平化层、一个具有 ReLU 激活函数的密集层和一个具有 softmax 激活函数的密集层组成,用于分类。

应用

利用卷积神经网络 (CNN) 进行迁移学习在各种计算机视觉任务中具有众多应用。它已成功应用于图像分类,其中可以对预训练模型进行微调以用于特定类别或领域。迁移学习在目标检测中也很有益,其中可以利用预训练的 CNN 作为特征提取器来识别图像中的目标。

此外,迁移学习在图像分割任务中也很有价值,有助于准确的像素级标记。它广泛应用于面部识别系统,通过利用预训练的 CNN 模型来实现高精度。迁移学习还应用于医学影像,例如诊断疾病或检测异常。总的来说,利用 CNN 进行迁移学习可以加速模型训练、提高性能,并在各种实际计算机视觉应用中使用深度学习。

优势和增强各种计算机视觉任务的潜力

利用卷积神经网络 (CNN) 进行迁移学习具有多种优势,并且有可能增强各种计算机视觉任务。

它通过利用在 ImageNet 等大型数据集上训练的预训练模型,减少了对大型标记数据集的需求。当使用标记数据有限时,这尤其有利,这使得在数据稀缺的情况下训练准确的模型成为可能。

迁移学习加快了训练过程。预训练的 CNN 已经学习了通用特征,因此与从头开始训练相比,在特定任务上微调模型需要更少的时间。它还减少了训练所需的计算资源。

迁移学习使模型能够很好地泛化到新的任务和数据集。通过利用从预训练中获得的知识,模型可以捕获有意义的表示并提高特定任务的性能。

迁移学习可以增强各种计算机视觉任务,例如图像分类、目标检测、图像分割等。通过利用预训练的 CNN,模型可以实现更高的准确率、更快的收敛速度和更好的泛化能力,使其适用于各种实际应用。

结论

总之,利用卷积神经网络 (CNN) 进行迁移学习是一种强大的技术,可以增强各种计算机视觉任务。通过利用预训练模型,它减少了对大量标记数据的需求,加快了训练速度并提高了泛化能力。利用 CNN 进行迁移学习是推进计算机视觉应用的宝贵工具。

数据结构

数据结构 网络

网络 关系数据库管理系统

关系数据库管理系统 操作系统

操作系统 Java

Java iOS

iOS HTML

HTML CSS

CSS Android

Android Python

Python C 编程

C 编程 C++

C++ C#

C# MongoDB

MongoDB MySQL

MySQL Javascript

Javascript PHP

PHP