理解机器学习中的激活函数

在机器学习中,激活函数就像神经网络中的魔法成分一样。它们是数学公式,根据神经元接收到的信息来决定是否应该激活。神经网络学习和表示复杂数据模式的能力,很大程度上取决于激活函数。这些函数为网络引入了非线性,使其能够处理各种问题,包括复杂的关系和交互。简单来说,激活函数使神经网络能够发现隐藏模式、预测结果和正确分类数据。在这篇文章中,我们将了解机器学习中的激活函数。

什么是激活函数?

激活函数是神经网络的一个重要组成部分,它根据神经元接收到的信息来决定是否激活该神经元。激活函数的主要作用是使网络非线性化。在一个线性模型中,输入只是被缩放和相加,其输出也是输入的线性组合。

然而,激活函数赋予神经网络学习和表示复杂函数的能力,这些函数与简单的线性连接建模的函数不可比拟。由于激活函数的非线性特性,网络能够识别数据中复杂的模式和关系。它使网络能够处理非线性变化的输入,从而能够处理各种现实世界的问题,包括时间序列预测、图像识别和自然语言处理。

非线性的重要性

非线性是神经网络成功的一个关键因素。它至关重要,因为现实世界中的许多现象和关系本质上是非线性的。线性激活函数由于只能模拟简单的线性关系,因此在捕捉复杂模式方面的能力有限。如果没有非线性,神经网络只能表示线性函数,这将极大地限制其处理复杂问题的能力。另一方面,非线性激活函数使神经网络能够逼近和表示数据中的复杂关系。它们使网络能够学习和模拟复杂的模式,从而反映现实世界中存在的复杂性和非线性关系。

机器学习中激活函数的类型

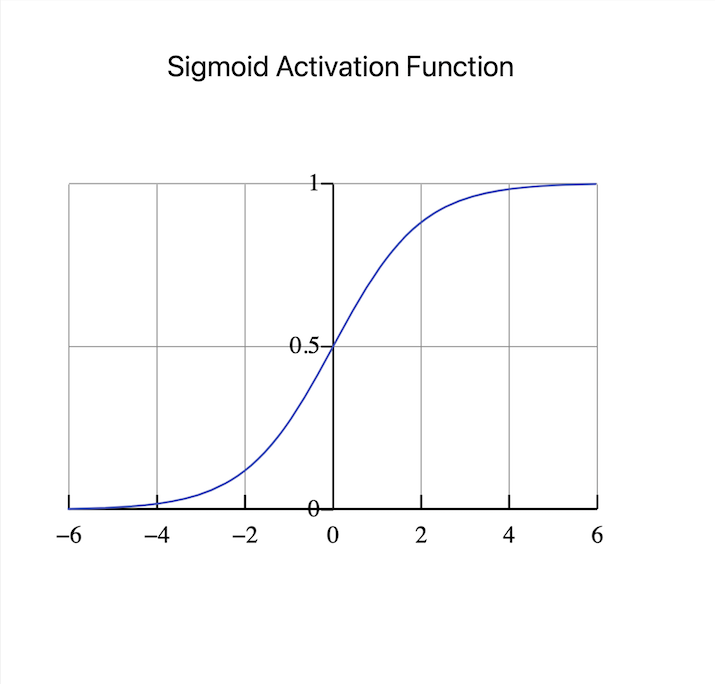

Sigmoid激活函数

Sigmoid激活函数是大多数人选择的函数。它具有S形曲线,将输入映射到0到1之间的范围。它可用于二元分类问题,目标是预测两个类别中的哪一个会发生。Sigmoid函数通过将输入压缩到概率范围内,产生易于理解的输出,可以解释为属于特定类别的概率。

然而,Sigmoid激活函数容易受到梯度消失问题的困扰。随着网络深度的增加,梯度变得非常小,这会阻碍学习并导致收敛缓慢。由于这个限制,研究人员正在探索新的激活函数,以解决梯度消失问题并改进深度神经网络的训练。

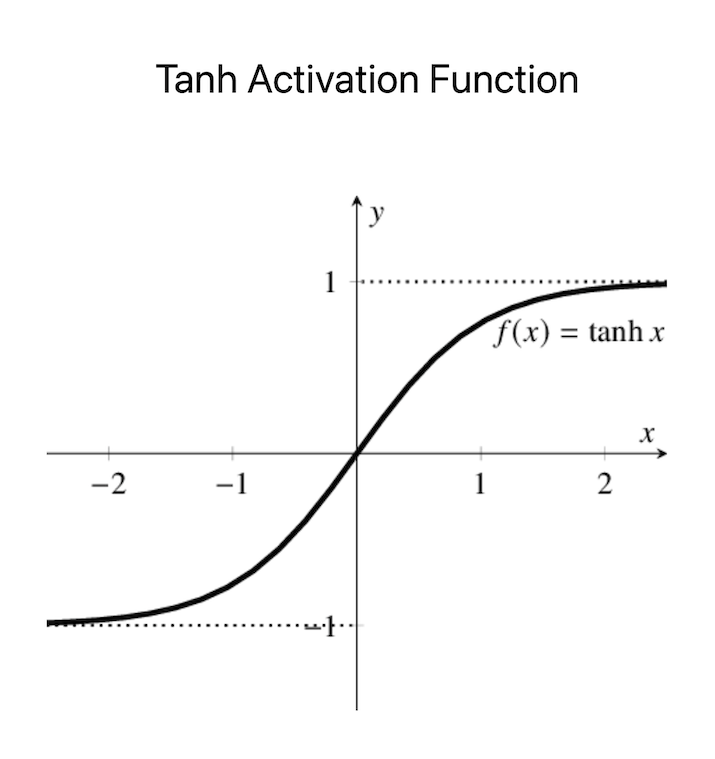

Tanh激活函数

双曲正切(tanh)激活函数与Sigmoid函数类似,它也具有S形曲线,尽管它将输入映射到-1到1的范围。与Sigmoid函数类似,tanh在二元分类问题中很有用,因为它产生概率输出,可以转换为类别概率。tanh函数的优点是它产生零均值的输出,这对于训练某些模型可能很有帮助。

然而,它在深度神经网络中的应用仍然受到梯度消失问题的限制。此外,tanh函数比Sigmoid函数更容易饱和,因为它具有更陡峭的梯度。因此,它在训练过程中可能不太稳定,并且容易受到初始参数设置的影响。但是,在某些情况下,特别是需要零均值输出或平衡类别预测的情况下,tanh激活函数仍然是一个可行的选择。

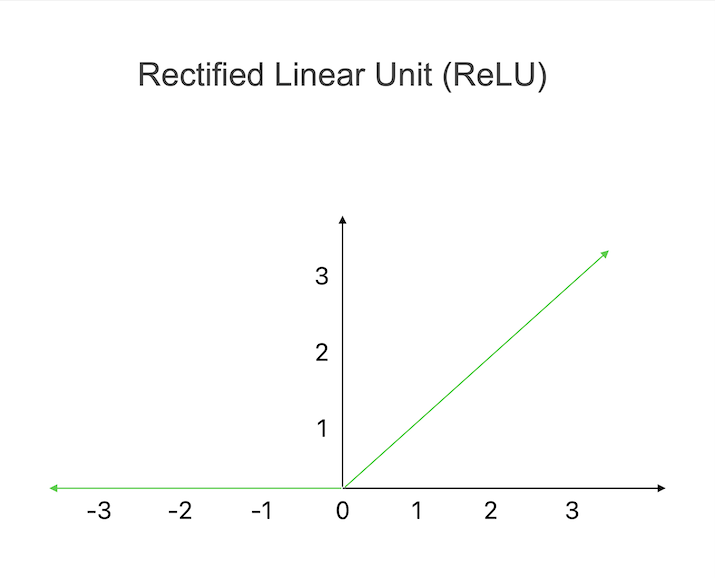

修正线性单元 (ReLU)

修正线性单元 (ReLU) 是一种广泛使用的激活函数,它将所有负输入归零,而将正输入保持为原始值。通过这个简单的激活规则,ReLU可以引入非线性并检测数据中的复杂模式。ReLU的主要优点之一是它的计算效率。由于它只需要简单的操作,所以该激活函数比其他函数更容易计算。然而,ReLU也有一些缺点。

一个潜在的问题被称为“死亡ReLU”,其中某些神经元永久处于休眠状态,对任何输入都输出0。这种现象会对训练过程产生负面影响,因为损坏的神经元不再对学习有用。然而,诸如使用多个ReLU或适当的初始化程序之类的策略可以减少死亡ReLU的可能性,并确保深度神经网络训练的成功。

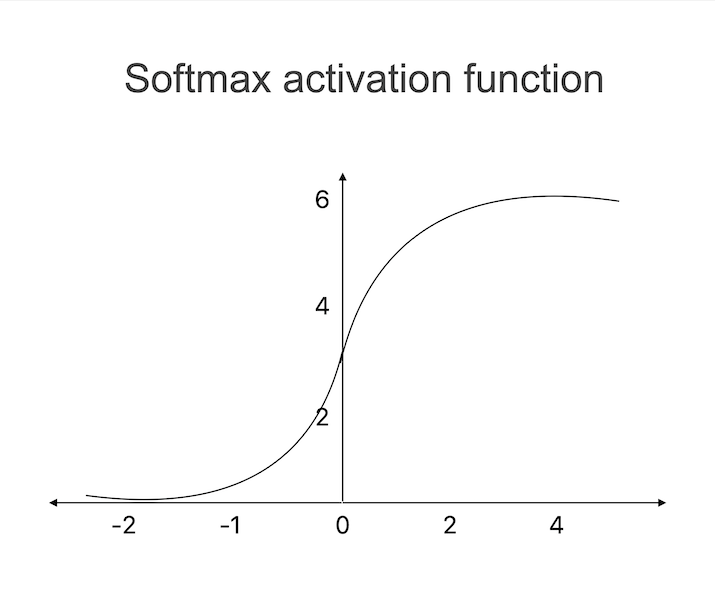

Softmax激活函数

Softmax函数通常用于多类别分类问题,目标是将输入分类到多个可能的类别之一。它将实数值输入向量归一化为概率分布。Softmax函数确保输出概率之和为1,这使其适用于不能同时存在的类别的情况。Softmax函数产生一个概率分布,这使我们能够将输出解释为输入属于每个类别的概率。

因此,我们可以更有信心地进行预测,并将输入分配给概率最高的类别。对于图像识别、自然语言处理和情感分析等需要同时考虑多个类别的应用,Softmax函数是一个重要的机器学习工具。

结论

总之,激活函数在机器学习中的重要性怎么强调都不为过。它们在神经网络中充当决策者,决定是否转发信息。简而言之,激活函数是使神经网络发挥其全部潜力、学习、适应并在各种现实环境中进行准确预测的关键。

数据结构

数据结构 网络

网络 关系数据库管理系统 (RDBMS)

关系数据库管理系统 (RDBMS) 操作系统

操作系统 Java

Java iOS

iOS HTML

HTML CSS

CSS Android

Android Python

Python C语言编程

C语言编程 C++

C++ C#

C# MongoDB

MongoDB MySQL

MySQL Javascript

Javascript PHP

PHP