什么是ROC曲线及其在性能建模中的应用?

介绍

机器学习模型对于成功的AI实施至关重要,因为它们代表了人工智能的数学基础。我们的AI质量完全取决于驱动它的机器模型。我们需要一种方法来客观地评估机器学习模型的性能,并确定它是否适合使用。如果我们有一个ROC曲线,那就很有用了。

本文涵盖了我们需要了解的关于ROC曲线的所有内容。

ROC曲线

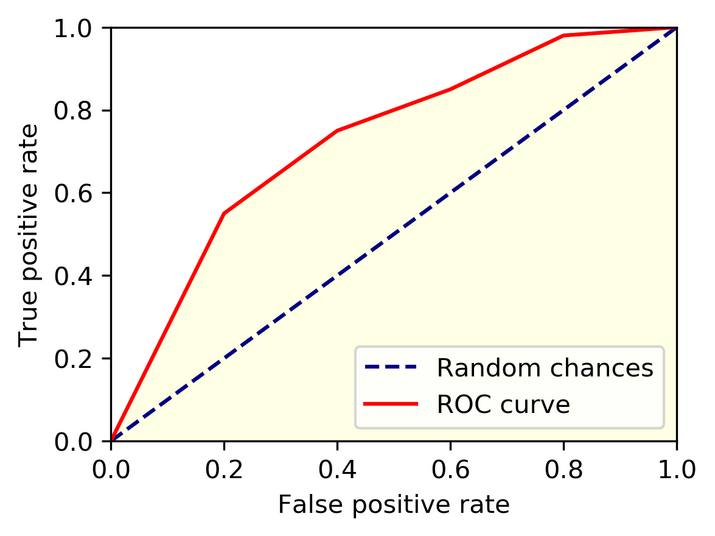

受试者工作特征(ROC)曲线是二元分类模型性能的图形表示。它绘制了在各种阈值设置下真阳性率(TPR)与假阳性率(FPR)的关系。ROC曲线是评估分类器性能的有用工具,因为它允许可视化模型的灵敏度和特异性之间的权衡。

在二元分类问题中,模型尝试根据一组输入特征预测观测值的类别。“正”和“负”通常是两个可能的类别标签。真阳性(TP)是指模型正确预测正类别的实例,而假阳性(FP)是指模型错误预测正类别的实例。类似地,真阴性(TN)是指模型正确预测负类别的实例。相反,假阴性(FN)是指模型错误预测负类别的实例。

TPR,也称为灵敏度或召回率,是在所有正实例中真阳性的比例。其计算公式为TP / (TP + FN)。FPR,也称为漏报率,是在所有负实例中假阳性的比例。其计算公式为FP / (FP + TN)。

在各种阈值设置下绘制模型的TPR与FPR的关系图,得到ROC曲线。通过阈值设置确定将实例分类为正例的概率阈值。例如,假设阈值设置为0.5。在这种情况下,预期概率大于0.5的实例将被分类为正实例,而预测概率小于0.5的实例将被分类为负实例。通过调整阈值,我们可以观察到当阈值变化时TPR和FPR之间的权衡是如何变化的。

ROC曲线是评估分类器有效性的有用工具,因为它可以直观地显示模型灵敏度和特异性之间的权衡。ROC曲线下面积(AUC)是一个常用的度量指标,用于评估分类器的整体性能。AUC值为1表示完美的分类器,而AUC值为0.5表示随机选择的分类器。如果模型的AUC接近1,则认为它是一个优秀的分类器;如果接近0.5,则认为它是一个差的分类器。

ROC曲线可以与分类器性能分析一起用于模型选择。比较不同的分类器时,AUC最高的分类器通常被认为是最好的。

模型性能假设

ROC曲线绘制了在各种阈值设置下真阳性率(TPR)与假阳性率(FPR)的关系。具有高TPR和低FPR的模型将具有贴近绘图左上角的ROC曲线,表明性能良好。

AUC衡量模型的整体性能,范围从0到1。完美运行并准确分类每个案例的模型的AUC为1。AUC为0.5的模型相当于随机猜测。0.5到1之间的AUC值表明模型优于猜测。更高的AUC值通常表示性能更好的模型。

除了ROC曲线和AUC之外,还可以使用其他评估指标(例如精度、召回率、F1分数和准确率)来确定模型的性能。

还应考虑问题的背景和应用程序的要求。例如,在某些情况下,精度可能比良好的召回率(灵敏度)更重要,反之亦然。还应在不同的测试数据集上进行模型性能评估,以避免过拟合并提供更准确的性能估计。

多类别模型的ROC曲线

受试者工作特征(ROC)曲线是二元分类器性能的图形表示。该曲线绘制了在各种阈值设置下真阳性率(TPR)与假阳性率(FPR)的关系。扩展多类别模型中ROC曲线分析的一种方法是使用一对多比较。每个类别都被视为正例,而所有其他类别都被视为负例。因此,ROC曲线的数量与类别的数量相同,并且每条曲线都显示分类器对特定类别的性能。还可以使用微平均和宏平均来组合所有类别的ROC。

结论

总而言之,ROC曲线是评估二元分类器效用的有用工具。在处理多类别模型时,一对多比较或使用微平均和宏平均组合所有类别的ROC可以扩展ROC曲线。强大的分类器将由于高真阳性率(TPR)和低假阳性率(FPR)而创建位于绘图左上角的ROC曲线。ROC曲线下面积(AUC)通常用作评估分类器性能的统计量,AUC越大表示性能越好。

数据结构

数据结构 网络

网络 关系数据库管理系统 (RDBMS)

关系数据库管理系统 (RDBMS) 操作系统

操作系统 Java

Java iOS

iOS HTML

HTML CSS

CSS Android

Android Python

Python C语言编程

C语言编程 C++

C++ C#

C# MongoDB

MongoDB MySQL

MySQL Javascript

Javascript PHP

PHP