- Beautiful Soup 教程

- Beautiful Soup - 首页

- Beautiful Soup - 概述

- Beautiful Soup - 网页抓取

- Beautiful Soup - 安装

- Beautiful Soup - 解析页面

- Beautiful Soup - 对象类型

- Beautiful Soup - 检查数据源

- Beautiful Soup - 抓取 HTML 内容

- Beautiful Soup - 通过标签导航

- Beautiful Soup - 通过 ID 查找元素

- Beautiful Soup - 通过 Class 查找元素

- Beautiful Soup - 通过属性查找元素

- Beautiful Soup - 搜索树结构

- Beautiful Soup - 修改树结构

- Beautiful Soup - 解析文档的一部分

- Beautiful Soup - 查找元素的所有子元素

- Beautiful Soup - 使用 CSS 选择器查找元素

- Beautiful Soup - 查找所有注释

- Beautiful Soup - 从 HTML 中抓取列表

- Beautiful Soup - 从 HTML 中抓取段落

- BeautifulSoup - 从 HTML 中抓取链接

- Beautiful Soup - 获取所有 HTML 标签

- Beautiful Soup - 获取标签内的文本

- Beautiful Soup - 查找所有标题

- Beautiful Soup - 提取标题标签

- Beautiful Soup - 提取电子邮件 ID

- Beautiful Soup - 抓取嵌套标签

- Beautiful Soup - 解析表格

- Beautiful Soup - 选择第 n 个子元素

- Beautiful Soup - 通过标签内的文本搜索

- Beautiful Soup - 移除 HTML 标签

- Beautiful Soup - 移除所有样式

- Beautiful Soup - 移除所有脚本

- Beautiful Soup - 移除空标签

- Beautiful Soup - 移除子元素

- Beautiful Soup - find 与 find_all 的区别

- Beautiful Soup - 指定解析器

- Beautiful Soup - 比较对象

- Beautiful Soup - 复制对象

- Beautiful Soup - 获取标签位置

- Beautiful Soup - 编码

- Beautiful Soup - 输出格式化

- Beautiful Soup - 美化输出

- Beautiful Soup - NavigableString 类

- Beautiful Soup - 将对象转换为字符串

- Beautiful Soup - 将 HTML 转换为文本

- Beautiful Soup - 解析 XML

- Beautiful Soup - 错误处理

- Beautiful Soup - 故障排除

- Beautiful Soup - 移植旧代码

- Beautiful Soup - 函数参考

- Beautiful Soup - contents 属性

- Beautiful Soup - children 属性

- Beautiful Soup - string 属性

- Beautiful Soup - strings 属性

- Beautiful Soup - stripped_strings 属性

- Beautiful Soup - descendants 属性

- Beautiful Soup - parent 属性

- Beautiful Soup - parents 属性

- Beautiful Soup - next_sibling 属性

- Beautiful Soup - previous_sibling 属性

- Beautiful Soup - next_siblings 属性

- Beautiful Soup - previous_siblings 属性

- Beautiful Soup - next_element 属性

- Beautiful Soup - previous_element 属性

- Beautiful Soup - next_elements 属性

- Beautiful Soup - previous_elements 属性

- Beautiful Soup - find 方法

- Beautiful Soup - find_all 方法

- Beautiful Soup - find_parents 方法

- Beautiful Soup - find_parent 方法

- Beautiful Soup - find_next_siblings 方法

- Beautiful Soup - find_next_sibling 方法

- Beautiful Soup - find_previous_siblings 方法

- Beautiful Soup - find_previous_sibling 方法

- Beautiful Soup - find_all_next 方法

- Beautiful Soup - find_next 方法

- Beautiful Soup - find_all_previous 方法

- Beautiful Soup - find_previous 方法

- Beautiful Soup - select 方法

- Beautiful Soup - append 方法

- Beautiful Soup - extend 方法

- Beautiful Soup - NavigableString 方法

- Beautiful Soup - new_tag 方法

- Beautiful Soup - insert 方法

- Beautiful Soup - insert_before 方法

- Beautiful Soup - insert_after 方法

- Beautiful Soup - clear 方法

- Beautiful Soup - extract 方法

- Beautiful Soup - decompose 方法

- Beautiful Soup - replace_with 方法

- Beautiful Soup - wrap 方法

- Beautiful Soup - unwrap 方法

- Beautiful Soup - smooth 方法

- Beautiful Soup - prettify 方法

- Beautiful Soup - encode 方法

- Beautiful Soup - decode 方法

- Beautiful Soup - get_text 方法

- Beautiful Soup - diagnose 方法

- Beautiful Soup 有用资源

- Beautiful Soup 快速指南

- Beautiful Soup - 有用资源

- Beautiful Soup - 讨论

Beautiful Soup 快速指南

Beautiful Soup - 概述

在当今世界,我们拥有大量非结构化数据/信息(主要是网络数据)可供免费使用。有时这些免费数据易于阅读,有时则不然。无论你的数据如何呈现,网页抓取都是一个非常有用的工具,可以将非结构化数据转换为更易于阅读和分析的结构化数据。换句话说,网页抓取是一种收集、整理和分析这些海量数据的方法。所以,让我们首先了解什么是网页抓取。

Beautiful Soup 简介

Beautiful Soup 是一个 Python 库,其名称来源于刘易斯·卡罗尔在《爱丽丝梦游仙境》中同名的一首诗。Beautiful Soup 是一个 Python 包,顾名思义,它解析不需要的数据,并通过修复不良 HTML 并以易于遍历的 XML 结构呈现给我们,从而帮助整理和格式化凌乱的网络数据。

简而言之,Beautiful Soup 是一个 Python 包,它允许我们从 HTML 和 XML 文档中提取数据。

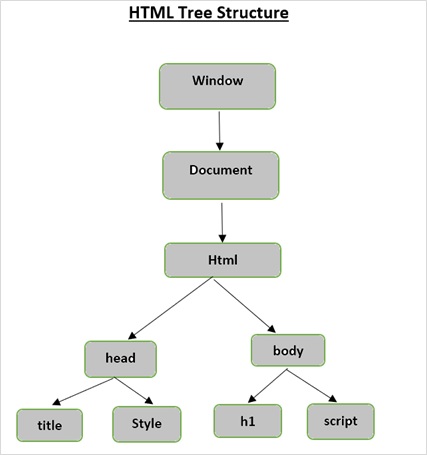

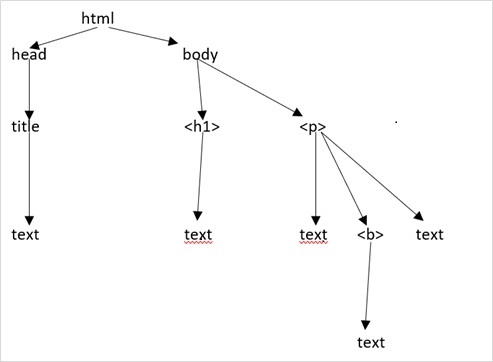

HTML 树结构

在深入了解 Beautiful Soup 提供的功能之前,让我们首先了解 HTML 树结构。

文档树中的根元素是 html,它可以有父节点、子节点和兄弟节点,这由它在树结构中的位置决定。要在 HTML 元素、属性和文本之间移动,必须在树结构中的节点之间移动。

假设网页如下所示:

它转换为以下 HTML 文档:

<html>

<head>

<title>TutorialsPoint</title>

</head>

<body>

<h1>Tutorialspoint Online Library</h1>

<p><b>It's all Free</b></p>

</body>

</html>

这仅仅意味着,对于上面的 HTML 文档,我们有如下 HTML 树结构:

Beautiful Soup - 网页抓取

抓取仅仅是一个提取(从各种来源)、复制和筛选数据的过程。

当我们从网络(例如从网页或网站)抓取或提取数据或 Feed 时,称为网页抓取。

因此,网页抓取(也称为网页数据提取或网页收集)是从网络中提取数据。简而言之,网页抓取为开发人员提供了一种从互联网收集和分析数据的方法。

为什么要进行网页抓取?

网页抓取提供了一种强大的工具来自动化人类在浏览时执行的大部分操作。企业以多种方式使用网页抓取:

研究数据

智能分析师(如研究人员或记者)使用网页抓取器,而不是手动从网站收集和清理数据。

产品、价格和受欢迎程度比较

目前有一些服务使用网页抓取器从众多在线网站收集数据,并将其用于比较产品的受欢迎程度和价格。

SEO 监控

有许多 SEO 工具,如 Ahrefs、Seobility、SEMrush 等,用于竞争对手分析和从客户网站提取数据。

搜索引擎

一些大型 IT 公司的业务完全依赖于网页抓取。

销售和营销

通过网页抓取收集的数据可供营销人员分析不同的细分市场和竞争对手,或供销售专家用于销售内容营销或社交媒体推广服务。

为什么选择 Python 进行网页抓取?

Python 是最流行的网页抓取语言之一,因为它可以非常轻松地处理大多数与网络爬取相关的任务。

以下是选择 Python 进行网页抓取的一些原因:

易用性

大多数开发人员都认为 Python 非常易于编码。我们不必在任何地方使用花括号“{}”或分号“;” ,这使得它在开发网页抓取器时更易于阅读和使用。

强大的库支持

Python 为不同的需求提供了大量的库,因此它适用于网页抓取以及数据可视化、机器学习等。

易于理解的语法

Python 是一种非常易读的编程语言,因为 Python 语法易于理解。Python 非常具有表现力,代码缩进帮助用户区分代码中的不同块或范围。

动态类型语言

Python 是一种动态类型语言,这意味着分配给变量的数据会告诉我们它是什么类型的变量。它节省了大量时间,并使工作更快。

庞大的社区

Python 社区非常庞大,无论你在编写代码时遇到什么问题,都可以获得帮助。

Beautiful Soup - 安装

Beautiful Soup 是一个库,它简化了从网页抓取信息的过程。它位于 HTML 或 XML 解析器的顶部,提供了 Python 风格的习惯用法来迭代、搜索和修改解析树。

BeautifulSoup 包不是 Python 标准库的一部分,因此必须安装它。在安装最新版本之前,让我们根据 Python 的推荐方法创建一个虚拟环境。

虚拟环境允许我们为特定项目创建 Python 的隔离工作副本,而不会影响外部设置。

我们将使用 Python 标准库中的 venv 模块来创建虚拟环境。PIP 默认包含在 Python 3.4 或更高版本中。

使用以下命令在 Windows 上创建虚拟环境

C:\uses\user\>python -m venv myenv

在 Ubuntu Linux 上,在创建虚拟环境之前,如果需要,请更新 APT 存储库并安装 venv

mvl@GNVBGL3:~ $ sudo apt update && sudo apt upgrade -y mvl@GNVBGL3:~ $ sudo apt install python3-venv

然后使用以下命令创建虚拟环境

mvl@GNVBGL3:~ $ sudo python3 -m venv myenv

你需要激活虚拟环境。在 Windows 上使用以下命令

C:\uses\user\>cd myenv C:\uses\user\myenv>scripts\activate (myenv) C:\Users\users\user\myenv>

在 Ubuntu Linux 上,使用以下命令激活虚拟环境

mvl@GNVBGL3:~$ cd myenv mvl@GNVBGL3:~/myenv$ source bin/activate (myenv) mvl@GNVBGL3:~/myenv$

虚拟环境的名称显示在括号中。现在它已激活,我们可以在其中安装 BeautifulSoup 了。

(myenv) mvl@GNVBGL3:~/myenv$ pip3 install beautifulsoup4

Collecting beautifulsoup4

Downloading beautifulsoup4-4.12.2-py3-none-any.whl (142 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

143.0/143.0 KB 325.2 kB/s eta 0:00:00

Collecting soupsieve>1.2

Downloading soupsieve-2.4.1-py3-none-any.whl (36 kB)

Installing collected packages: soupsieve, beautifulsoup4

Successfully installed beautifulsoup4-4.12.2 soupsieve-2.4.1

请注意,Beautifulsoup4 的最新版本是 4.12.2,需要 Python 3.8 或更高版本。

如果你没有安装 easy_install 或 pip,可以下载 Beautiful Soup 4 源代码压缩包并使用 setup.py 安装它。

(myenv) mvl@GNVBGL3:~/myenv$ python setup.py install

要检查 Beautifulsoup 是否已正确安装,请在 Python 终端中输入以下命令:

>>> import bs4 >>> bs4.__version__ '4.12.2'

如果安装不成功,你将收到 ModuleNotFoundError 错误。

你还需要安装 requests 库。它是 Python 的 HTTP 库。

pip3 install requests

安装解析器

默认情况下,Beautiful Soup 支持 Python 标准库中包含的 HTML 解析器,但它也支持许多外部第三方 Python 解析器,如 lxml 解析器或 html5lib 解析器。

要安装 lxml 或 html5lib 解析器,请使用以下命令

pip3 install lxml pip3 install html5lib

这些解析器各有优缺点,如下所示:

解析器:Python 的 html.parser

用法 − BeautifulSoup(markup, "html.parser")

优点

- 内置

- 速度不错

- 宽容(从 Python 3.2 开始)

缺点

- 速度不如 lxml,宽容度不如 html5lib。

解析器:lxml 的 HTML 解析器

用法 − BeautifulSoup(markup, "lxml")

优点

- 非常快

- 宽松的

缺点

-

外部 C 依赖

解析器:lxml 的 XML 解析器

用法 − BeautifulSoup(markup, "lxml-xml")

或 BeautifulSoup(markup, "xml")

优点

- 非常快

- 目前唯一支持的 XML 解析器

缺点

- 外部 C 依赖

解析器:html5lib

用法 − BeautifulSoup(markup, "html5lib")

优点

- 极其宽松

- 以与网络浏览器相同的方式解析页面

- 创建有效的 HTML5

缺点

- 非常慢

- 外部 Python 依赖

Beautiful Soup - 解析页面

现在是时候在一个 html 页面中测试我们的 Beautiful Soup 包了(以网页 - https://tutorialspoint.com/index.htm 为例,您可以选择任何其他网页)并从中提取一些信息。

在下面的代码中,我们尝试从网页中提取标题 -

示例

from bs4 import BeautifulSoup import requests url = "https://tutorialspoint.com/index.htm" req = requests.get(url) soup = BeautifulSoup(req.content, "html.parser") print(soup.title)

输出

<title>Online Courses and eBooks Library<title>

一个常见的任务是从网页中提取所有 URL。为此,我们只需要添加下面的代码行 -

for link in soup.find_all('a'):

print(link.get('href'))

输出

下面显示了上述循环的部分输出 -

https://tutorialspoint.com/index.htm https://tutorialspoint.com/codingground.htm https://tutorialspoint.com/about/about_careers.htm https://tutorialspoint.com/whiteboard.htm https://tutorialspoint.com/online_dev_tools.htm https://tutorialspoint.com/business/index.asp https://tutorialspoint.com/market/teach_with_us.jsp https://#/tutorialspointindia https://www.instagram.com/tutorialspoint_/ https://twitter.com/tutorialspoint https://www.youtube.com/channel/UCVLbzhxVTiTLiVKeGV7WEBg https://tutorialspoint.com/categories/development https://tutorialspoint.com/categories/it_and_software https://tutorialspoint.com/categories/data_science_and_ai_ml https://tutorialspoint.com/categories/cyber_security https://tutorialspoint.com/categories/marketing https://tutorialspoint.com/categories/office_productivity https://tutorialspoint.com/categories/business https://tutorialspoint.com/categories/lifestyle https://tutorialspoint.com/latest/prime-packs https://tutorialspoint.com/market/index.asp https://tutorialspoint.com/latest/ebooks … …

要解析本地当前工作目录中存储的网页,请获取指向 html 文件的文件对象,并将其用作 BeautifulSoup() 构造函数的参数。

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

print(soup)

输出

<html> <head> <title>Hello World</title> </head> <body> <h1 style="text-align:center;">Hello World</h1> </body> </html>

您还可以使用包含 HTML 脚本的字符串作为构造函数的参数,如下所示 -

from bs4 import BeautifulSoup

html = '''

<html>

<head>

<title>Hello World</title>

</head>

<body>

<h1 style="text-align:center;">Hello World</h1>

</body>

</html>

'''

soup = BeautifulSoup(html, 'html.parser')

print(soup)

Beautiful Soup 使用最佳可用的解析器来解析文档。除非另有指定,否则它将使用 HTML 解析器。

Beautiful Soup - 对象类型

当我们将 html 文档或字符串传递给 beautifulsoup 构造函数时,beautifulsoup 基本上将复杂的 html 页面转换为不同的 python 对象。下面我们将讨论 bs4 包中定义的四种主要类型的对象。

- 标签

- 可导航字符串

- BeautifulSoup

- 注释

标签对象

HTML 标签用于定义各种类型的內容。BeautifulSoup 中的标签对象对应于实际页面或文档中的 HTML 或 XML 标签。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<b class="boldest">TutorialsPoint</b>', 'lxml')

tag = soup.html

print (type(tag))

输出

<class 'bs4.element.Tag'>

标签包含许多属性和方法,标签的两个重要特征是其名称和属性。

名称 (tag.name)

每个标签都包含一个名称,可以通过“.name”作为后缀来访问。tag.name 将返回它所属的标签类型。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<b class="boldest">TutorialsPoint</b>', 'lxml')

tag = soup.html

print (tag.name)

输出

html

但是,如果我们更改标签名称,则 BeautifulSoup 生成的 HTML 标记中也会反映出来。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<b class="boldest">TutorialsPoint</b>', 'lxml')

tag = soup.html

tag.name = "strong"

print (tag)

输出

<strong><body><b class="boldest">TutorialsPoint</b></body></strong>

属性 (tag.attrs)

一个标签对象可以具有任意数量的属性。在上面的示例中,标签<b class="boldest">具有一个名为“class”的属性,其值为“boldest”。任何不是标签的东西,基本上都是一个属性,并且必须包含一个值。“attrs”返回属性及其值的字典。您也可以通过访问键来访问属性。

在下面的示例中,Beautifulsoup() 构造函数的字符串参数包含 HTML 输入标签。“attr”返回输入标签的属性。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<input type="text" name="name" value="Raju">', 'lxml')

tag = soup.input

print (tag.attrs)

输出

{'type': 'text', 'name': 'name', 'value': 'Raju'}

我们可以使用字典运算符或方法对标签的属性进行各种修改(添加/删除/修改)。

在下面的示例中,更新了 value 标签。更新后的 HTML 字符串显示了更改。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<input type="text" name="name" value="Raju">', 'lxml')

tag = soup.input

print (tag.attrs)

tag['value']='Ravi'

print (soup)

输出

<html><body><input name="name" type="text" value="Ravi"/></body></html>

我们添加了一个新的 id 标签,并删除了 value 标签。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup('<input type="text" name="name" value="Raju">', 'lxml')

tag = soup.input

tag['id']='nm'

del tag['value']

print (soup)

输出

<html><body><input id="nm" name="name" type="text"/></body></html>

多值属性

某些 HTML5 属性可以具有多个值。最常用的是 class 属性,它可以具有多个 CSS 值。其他包括“rel”、“rev”、“headers”、“accesskey”和“accept-charset”。Beautiful Soup 中的多值属性显示为列表。

示例

from bs4 import BeautifulSoup

css_soup = BeautifulSoup('<p class="body"></p>', 'lxml')

print ("css_soup.p['class']:", css_soup.p['class'])

css_soup = BeautifulSoup('<p class="body bold"></p>', 'lxml')

print ("css_soup.p['class']:", css_soup.p['class'])

输出

css_soup.p['class']: ['body'] css_soup.p['class']: ['body', 'bold']

但是,如果任何属性包含多个值,但它不是任何版本的 HTML 标准的多值属性,则 Beautiful Soup 将保留该属性 -

示例

from bs4 import BeautifulSoup

id_soup = BeautifulSoup('<p id="body bold"></p>', 'lxml')

print ("id_soup.p['id']:", id_soup.p['id'])

print ("type(id_soup.p['id']):", type(id_soup.p['id']))

输出

id_soup.p['id']: body bold type(id_soup.p['id']): <class 'str'>

可导航字符串对象

通常,某个字符串放置在某种类型的开始和结束标签中。浏览器的 HTML 引擎在呈现元素时会对字符串应用预期的效果。例如,在<b>Hello World</b>中,您会在<b>和</b>标签中间找到一个字符串,以便以粗体显示。

可导航字符串对象表示标签的内容。它是 bs4.element.NavigableString 类的对象。要访问内容,请将标签与“.string”一起使用。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<h2 id='message'>Hello, Tutorialspoint!</h2>", 'html.parser')

print (soup.string)

print (type(soup.string))

输出

Hello, Tutorialspoint! <class 'bs4.element.NavigableString'>

可导航字符串对象类似于 Python Unicode 字符串。它的一些功能支持遍历树和搜索树。可导航字符串可以使用 str() 函数转换为 Unicode 字符串。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<h2 id='message'>Hello, Tutorialspoint!</h2>",'html.parser')

tag = soup.h2

string = str(tag.string)

print (string)

输出

Hello, Tutorialspoint!

就像 Python 字符串是不可变的,可导航字符串也不能就地修改。但是,使用 replace_with() 将标签的内部字符串替换为另一个字符串。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<h2 id='message'>Hello, Tutorialspoint!</h2>",'html.parser')

tag = soup.h2

tag.string.replace_with("OnLine Tutorials Library")

print (tag.string)

输出

OnLine Tutorials Library

BeautifulSoup 对象

BeautifulSoup 对象表示整个已解析的对象。但是,可以认为它类似于 Tag 对象。当我们尝试抓取 Web 资源时创建的对象。因为它类似于 Tag 对象,所以它支持解析和搜索文档树所需的功能。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

print (soup)

print (soup.name)

print ('type:',type(soup))

输出

<html> <head> <title>TutorialsPoint</title> </head> <body> <h2>Departmentwise Employees</h2> <ul> <li>Accounts</li> <ul> <li>Anand</li> <li>Mahesh</li> </ul> <li>HR</li> <ul> <li>Rani</li> <li>Ankita</li> </ul> </ul> </body> </html> [document] type: <class 'bs4.BeautifulSoup'>

BeautifulSoup 对象的 name 属性始终返回 [document]。

如果将 BeautifulSoup 对象作为参数传递给某个函数(例如 replace_with()),则可以组合两个已解析的文档。

示例

from bs4 import BeautifulSoup

obj1 = BeautifulSoup("<book><title>Python</title></book>", features="xml")

obj2 = BeautifulSoup("<b>Beautiful Soup parser</b>", "lxml")

obj2.find('b').replace_with(obj1)

print (obj2)

输出

<html><body><book><title>Python</title></book></body></html>

注释对象

HTML 和 XML 文档中<!-- 和 -->之间编写的任何文本都被视为注释。BeautifulSoup 可以将此类注释文本检测为 Comment 对象。

示例

from bs4 import BeautifulSoup markup = "<b><!--This is a comment text in HTML--></b>" soup = BeautifulSoup(markup, 'html.parser') comment = soup.b.string print (comment, type(comment))

输出

This is a comment text in HTML <class 'bs4.element.Comment'>

Comment 对象是一种特殊类型的 NavigableString 对象。prettify() 方法以特殊格式显示注释文本 -

示例

print (soup.b.prettify())

输出

<b> <!--This is a comment text in HTML--> </b>

Beautiful Soup - 检查数据源

为了使用 BeautifulSoup 和 Python 抓取网页,任何 Web 抓取项目的第一步都应该是探索您想要抓取的网站。因此,首先访问该网站以了解站点结构,然后开始提取与您相关的的信息。

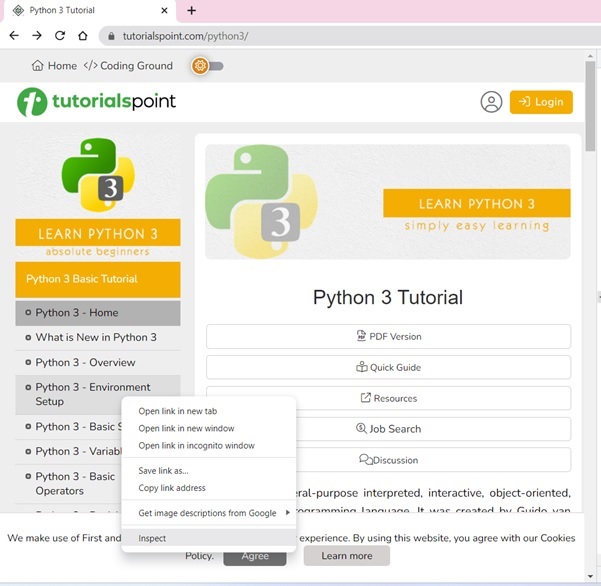

让我们访问 TutorialsPoint 的 Python 教程主页。在浏览器中打开https://tutorialspoint.com/python3/index.htm。

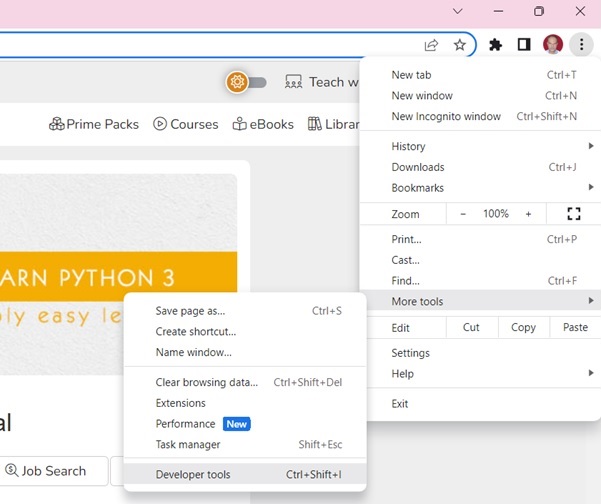

使用开发者工具可以帮助您了解网站的结构。所有现代浏览器都安装了开发者工具。

如果使用 Chrome 浏览器,请从右上角菜单按钮 (⋮) 打开开发者工具,然后选择更多工具 → 开发者工具。

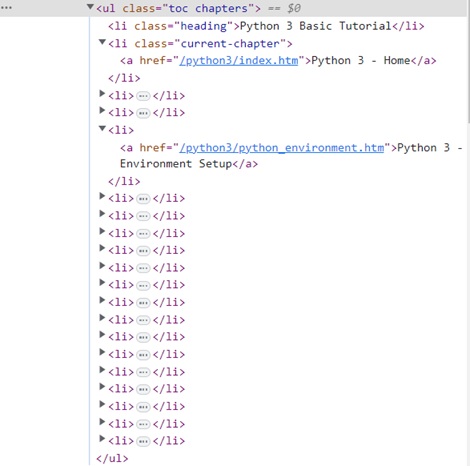

使用开发者工具,您可以浏览站点的文档对象模型 (DOM) 以更好地理解您的源代码。在开发者工具中选择“元素”选项卡。您将看到一个包含可点击 HTML 元素的结构。

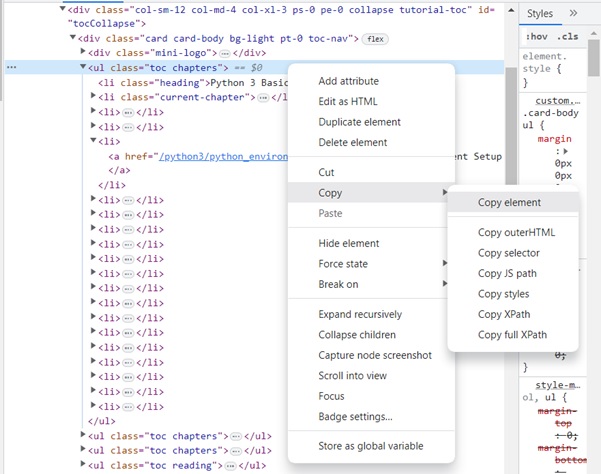

教程页面在左侧边栏中显示了目录。右键单击任何章节,然后选择“检查”选项。

对于“元素”选项卡,找到对应于 TOC 列表的标签,如下面的图所示 -

右键单击 HTML 元素,复制 HTML 元素,并将其粘贴到任何编辑器中。

现在获得了<ul>..</ul>元素的 HTML 脚本。

<ul class="toc chapters"> <li class="heading">Python 3 Basic Tutorial</li> <li class="current-chapter"><a href="/python3/index.htm">Python 3 - Home</a></li> <li><a href="/python3/python3_whatisnew.htm">What is New in Python 3</a></li> <li><a href="/python3/python_overview.htm">Python 3 - Overview</a></li> <li><a href="/python3/python_environment.htm">Python 3 - Environment Setup</a></li> <li><a href="/python3/python_basic_syntax.htm">Python 3 - Basic Syntax</a></li> <li><a href="/python3/python_variable_types.htm">Python 3 - Variable Types</a></li> <li><a href="/python3/python_basic_operators.htm">Python 3 - Basic Operators</a></li> <li><a href="/python3/python_decision_making.htm">Python 3 - Decision Making</a></li> <li><a href="/python3/python_loops.htm">Python 3 - Loops</a></li> <li><a href="/python3/python_numbers.htm">Python 3 - Numbers</a></li> <li><a href="/python3/python_strings.htm">Python 3 - Strings</a></li> <li><a href="/python3/python_lists.htm">Python 3 - Lists</a></li> <li><a href="/python3/python_tuples.htm">Python 3 - Tuples</a></li> <li><a href="/python3/python_dictionary.htm">Python 3 - Dictionary</a></li> <li><a href="/python3/python_date_time.htm">Python 3 - Date & Time</a></li> <li><a href="/python3/python_functions.htm">Python 3 - Functions</a></li> <li><a href="/python3/python_modules.htm">Python 3 - Modules</a></li> <li><a href="/python3/python_files_io.htm">Python 3 - Files I/O</a></li> <li><a href="/python3/python_exceptions.htm">Python 3 - Exceptions</a></li> </ul>

我们现在可以将此脚本加载到 BeautifulSoup 对象中以解析文档树。

Beautiful Soup - 抓取 HTML 内容

从网站提取数据的过程称为 Web 抓取。网页可能包含 url、电子邮件地址、图像或任何其他内容,我们可以将其存储在文件或数据库中。手动搜索网站是一个繁琐的过程。有不同的 Web 抓取工具可以自动化此过程。

有时,使用“robots.txt”文件会禁止 Web 抓取。一些受欢迎的网站提供 API 以结构化的方式访问其数据。不道德的 Web 抓取可能会导致您的 IP 被阻止。

Python 广泛用于 Web 抓取。Python 标准库具有 urllib 包,可用于从 HTML 页面提取数据。由于 urllib 模块与标准库捆绑在一起,因此无需安装。

urllib 包是 Python 编程语言的 HTTP 客户端。urllib.request 模块在我们想要打开和读取 URL 时很有用。urllib 包中的其他模块有 -

urllib.error 定义了 urllib.request 命令引发的异常和错误。

urllib.parse 用于解析 URL。

urllib.robotparser 用于解析 robots.txt 文件。

使用 urllib 模块中的 urlopen() 函数从网站读取网页内容。

import urllib.request

response = urllib.request.urlopen('https://pythonlang.cn/')

html = response.read()

您也可以为此目的使用 requests 库。您需要先安装它才能使用。

pip3 install requests

在下面的代码中,抓取了https://tutorialspoint.com的主页 -

from bs4 import BeautifulSoup import requests url = "https://tutorialspoint.com/index.htm" req = requests.get(url)

然后使用 Beautiful Soup 解析通过上述两种方法中的任何一种获得的内容。

Beautiful Soup - 通过标签导航

任何 HTML 文档中重要的元素之一是标签,它们可能包含其他标签/字符串(标签的子元素)。Beautiful Soup 提供了不同的方法来导航和迭代标签的子元素。

搜索解析树最简单的方法是按名称搜索标签。

soup.head

soup.head 函数返回放在 HTML 页面<head> .. </head>元素内部的内容。

Consider the following HTML page to be scraped:

<html>

<head>

<title>TutorialsPoint</title>

<script>

document.write("Welcome to TutorialsPoint");

</script>

</head>

<body>

<h1>Tutorialspoint Online Library</h1>

<p><b>It's all Free</b></p>

</body>

</html>

以下代码提取<head>元素的内容

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

print(soup.head)

输出

<head>

<title>TutorialsPoint</title>

<script>

document.write("Welcome to TutorialsPoint");

</script>

</head>

soup.body

类似地,要返回 HTML 页面的 body 部分的内容,请使用 soup.body

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

print (soup.body)

输出

<body> <h1>Tutorialspoint Online Library</h1> <p><b>It's all Free</b></p> </body>

您还可以提取<body>标签中的特定标签(如第一个<h1>标签)。

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

print(soup.body.h1)

输出

<h1>Tutorialspoint Online Library</h1>

soup.p

我们的 HTML 文件包含一个<p>标签。我们可以提取此标签的内容

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

print(soup.p)

输出

<p><b>It's all Free</b></p>

Tag.contents

Tag 对象可能具有一个或多个 PageElements。Tag 对象的 contents 属性返回其中包含的所有元素的列表。

让我们在 index.html 文件的<head>标签中找到元素。

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

tag = soup.head

print (tag.contents)

输出

['\n',

<title>TutorialsPoint</title>,

'\n',

<script>

document.write("Welcome to TutorialsPoint");

</script>,

'\n']

Tag.children

HTML 脚本中标签的结构是分层的。元素嵌套在另一个元素内部。例如,顶级<HTML>标签包含<HEAD>和<BODY>标签,每个标签都可能包含其他标签。

Tag 对象具有一个 children 属性,该属性返回一个列表迭代器对象,其中包含封闭的 PageElements。

为了演示 children 属性,我们将使用以下 HTML 脚本 (index.html)。在<body>部分,有两个<ul>列表元素,一个嵌套在另一个内部。换句话说,body 标签具有顶级列表元素,每个列表元素在其下方都有另一个列表。

<html>

<head>

<title>TutorialsPoint</title>

</head>

<body>

<h2>Departmentwise Employees</h2>

<ul>

<li>Accounts</li>

<ul>

<li>Anand</li>

<li>Mahesh</li>

</ul>

<li>HR</li>

<ul>

<li>Rani</li>

<li>Ankita</li>

</ul>

</ul>

</body>

</html>

以下 Python 代码给出了顶级<ul>标签的所有子元素的列表。

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

tag = soup.ul

print (list(tag.children))

输出

['\n', <li>Accounts</li>, '\n', <ul> <li>Anand</li> <li>Mahesh</li> </ul>, '\n', <li>HR</li>, '\n', <ul> <li>Rani</li> <li>Ankita</li> </ul>, '\n']

由于 .children 属性返回一个列表迭代器,因此我们可以使用 for 循环来遍历层次结构。

示例

for child in tag.children: print (child)

输出

<li>Accounts</li> <ul> <li>Anand</li> <li>Mahesh</li> </ul> <li>HR</li> <ul> <li>Rani</li> <li>Ankita</li> </ul>

Tag.find_all()

此方法返回与提供的参数标签匹配的所有标签内容的结果集。

让我们考虑以下 HTML 页面 (index.html) -

<html>

<body>

<h1>Tutorialspoint Online Library</h1>

<p><b>It's all Free</b></p>

<a class="prog" href="https://tutorialspoint.com/java/java_overview.htm" id="link1">Java</a>

<a class="prog" href="https://tutorialspoint.com/cprogramming/index.htm" id="link2">C</a>

<a class="prog" href="https://tutorialspoint.com/python/index.htm" id="link3">Python</a>

<a class="prog" href="https://tutorialspoint.com/javascript/javascript_overview.htm" id="link4">JavaScript</a>

<a class="prog" href="https://tutorialspoint.com/ruby/index.htm" id="link5">C</a>

</body>

</html>

以下代码列出了所有具有<a>标签的元素

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

result = soup.find_all("a")

print (result)

输出

[ <a class="prog" href="https://tutorialspoint.com/java/java_overview.htm" id="link1">Java</a>, <a class="prog" href="https://tutorialspoint.com/cprogramming/index.htm" id="link2">C</a>, <a class="prog" href="https://tutorialspoint.com/python/index.htm" id="link3">Python</a>, <a class="prog" href="https://tutorialspoint.com/javascript/javascript_overview.htm" id="link4">JavaScript</a>, <a class="prog" href="https://tutorialspoint.com/ruby/index.htm" id="link5">C</a> ]

Beautiful Soup - 通过 ID 查找元素

在 HTML 文档中,通常每个元素都分配一个唯一的 ID。这使得可以通过前端代码(如 JavaScript 函数)提取元素的值。

使用 BeautifulSoup,您可以通过其 ID 找到给定元素的内容。可以通过两种方法实现此目的 - find() 和 find_all(),以及 select()

使用 find() 方法

BeautifulSoup 对象的 find() 方法搜索第一个满足作为参数给定条件的元素。

让我们为此目的使用以下 HTML 脚本(作为 index.html)

<html>

<head>

<title>TutorialsPoint</title>

</head>

<body>

<form>

<input type = 'text' id = 'nm' name = 'name'>

<input type = 'text' id = 'age' name = 'age'>

<input type = 'text' id = 'marks' name = 'marks'>

</form>

</body>

</html>

以下 Python 代码查找其 id 为 nm 的元素

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.find(id = 'nm')

print (obj)

输出

<input id="nm" name="name" type="text"/>

使用 find_all()

find_all() 方法也接受一个 filter 参数。它返回具有给定 id 的所有元素的列表。在某些 HTML 文档中,通常只有一个具有特定 id 的元素。因此,使用 find() 而不是 find_all() 更适合搜索给定的 id。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.find_all(id = 'nm')

print (obj)

输出

[<input id="nm" name="name" type="text"/>]

请注意,find_all() 方法返回一个列表。find_all() 方法还有一个 limit 参数。将 find_all() 的 limit 设置为 1 等效于 find()

obj = soup.find_all(id = 'nm', limit=1)

使用 select() 方法

BeautifulSoup 类中的 select() 方法接受 CSS 选择器作为参数。# 符号是 id 的 CSS 选择器。它后面跟着所需 id 的值传递给 select() 方法。它的作用与 find_all() 方法相同。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.select("#nm")

print (obj)

输出

[<input id="nm" name="name" type="text"/>]

使用 select_one()

与 find_all() 方法类似,select() 方法也返回一个列表。还有一个 select_one() 方法用于返回给定参数的第一个标签。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.select_one("#nm")

print (obj)

输出

<input id="nm" name="name" type="text"/>

Beautiful Soup - 通过 Class 查找元素

CSS(层叠样式表)是用于设计 HTML 元素外观的工具。CSS 规则控制 HTML 元素的不同方面,例如大小、颜色、对齐方式等。应用样式比定义 HTML 元素属性更有效。您可以将样式规则应用于每个 HTML 元素。与其分别对每个元素应用样式,不如使用 CSS 类将类似的样式应用于 HTML 元素组,以实现统一的网页外观。在 BeautifulSoup 中,可以找到使用 CSS 类设置样式的标签。在本章中,我们将使用以下方法搜索指定 CSS 类的元素:

- find_all() 和 find() 方法

- select() 和 select_one() 方法

CSS 中的类

CSS 中的类是指定与外观相关的不同特征(例如字体类型、大小和颜色、背景颜色、对齐方式等)的属性的集合。声明类时,类名前缀为点(.)。

.class {

css declarations;

}

CSS 类可以内联定义,也可以在需要包含在 HTML 脚本中的单独 css 文件中定义。CSS 类的典型示例如下:

.blue-text {

color: blue;

font-weight: bold;

}

您可以借助以下 BeautifulSoup 方法搜索使用特定类样式定义的 HTML 元素。

出于本章的目的,我们将使用以下 HTML 页面:

<html>

<head>

<title>TutorialsPoint</title>

</head>

<body>

<h2 class="heading">Departmentwise Employees</h2>

<ul>

<li class="mainmenu">Accounts</li>

<ul>

<li class="submenu">Anand</li>

<li class="submenu">Mahesh</li>

</ul>

<li class="mainmenu">HR</li>

<ul>

<li class="submenu">Rani</li>

<li class="submenu">Ankita</li>

</ul>

</ul>

</body>

</html>

使用 find() 和 find_all()

要搜索标签中使用的特定 CSS 类的元素,请使用 Tag 对象的attrs 属性,如下所示:

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.find_all(attrs={"class": "mainmenu"})

print (obj)

输出

[<li class="mainmenu">Accounts</li>, <li class="mainmenu">HR</li>]

结果是所有具有 mainmenu 类的元素的列表

要获取 attrs 属性中提到的任何 CSS 类的元素列表,请将 find_all() 语句更改为:

obj = soup.find_all(attrs={"class": ["mainmenu", "submenu"]})

这将生成一个包含上面使用的任何 CSS 类的所有元素的列表。

[ <li class="mainmenu">Accounts</li>, <li class="submenu">Anand</li>, <li class="submenu">Mahesh</li>, <li class="mainmenu">HR</li>, <li class="submenu">Rani</li>, <li class="submenu">Ankita</li> ]

使用 select() 和 select_one()

您还可以使用 select() 方法,并将 CSS 选择器作为参数。点(.) 符号后跟类名用作 CSS 选择器。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.select(".heading")

print (obj)

输出

[<h2 class="heading">Departmentwise Employees</h2>]

select_one() 方法返回使用给定类找到的第一个元素。

obj = soup.select_one(".submenu")

Beautiful Soup - 通过属性查找元素

find() 和 find_all() 方法都旨在根据传递给这些方法的参数查找文档中一个或所有标签。您可以将 attrs 参数传递给这些函数。attrs 的值必须是一个字典,其中包含一个或多个标签属性及其值。

为了检查这些方法的行为,我们将使用以下 HTML 文档 (index.html)

<html>

<head>

<title>TutorialsPoint</title>

</head>

<body>

<form>

<input type = 'text' id = 'nm' name = 'name'>

<input type = 'text' id = 'age' name = 'age'>

<input type = 'text' id = 'marks' name = 'marks'>

</form>

</body>

</html>

使用 find_all()

以下程序返回所有具有 input type="text" 属性的标签的列表。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.find_all(attrs={"type":'text'})

print (obj)

输出

[<input id="nm" name="name" type="text"/>, <input id="age" name="age" type="text"/>, <input id="marks" name="marks" type="text"/>]

使用 find()

find() 方法返回已解析文档中第一个具有给定属性的标签。

obj = soup.find(attrs={"name":'marks'})

使用 select()

select() 方法可以通过将要比较的属性作为参数来调用。属性必须放在列表对象中。它返回所有具有给定属性的标签的列表。

在以下代码中,select() 方法返回所有具有 type 属性的标签。

示例

from bs4 import BeautifulSoup

fp = open("index.html")

soup = BeautifulSoup(fp, 'html.parser')

obj = soup.select("[type]")

print (obj)

输出

[<input id="nm" name="name" type="text"/>, <input id="age" name="age" type="text"/>, <input id="marks" name="marks" type="text"/>]

使用 select_one()

select_one() 方法与此类似,只是它返回满足给定过滤器的第一个标签。

obj = soup.select_one("[name='marks']")

输出

<input id="marks" name="marks" type="text"/>

Beautiful Soup - 搜索树结构

在本章中,我们将讨论 Beautiful Soup 中的不同方法,用于以不同方向遍历 HTML 文档树——向上和向下、左右以及来回。

我们将在本章的所有示例中使用以下 HTML 字符串:

html = """

<html><head><title>TutorialsPoint</title></head>

<body>

<p class="title"><b>Online Tutorials Library</b></p>

<p class="story">TutorialsPoint has an excellent collection of tutorials on:

<a href="https://tutorialspoint.com/Python" class="lang" id="link1">Python</a>,

<a href="https://tutorialspoint.com/Java" class="lang" id="link2">Java</a> and

<a href="https://tutorialspoint.com/PHP" class="lang" id="link3">PHP</a>;

Enhance your Programming skills.</p>

<p class="tutorial">...</p>

"""

所需标签的名称允许您导航解析树。例如 soup.head 将为您获取 <head> 元素:

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') print (soup.head.prettify())

输出

<head>

<title>

TutorialsPoint

</title>

</head>

向下

一个标签可能包含在其内封闭的字符串或其他标签。Tag 对象的 .contents 属性返回属于它的所有子元素的列表。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.head print (list(tag.children))

输出

[<title>TutorialsPoint</title>]

返回的对象是一个列表,尽管在这种情况下,head 元素中只包含一个子标签。

.children

.children 属性也返回标签中所有封闭元素的列表。下面,body 标签中的所有元素都作为列表给出。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.body print (list(tag.children))

输出

['\n', <p class="title"><b>Online Tutorials Library</b></p>, '\n', <p class="story">TutorialsPoint has an excellent collection of tutorials on: <a class="lang" href="https://tutorialspoint.com/Python" id="link1">Python</a>, <a class="lang" href="https://tutorialspoint.com/Java" id="link2">Java</a> and <a class="lang" href="https://tutorialspoint.com/PHP" id="link3">PHP</a>; Enhance your Programming skills.</p>, '\n', <p class="tutorial">...</p>, '\n']

您可以使用 .children 生成器迭代标签的子元素,而不是将它们作为列表获取:

示例

tag = soup.body for child in tag.children: print (child)

输出

<p class="title"><b>Online Tutorials Library</b></p> <p class="story">TutorialsPoint has an excellent collection of tutorials on: <a class="lang" href="https://tutorialspoint.com/Python" id="link1">Python</a>, <a class="lang" href="https://tutorialspoint.com/Java" id="link2">Java</a> and <a class="lang" href="https://tutorialspoint.com/PHP" id="link3">PHP</a>; Enhance your Programming skills.</p> <p class="tutorial">...</p>

.descendents

.contents 和 .children 属性仅考虑标签的直接子元素。.descendants 属性允许您递归地迭代标签的所有子元素:它的直接子元素、其直接子元素的子元素,依此类推。

BeautifulSoup 对象位于所有标签层次结构的顶部。因此,它的 .descendents 属性包含 HTML 字符串中的所有元素。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') print (soup.descendants)

.descendents 属性返回一个生成器,可以使用 for 循环进行迭代。在这里,我们列出 head 标签的后代。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.head for element in tag.descendants: print (element)

输出

<title>TutorialsPoint</title> TutorialsPoint

head 标签包含一个 title 标签,该标签又包含一个 NavigableString 对象 TutorialsPoint。<head> 标签只有一个子元素,但它有两个后代:<title> 标签和 <title> 标签的子元素。但是 BeautifulSoup 对象只有一个直接子元素(<html> 标签),但它有许多后代。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tags = list(soup.descendants) print (len(tags))

输出

27

向上

就像您可以使用 children 和 descendents 属性导航文档的下游一样,BeautifulSoup 提供 .parent 和 .parent 属性来导航标签的上游

.parent

每个标签和每个字符串都有一个包含它的父标签。您可以使用 parent 属性访问元素的父元素。在我们的示例中,<head> 标签是 <title> 标签的父元素。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.title print (tag.parent)

输出

<head><title>TutorialsPoint</title></head>

由于 title 标签包含一个字符串(NavigableString),因此字符串的父元素是 title 标签本身。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.title string = tag.string print (string.parent)

输出

<title>TutorialsPoint</title>

.parents

您可以使用 .parents 迭代元素的所有父元素。此示例使用 .parents 从文档深处隐藏的 <a> 标签遍历到文档的最顶部。在以下代码中,我们跟踪示例 HTML 字符串中第一个 <a> 标签的父元素。

示例

from bs4 import BeautifulSoup soup = BeautifulSoup(html, 'html.parser') tag = soup.a print (tag.string) for parent in tag.parents: print (parent.name)

输出

Python p body html [document]

横向

出现在相同缩进级别的 HTML 标签称为同级。考虑以下 HTML 代码段

<p>

<b>

Hello

</b>

<i>

Python

</i>

</p>

在外部 <p> 标签中,我们在同一缩进级别上具有 <b> 和 <i> 标签,因此它们被称为同级。BeautifulSoup 使在同一级别的标签之间导航成为可能。

.next_sibling 和 .previous_sibling

这些属性分别返回同一级别上的下一个标签和同一级别上的上一个标签。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<p><b>Hello</b><i>Python</i></p>", 'html.parser')

tag1 = soup.b

print ("next:",tag1.next_sibling)

tag2 = soup.i

print ("previous:",tag2.previous_sibling)

输出

next: <i>Python</i> previous: <b>Hello</b>

由于 <b> 标签左侧没有同级,<i> 标签右侧也没有同级,因此在这两种情况下它都返回 Nobe。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<p><b>Hello</b><i>Python</i></p>", 'html.parser')

tag1 = soup.b

print ("next:",tag1.previous_sibling)

tag2 = soup.i

print ("previous:",tag2.next_sibling)

输出

next: None previous: None

.next_siblings 和 .previous_siblings

如果标签右侧或左侧有两个或多个同级,则可以使用 .next_siblings 和 .previous_siblings 属性分别导航它们。它们都返回生成器对象,以便可以使用 for 循环进行迭代。

让我们为此目的使用以下 HTML 代码段:

<p>

<b>

Excellent

</b>

<i>

Python

</i>

<u>

Tutorial

</u>

</p>

使用以下代码遍历下一个和上一个同级标签。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<p><b>Excellent</b><i>Python</i><u>Tutorial</u></p>", 'html.parser')

tag1 = soup.b

print ("next siblings:")

for tag in tag1.next_siblings:

print (tag)

print ("previous siblings:")

tag2 = soup.u

for tag in tag2.previous_siblings:

print (tag)

输出

next siblings: <i>Python</i> <u>Tutorial</u> previous siblings: <i>Python</i> <b>Excellent</b>

来回

在 Beautiful Soup 中,next_element 属性返回解析树中的下一个字符串或标签。另一方面,previous_element 属性返回解析树中的上一个字符串或标签。有时,next_element 和 previous_element 属性的返回值与 next_sibling 和 previous_sibling 属性相似。

.next_element 和 .previous_element

示例

html = """

<html><head><title>TutorialsPoint</title></head>

<body>

<p class="title"><b>Online Tutorials Library</b></p>

<p class="story">TutorialsPoint has an excellent collection of tutorials on:

<a href="https://tutorialspoint.com/Python" class="lang" id="link1">Python</a>,

<a href="https://tutorialspoint.com/Java" class="lang" id="link2">Java</a> and

<a href="https://tutorialspoint.com/PHP" class="lang" id="link3">PHP</a>;

Enhance your Programming skills.</p>

<p class="tutorial">...</p>

"""

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

tag = soup.find("a", id="link3")

print (tag.next_element)

tag = soup.find("a", id="link1")

print (tag.previous_element)

输出

PHP TutorialsPoint has an excellent collection of tutorials on:

id = "link3" 的 <a> 标签之后的 next_element 是字符串 PHP。类似地,previous_element 返回 id = "link1" 的 <a> 标签之前的字符串。

.next_elements 和 .previous_elements

Tag 对象的这些属性分别返回其后和其前所有标签和字符串的生成器。

Next elements 示例

tag = soup.find("a", id="link1")

for element in tag.next_elements:

print (element)

输出

Python , <a class="lang" href="https://tutorialspoint.com/Java" id="link2">Java</a> Java and <a class="lang" href="https://tutorialspoint.com/PHP" id="link3">PHP</a> PHP ; Enhance your Programming skills. <p class="tutorial">...</p> ...

Previous elements 示例

tag = soup.find("body")

for element in tag.previous_elements:

print (element)

输出

<html><head><title>TutorialsPoint</title></head>

Beautiful Soup - 修改树结构

Beautiful Soup 库的一个强大功能是能够操纵已解析的 HTML 或 XML 文档并修改其内容。

Beautiful Soup 库具有执行以下操作的不同函数:

将内容或新标签添加到文档的现有标签中

在现有标签或字符串之前或之后插入内容

清除现有标签的内容

修改标签元素的内容

添加内容

您可以使用 Tag 对象上的append() 方法添加到现有标签的内容中。它的工作原理类似于 Python 列表对象的 append() 方法。

在以下示例中,HTML 脚本有一个 <p> 标签。使用 append(),附加了其他文本。

示例

from bs4 import BeautifulSoup

markup = '<p>Hello</p>'

soup = BeautifulSoup(markup, 'html.parser')

print (soup)

tag = soup.p

tag.append(" World")

print (soup)

输出

<p>Hello</p> <p>Hello World</p>

使用 append() 方法,您可以在现有标签的末尾添加一个新标签。首先使用new_tag() 方法创建一个新的 Tag 对象,然后将其传递给 append() 方法。

示例

from bs4 import BeautifulSoup, Tag

markup = '<b>Hello</b>'

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.b

tag1 = soup.new_tag('i')

tag1.string = 'World'

tag.append(tag1)

print (soup.prettify())

输出

<b>

Hello

<i>

World

</i>

</b>

如果必须将字符串添加到文档中,则可以附加NavigableString 对象。

示例

from bs4 import BeautifulSoup, NavigableString

markup = '<b>Hello</b>'

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.b

new_string = NavigableString(" World")

tag.append(new_string)

print (soup.prettify())

输出

<b> Hello World </b>

从 Beautiful Soup 4.7 版开始,extend() 方法已添加到 Tag 类中。它将列表中的所有元素添加到标签中。

示例

from bs4 import BeautifulSoup markup = '<b>Hello</b>' soup = BeautifulSoup(markup, 'html.parser') tag = soup.b vals = ['World.', 'Welcome to ', 'TutorialsPoint'] tag.extend(vals) print (soup.prettify())

输出

<b> Hello World. Welcome to TutorialsPoint </b>

插入内容

您可以使用insert() 方法在 Tag 元素的子元素列表中的给定位置添加元素,而不是在末尾添加新元素。Beautiful Soup 中的 insert() 方法的行为类似于 Python 列表对象上的 insert()。

在以下示例中,一个新字符串在位置 1 添加到 <b> 标签中。生成的已解析文档显示了结果。

示例

from bs4 import BeautifulSoup, NavigableString markup = '<b>Excellent </b><u>from TutorialsPoint</u>' soup = BeautifulSoup(markup, 'html.parser') tag = soup.b tag.insert(1, "Tutorial ") print (soup.prettify())

输出

<b> Excellent Tutorial </b> <u> from TutorialsPoint </u>

Beautiful Soup 还有insert_before() 和insert_after() 方法。它们各自的目的是在给定的 Tag 对象之前或之后插入标签或字符串。以下代码显示字符串“Python 教程”已添加到 <b> 标签之后。

示例

from bs4 import BeautifulSoup, NavigableString

markup = '<b>Excellent </b><u>from TutorialsPoint</u>'

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.b

tag.insert_after("Python Tutorial")

print (soup.prettify())

输出

<b> Excellent </b> Python Tutorial <u> from TutorialsPoint </u>

另一方面,下面使用 insert_before() 方法,在 <b> 标签之前添加“这是一个”文本。

tag.insert_before("Here is an ")

print (soup.prettify())

输出

Here is an <b> Excellent </b> Python Tutorial <u> from TutorialsPoint </u>

清除内容

Beautiful Soup 提供了多种从文档树中删除元素内容的方法。每种方法都有其独特的特点。

clear() 方法是最直接的方法。它只是简单地删除指定 Tag 元素的内容。以下示例显示了它的用法。

示例

from bs4 import BeautifulSoup, NavigableString

markup = '<b>Excellent </b><u>from TutorialsPoint</u>'

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.find('u')

tag.clear()

print (soup.prettify())

输出

<b> Excellent </b> <u> </u>

可以看出,clear() 方法删除了内容,但保留了标签。

对于以下示例,我们解析以下 HTML 文档并在所有标签上调用 clear() 方法。

<html>

<body>

<p> The quick, brown fox jumps over a lazy dog.</p>

<p> DJs flock by when MTV ax quiz prog.</p>

<p> Junk MTV quiz graced by fox whelps.</p>

<p> Bawds jog, flick quartz, vex nymphs./p>

</body>

</html>

这是使用 clear() 方法的 Python 代码

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tags = soup.find_all()

for tag in tags:

tag.clear()

print (soup.prettify())

输出

<html> </html>

extract() 方法从文档树中删除标签或字符串,并返回已删除的对象。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tags = soup.find_all()

for tag in tags:

obj = tag.extract()

print ("Extracted:",obj)

print (soup)

输出

Extracted: <html> <body> <p> The quick, brown fox jumps over a lazy dog.</p> <p> DJs flock by when MTV ax quiz prog.</p> <p> Junk MTV quiz graced by fox whelps.</p> <p> Bawds jog, flick quartz, vex nymphs.</p> </body> </html> Extracted: <body> <p> The quick, brown fox jumps over a lazy dog.</p> <p> DJs flock by when MTV ax quiz prog.</p> <p> Junk MTV quiz graced by fox whelps.</p> <p> Bawds jog, flick quartz, vex nymphs.</p> </body> Extracted: <p> The quick, brown fox jumps over a lazy dog.</p> Extracted: <p> DJs flock by when MTV ax quiz prog.</p> Extracted: <p> Junk MTV quiz graced by fox whelps.</p> Extracted: <p> Bawds jog, flick quartz, vex nymphs.</p>

您可以提取标签或字符串。以下示例显示了正在提取的 antag。

示例

html = '''

<ol id="HR">

<li>Rani</li>

<li>Ankita</li>

</ol>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

obj=soup.find('ol')

obj.find_next().extract()

print (soup)

输出

<ol id="HR"> <li>Ankita</li> </ol>

更改 extract() 语句以删除第一个 <li> 元素的内部文本。

示例

obj.find_next().string.extract()

输出

<ol id="HR"> <li>Ankita</li> </ol>

还有另一个方法 decompose(),它从树中删除标签,然后完全销毁它及其内容:

示例

html = '''

<ol id="HR">

<li>Rani</li>

<li>Ankita</li>

</ol>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

tag1=soup.find('ol')

tag2 = soup.find('li')

tag2.decompose()

print (soup)

print (tag2.decomposed)

输出

<ol id="HR"> <li>Ankita</li> </ol>

decomposed 属性返回 True 或 False——元素是否已被分解。

修改内容

我们将看看replace_with() 方法,它允许替换标签的内容。

就像 Python 字符串是不可变的,可导航字符串也不能就地修改。但是,使用 replace_with() 将标签的内部字符串替换为另一个字符串。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<h2 id='message'>Hello, Tutorialspoint!</h2>",'html.parser')

tag = soup.h2

tag.string.replace_with("OnLine Tutorials Library")

print (tag.string)

输出

OnLine Tutorials Library

这是另一个显示 replace_with() 用法的示例。如果您将 BeautifulSoup 对象作为参数传递给某个函数(例如 replace_with()),则可以组合两个已解析的文档。2524

示例

from bs4 import BeautifulSoup

obj1 = BeautifulSoup("<book><title>Python</title></book>", features="xml")

obj2 = BeautifulSoup("<b>Beautiful Soup parser</b>", "lxml")

obj2.find('b').replace_with(obj1)

print (obj2)

输出

<html><body><book><title>Python</title></book></body></html>

wrap() 方法将元素包装在您指定的标签中。它返回新的包装器。

from bs4 import BeautifulSoup

soup = BeautifulSoup("<p>Hello Python</p>", 'html.parser')

tag = soup.p

newtag = soup.new_tag('b')

tag.string.wrap(newtag)

print (soup)

输出

<p><b>Hello Python</b></p>

另一方面,unwrap() 方法用标签内的任何内容替换标签。它非常适合去除标记。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup("<p>Hello <b>Python</b></p>", 'html.parser')

tag = soup.p

tag.b.unwrap()

print (soup)

输出

<p>Hello Python</p>

Beautiful Soup - 解析文档的一部分

假设您想使用 Beautiful Soup 仅查看文档的 <a> 标签。通常,您会解析树并使用 find_all() 方法,并将所需的标签作为参数。

soup = BeautifulSoup(fp, "html.parser")

tags = soup.find_all('a')

但是,这也会非常耗时,并且会不必要地占用更多内存。相反,您可以创建一个 SoupStrainer 类对象,并将其用作 BeautifulSoup 构造函数的 parse_only 参数的值。

SoupStrainer 告诉 BeautifulSoup 要提取哪些部分,并且解析树仅包含这些元素。如果您将所需信息缩小到 HTML 的特定部分,这将加快搜索结果的速度。

product = SoupStrainer('div',{'id': 'products_list'})

soup = BeautifulSoup(html,parse_only=product)

以上代码行将仅从产品网站解析标题,标题可能位于标签字段内。

类似地,就像上面一样,我们可以使用其他 soupStrainer 对象从 HTML 标签解析特定信息。以下是一些示例 -

示例

from bs4 import BeautifulSoup, SoupStrainer

#Only "a" tags

only_a_tags = SoupStrainer("a")

#Will parse only the below mentioned "ids".

parse_only = SoupStrainer(id=["first", "third", "my_unique_id"])

soup = BeautifulSoup(my_document, "html.parser", parse_only=parse_only)

#parse only where string length is less than 10

def is_short_string(string):

return len(string) < 10

only_short_strings = SoupStrainer(string=is_short_string)

SoupStrainer 类接受与搜索树中的典型方法相同的参数:name、attrs、text 和 **kwargs。

请注意,如果您使用 html5lib 解析器,则此功能将不起作用,因为在这种情况下,无论如何都会解析整个文档。因此,您应该使用内置的 html.parser 或 lxml 解析器。

您还可以将 SoupStrainer 传递到“搜索树”中介绍的任何方法中。

from bs4 import SoupStrainer

a_tags = SoupStrainer("a")

soup = BeautifulSoup(html_doc, 'html.parser')

soup.find_all(a_tags)

Beautiful Soup - 查找元素的所有子元素

HTML 脚本中标签的结构是分层的。元素嵌套在另一个元素内部。例如,顶级 <HTML> 标签包含 <HEAD> 和 <BODY> 标签,每个标签都可能包含其他标签。顶级元素称为父元素。嵌套在父元素内部的元素是其子元素。借助 Beautiful Soup,我们可以找到父元素的所有子元素。在本章中,我们将了解如何获取 HTML 元素的子元素。

BeautifulSoup 类中有两种方法可以获取子元素。

- .children 属性

- findChildren() 方法

本章中的示例使用以下 HTML 脚本 (index.html)

<html> <head> <title>TutorialsPoint</title> </head> <body> <h2>Departmentwise Employees</h2> <ul id="dept"> <li>Accounts</li> <ul id='acc'> <li>Anand</li> <li>Mahesh</li> </ul> <li>HR</li> <ul id="HR"> <li>Rani</li> <li>Ankita</li> </ul> </ul> </body> </html>

使用 .children 属性

Tag 对象的 .children 属性以递归方式返回所有子元素的生成器。

以下 Python 代码给出了顶级 <ul> 标签的所有子元素的列表。我们首先获取与 <ul> 标签对应的 Tag 元素,然后读取其 .children 属性。

示例

from bs4 import BeautifulSoup

with open("index.html") as fp:

soup = BeautifulSoup(fp, 'html.parser')

tag = soup.ul

print (list(tag.children))

输出

['\n', <li>Accounts</li>, '\n', <ul> <li>Anand</li> <li>Mahesh</li> </ul>, '\n', <li>HR</li>, '\n', <ul> <li>Rani</li> <li>Ankita</li> </ul>, '\n']

由于 .children 属性返回一个列表迭代器,因此我们可以使用 for 循环来遍历层次结构。

for child in tag.children: print (child)

输出

<li>Accounts</li> <ul> <li>Anand</li> <li>Mahesh</li> </ul> <li>HR</li> <ul> <li>Rani</li> <li>Ankita</li> </ul>

使用 findChildren() 方法

findChildren() 方法提供了一种更全面的替代方案。它返回任何顶级标签下的所有子元素。

在 index.html 文档中,我们有两个嵌套的无序列表。顶级 <ul> 元素的 id 为 "dept",两个包含的列表的 id 分别为 "acc" 和 "HR"。

在以下示例中,我们首先实例化一个指向顶级 <ul> 元素的 Tag 对象,并提取其下的子元素列表。

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tag = soup.find("ul", {"id": "dept"})

children = tag.findChildren()

for child in children:

print(child)

请注意,结果集以递归方式包含元素下的子元素。因此,在以下输出中,您将找到整个内部列表,以及其中的各个元素。

<li>Accounts</li> <ul id="acc"> <li>Anand</li> <li>Mahesh</li> </ul> <li>Anand</li> <li>Mahesh</li> <li>HR</li> <ul id="HR"> <li>Rani</li> <li>Ankita</li> </ul> <li>Rani</li> <li>Ankita</li>

让我们提取 id 为 'acc' 的内部 <ul> 元素下的子元素。代码如下 -

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tag = soup.find("ul", {"id": "acc"})

children = tag.findChildren()

for child in children:

print(child)

运行上述程序时,您将获得 id 为 acc 的 <ul> 下的 <li> 元素。

输出

<li>Anand</li> <li>Mahesh</li>

因此,BeautifulSoup 使解析任何顶级 HTML 元素下的子元素变得非常容易。

Beautiful Soup - 使用 CSS 选择器查找元素

在 Beautiful Soup 库中,select() 方法是抓取 HTML/XML 文档的重要工具。与 find() 和其他 find_*() 方法类似,select() 方法也有助于定位满足给定条件的元素。但是,find*() 方法根据标签名称及其属性搜索 PageElements,而 select() 方法根据给定的 CSS 选择器搜索文档树。

Beautiful Soup 还有 select_one() 方法。select() 和 select_one() 的区别在于,select() 返回属于 PageElement 并以 CSS 选择器为特征的所有元素的结果集;而 select_one() 返回满足基于 CSS 选择器选择标准的元素的第一个出现。

在 Beautiful Soup 4.7 版本之前,select() 方法只能支持常见的 CSS 选择器。随着 4.7 版本的发布,Beautiful Soup 集成了 Soup Sieve CSS 选择器库。因此,现在可以使用更多的选择器。在 4.12 版本中,除了现有的便捷方法 select() 和 select_one() 之外,还添加了一个 .css 属性。select() 方法的参数如下 -

select(selector, limit, **kwargs)

selector - 包含 CSS 选择器的字符串。

limit - 找到此数量的结果后,停止查找。

kwargs - 要传递的关键字参数。

如果将 limit 参数设置为 1,则它等效于 select_one() 方法。select() 方法返回 Tag 对象的结果集,而 select_one() 方法返回单个 Tag 对象。

Soup Sieve 库

Soup Sieve 是一个 CSS 选择器库。它已与 Beautiful Soup 4 集成,因此与 Beautiful Soup 包一起安装。它提供了使用现代 CSS 选择器选择、匹配和过滤文档树标签的功能。Soup Sieve 目前实现了从 CSS 级别 1 规范到 CSS 级别 4 的大多数 CSS 选择器,除了某些尚未实现的选择器。

Soup Sieve 库有不同类型的 CSS 选择器。基本 CSS 选择器为 -

类型选择器

通过节点名称匹配元素。例如 -

tags = soup.select('div')

示例

from bs4 import BeautifulSoup, NavigableString

markup = '''

<div id="Languages">

<p>Java</p> <p>Python</p> <p>C++</p>

</div>

'''

soup = BeautifulSoup(markup, 'html.parser')

tags = soup.select('div')

print (tags)

输出

[<div id="Languages"> <p>Java</p> <p>Python</p> <p>C++</p> </div>]

通用选择器 (*)

它匹配任何类型的元素。例如 -

tags = soup.select('*')

ID 选择器

它根据元素的 id 属性匹配元素。符号 # 表示 ID 选择器。例如 -

tags = soup.select("#nm")

示例

from bs4 import BeautifulSoup

html = '''

<form>

<input type = 'text' id = 'nm' name = 'name'>

<input type = 'text' id = 'age' name = 'age'>

<input type = 'text' id = 'marks' name = 'marks'>

</form>

'''

soup = BeautifulSoup(html, 'html.parser')

obj = soup.select("#nm")

print (obj)

输出

[<input id="nm" name="name" type="text"/>]

类选择器

它根据 class 属性中包含的值匹配元素。前缀为类名称的 . 符号是 CSS 类选择器。例如 -

tags = soup.select(".submenu")

示例

from bs4 import BeautifulSoup, NavigableString

markup = '''

<div id="Languages">

<p>Java</p> <p>Python</p> <p>C++</p>

</div>

'''

soup = BeautifulSoup(markup, 'html.parser')

tags = soup.select('div')

print (tags)

输出

[<div id="Languages"> <p>Java</p> <p>Python</p> <p>C++</p> </div>]

属性选择器

属性选择器根据元素的属性匹配元素。

soup.select('[attr]')

示例

from bs4 import BeautifulSoup

html = '''

<h1>Tutorialspoint Online Library</h1>

<p><b>It's all Free</b></p>

<a class="prog" href="https://tutorialspoint.com/java/java_overview.htm" id="link1">Java</a>

<a class="prog" href="https://tutorialspoint.com/cprogramming/index.htm" id="link2">C</a>

'''

soup = BeautifulSoup(html, 'html5lib')

print(soup.select('[href]'))

输出

[<a class="prog" href="https://tutorialspoint.com/java/java_overview.htm" id="link1">Java</a>, <a class="prog" href="https://tutorialspoint.com/cprogramming/index.htm" id="link2">C</a>]

伪类

CSS 规范定义了许多伪 CSS 类。伪类是添加到选择器中的关键字,用于定义所选元素的特殊状态。它为现有元素添加效果。例如,:link 选择尚未访问的链接(每个具有 href 属性的 <a> 和 <area> 元素)。

伪类选择器 nth-of-type 和 nth-child 非常广泛使用。

:nth-of-type()

选择器 :nth-of-type() 根据元素在兄弟元素组中的位置匹配给定类型的元素。关键字 even 和 odd 分别将从兄弟元素的子组中选择元素。

在以下示例中,选择了 <p> 类型的第二个元素。

示例

from bs4 import BeautifulSoup

html = '''

<p id="0"></p>

<p id="1"></p>

<span id="2"></span>

<span id="3"></span>

'''

soup = BeautifulSoup(html, 'html5lib')

print(soup.select('p:nth-of-type(2)'))

输出

[<p id="1"></p>]

:nth-child()

此选择器根据元素在一组兄弟元素中的位置匹配元素。关键字 even 和 odd 分别将选择在一组兄弟元素中位置为偶数或奇数的元素。

用法

:nth-child(even) :nth-child(odd) :nth-child(2)

示例

from bs4 import BeautifulSoup, NavigableString

markup = '''

<div id="Languages">

<p>Java</p> <p>Python</p> <p>C++</p>

</div>

'''

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.div

child = tag.select_one(':nth-child(2)')

print (child)

输出

<p>Python</p>

Beautiful Soup - 查找所有注释

在计算机代码中插入注释被认为是一种良好的编程实践。注释有助于理解程序的逻辑。它们也用作文档。您可以在 HTML 和 XML 脚本中添加注释,就像在用 C、Java、Python 等编写的程序中一样。BeautifulSoup API 可以帮助识别 HTML 文档中的所有注释。

在 HTML 和 XML 中,注释文本写在 <!-- 和 --> 标签之间。

<!-- Comment Text -->

BeutifulSoup 包(其内部名称为 bs4)将 Comment 定义为一个重要的对象。Comment 对象是一种特殊的 NavigableString 对象。因此,在 <!-- 和 --> 之间找到的任何 Tag 的 string 属性都被识别为 Comment。

示例

from bs4 import BeautifulSoup markup = "<b><!--This is a comment text in HTML--></b>" soup = BeautifulSoup(markup, 'html.parser') comment = soup.b.string print (comment, type(comment))

输出

This is a comment text in HTML <class 'bs4.element.Comment'>

要搜索 HTML 文档中注释的所有出现,我们将使用 find_all() 方法。如果没有参数,find_all() 将返回解析后的 HTML 文档中的所有元素。您可以将关键字参数 'string' 传递给 find_all() 方法。我们将为其分配函数 iscomment() 的返回值。

comments = soup.find_all(string=iscomment)

iscomment() 函数使用 isinstance() 函数验证标签中的文本是否为注释对象。

def iscomment(elem): return isinstance(elem, Comment)

comments 变量将存储给定 HTML 文档中的所有注释文本出现。我们将在示例代码中使用以下 index.html 文件 -

<html>

<head>

<!-- Title of document -->

<title>TutorialsPoint</title>

</head>

<body>

<!-- Page heading -->

<h2>Departmentwise Employees</h2>

<!-- top level list-->

<ul id="dept">

<li>Accounts</li>

<ul id='acc'>

<!-- first inner list -->

<li>Anand</li>

<li>Mahesh</li>

</ul>

<li>HR</li>

<ul id="HR">

<!-- second inner list -->

<li>Rani</li>

<li>Ankita</li>

</ul>

</ul>

</body>

</html>

以下 Python 程序抓取上述 HTML 文档,并查找其中的所有注释。

示例

from bs4 import BeautifulSoup, Comment

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

def iscomment(elem):

return isinstance(elem, Comment)

comments = soup.find_all(string=iscomment)

print (comments)

输出

[' Title of document ', ' Page heading ', ' top level list', ' first inner list ', ' second inner list ']

以上输出显示了所有注释的列表。我们还可以对注释集合使用 for 循环。

示例

i=0 for comment in comments: i+=1 print (i,".",comment)

输出

1 . Title of document 2 . Page heading 3 . top level list 4 . first inner list 5 . second inner list

在本章中,我们学习了如何提取 HTML 文档中的所有注释字符串。

Beautiful Soup - 从 HTML 中抓取列表

网页通常以有序或无序列表的形式包含重要数据。使用 Beautiful Soup,我们可以轻松地提取 HTML 列表元素,将数据转换为 Python 对象,并将其存储在数据库中以供进一步分析。在本章中,我们将使用 find() 和 select() 方法从 HTML 文档中抓取列表数据。

搜索解析树最简单的方法是按其名称搜索标签。soup.<tag> 获取给定标签的内容。

HTML 提供 <ol> 和 <ul> 标签来组成有序和无序列表。与任何其他标签一样,我们可以获取这些标签的内容。

我们将使用以下 HTML 文档 -

<html>

<body>

<h2>Departmentwise Employees</h2>

<ul id="dept">

<li>Accounts</li>

<ul id='acc'>

<li>Anand</li>

<li>Mahesh</li>

</ul>

<li>HR</li>

<ol id="HR">

<li>Rani</li>

<li>Ankita</li>

</ol>

</ul>

</body>

</html>

按标签抓取列表

在上面的 HTML 文档中,我们有一个顶级 <ul> 列表,其中包含另一个 <ul> 标签和另一个 <ol> 标签。我们首先在 soup 对象中解析文档,并在 soup.ul Tag 对象中检索第一个 <ul> 的内容。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

lst=soup.ul

print (lst)

输出

<ul id="dept"> <li>Accounts</li> <ul id="acc"> <li>Anand</li> <li>Mahesh</li> </ul> <li>HR</li> <ol id="HR"> <li>Rani</li> <li>Ankita</li> </ol> </ul>

更改 lst 的值以指向 <ol> 元素以获取内部列表。

lst=soup.ol

输出

<ol id="HR"> <li>Rani</li> <li>Ankita</li> </ol>

使用 select() 方法

select() 方法主要用于使用 CSS 选择器获取数据。但是,您也可以向其传递标签。在这里,我们可以将 ol 标签传递给 select() 方法。select_one() 方法也可用。它获取给定标签的第一个出现。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

lst=soup.select("ol")

print (lst)

输出

[<ol id="HR"> <li>Rani</li> <li>Ankita</li> </ol>]

使用 find_all() 方法

find() 和 fin_all() 方法更全面。您可以将各种类型的过滤器(如标签、属性或字符串等)传递给这些方法。在这种情况下,我们想要获取列表标签的内容。

在以下代码中,find_all() 方法返回 <ul> 标签中所有元素的列表。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

lst=soup.find_all("ul")

print (lst)

我们可以通过包含 attrs 参数来细化搜索过滤器。在我们的 HTML 文档中,<ul> 和 <ol> 标签,我们已经指定了它们各自的 id 属性。因此,让我们获取具有 id="acc" 的 <ul> 元素的内容。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

lst=soup.find_all("ul", {"id":"acc"})

print (lst)

输出

[<ul id="acc"> <li>Anand</li> <li>Mahesh</li> </ul>]

这是一个其他示例。我们收集所有带有 <li> 标签的元素,其内部文本以 'A' 开头。find_all() 方法采用关键字参数 string。如果 startingwith() 函数返回 True,则它将获取文本的值。

示例

from bs4 import BeautifulSoup

def startingwith(ch):

return ch.startswith('A')

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

lst=soup.find_all('li',string=startingwith)

print (lst)

输出

[<li>Accounts</li>, <li>Anand</li>, <li>Ankita</li>]

Beautiful Soup - 从 HTML 中抓取段落

HTML 文档中经常出现的标签之一是 <p> 标签,它标记段落文本。使用 Beautiful Soup,您可以轻松地从解析的文档树中提取段落。在本章中,我们将讨论以下使用 BeautifulSoup 库抓取段落的方法。

使用 <p> 标签抓取 HTML 段落

使用 find_all() 方法抓取 HTML 段落

使用 select() 方法抓取 HTML 段落

我们将使用以下 HTML 文档进行这些练习 -

<html>

<head>

<title>BeautifulSoup - Scraping Paragraph</title>

</head>

<body>

<p id='para1'>The quick, brown fox jumps over a lazy dog.</p>

<h2>Hello</h2>

<p>DJs flock by when MTV ax quiz prog.</p>

<p>Junk MTV quiz graced by fox whelps.</p>

<p>Bawds jog, flick quartz, vex nymphs.</p>

</body>

</html>

按 <p> 标签抓取

搜索解析树最简单的方法是按其名称搜索标签。因此,表达式 soup.p 指向抓取的文档中的第一个 <p> 标签。

para = soup.p

要获取所有后续的<p>标签,可以运行一个循环,直到soup对象中所有的<p>标签都被遍历完。以下程序显示了所有段落标签的美化输出。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

para = soup.p

print (para.prettify())

while True:

p = para.find_next('p')

if p is None:

break

print (p.prettify())

para=p

输出

<p> The quick, brown fox jumps over a lazy dog. </p> <p> DJs flock by when MTV ax quiz prog. </p> <p> Junk MTV quiz graced by fox whelps. </p> <p> Bawds jog, flick quartz, vex nymphs. </p>

使用 find_all() 方法

find_all()方法更全面。您可以将各种类型的过滤器(例如标签、属性或字符串等)传递给此方法。在本例中,我们想要获取<p>标签的内容。

在以下代码中,find_all()方法返回<p>标签中所有元素的列表。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

paras = soup.find_all('p')

for para in paras:

print (para.prettify())

输出

<p> The quick, brown fox jumps over a lazy dog. </p> <p> DJs flock by when MTV ax quiz prog. </p> <p> Junk MTV quiz graced by fox whelps. </p> <p> Bawds jog, flick quartz, vex nymphs. </p>

我们可以使用另一种方法来查找所有<p>标签。首先,使用find_all()获取所有标签的列表,并检查每个标签的Tag.name是否等于'p'。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tags = soup.find_all()

paras = [tag.contents for tag in tags if tag.name=='p']

print (paras)

find_all()方法还有一个attrs参数。当您想要提取具有特定属性的<p>标签时,它非常有用。例如,在给定的文档中,第一个<p>元素具有id='para1'。要获取它,我们需要修改标签对象如下所示:

paras = soup.find_all('p', attrs={'id':'para1'})

使用 select() 方法

select()方法主要用于使用CSS选择器获取数据。但是,您也可以将标签传递给它。在这里,我们可以将<p>标签传递给select()方法。select_one()方法也可用。它获取<p>标签的第一次出现。

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

paras = soup.select('p')

print (paras)

输出

[ <p>The quick, brown fox jumps over a lazy dog.</p>, <p>DJs flock by when MTV ax quiz prog.</p>, <p>Junk MTV quiz graced by fox whelps.</p>, <p>Bawds jog, flick quartz, vex nymphs.</p> ]

要过滤掉具有特定id的<p>标签,请使用如下所示的for循环:

示例

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tags = soup.select('p')

for tag in tags:

if tag.has_attr('id') and tag['id']=='para1':

print (tag.contents)

输出

['The quick, brown fox jumps over a lazy dog.']

BeautifulSoup - 从 HTML 中抓取链接

在从具有网站的资源中抓取和分析内容时,您通常需要提取某个页面包含的所有链接。在本章中,我们将了解如何从HTML文档中提取链接。

HTML使用锚标签<a>来插入超链接。锚标签的href属性允许您建立链接。它使用以下语法:

<a href=="web page URL">hypertext</a>

使用find_all()方法,我们可以收集文档中的所有锚标签,然后打印每个锚标签的href属性的值。

在下面的示例中,我们提取了Google主页上找到的所有链接。我们使用requests库来收集https://google.com的HTML内容,将其解析为soup对象,然后收集所有<a>标签。最后,我们打印href属性。

示例

from bs4 import BeautifulSoup

import requests

url = "https://www.google.com/"

req = requests.get(url)

soup = BeautifulSoup(req.content, "html.parser")

tags = soup.find_all('a')

links = [tag['href'] for tag in tags]

for link in links:

print (link)

以下是运行上述程序时部分输出:

输出

https://www.google.co.in/imghp?hl=en&tab=wi https://maps.google.co.in/maps?hl=en&tab=wl https://play.google.com/?hl=en&tab=w8 https://www.youtube.com/?tab=w1 https://news.google.com/?tab=wn https://mail.google.com/mail/?tab=wm https://drive.google.com/?tab=wo https://www.google.co.in/intl/en/about/products?tab=wh http://www.google.co.in/history/optout?hl=en /preferences?hl=en https://#/ServiceLogin?hl=en&passive=true&continue=https://www.google.com/&ec=GAZAAQ /advanced_search?hl=en-IN&authuser=0 https://www.google.com/url?q=https://io.google/2023/%3Futm_source%3Dgoogle-hpp%26utm_medium%3Dembedded_marketing%26utm_campaign%3Dhpp_watch_live%26utm_content%3D&source=hpp&id=19035434&ct=3&usg=AOvVaw0qzqTkP5AEv87NM-MUDd_u&sa=X&ved=0ahUKEwiPzpjku-z-AhU1qJUCHVmqDJoQ8IcBCAU

但是,HTML文档可能具有不同协议方案的超链接,例如用于链接到电子邮件ID的mailto:协议,用于链接到电话号码的tel:方案,或用于链接到具有file:// URL方案的本地文件的链接。在这种情况下,如果我们有兴趣提取具有https://方案的链接,我们可以通过以下示例来实现。我们有一个包含不同类型超链接的HTML文档,其中仅提取了具有https://前缀的超链接。

html = '''

<p><a href="https://tutorialspoint.com">Web page link </a></p>

<p><a href="https://www.example.com">Web page link </a></p>

<p><a href="mailto:nowhere@mozilla.org">Email link</a></p>

<p><a href="tel:+4733378901">Telephone link</a></p>

'''

from bs4 import BeautifulSoup

import requests

soup = BeautifulSoup(html, "html.parser")

tags = soup.find_all('a')

links = [tag['href'] for tag in tags]

for link in links:

if link.startswith("https"):

print (link)

输出

https://tutorialspoint.com https://www.example.com

Beautiful Soup - 获取所有 HTML 标签

HTML中的标签就像Python或Java等传统编程语言中的关键字。标签具有预定义的行为,浏览器根据该行为呈现其内容。使用Beautiful Soup,可以收集给定HTML文档中的所有标签。

获取标签列表的最简单方法是将网页解析为soup对象,然后调用不带任何参数的find_all()方法。它返回一个列表生成器,为我们提供所有标签的列表。

让我们提取Google主页中所有标签的列表。

示例

from bs4 import BeautifulSoup import requests url = "https://www.google.com/" req = requests.get(url) soup = BeautifulSoup(req.content, "html.parser") tags = soup.find_all() print ([tag.name for tag in tags])

输出

['html', 'head', 'meta', 'meta', 'title', 'script', 'style', 'style', 'script', 'body', 'script', 'div', 'div', 'nobr', 'b', 'a', 'a', 'a', 'a', 'a', 'a', 'a', 'a', 'u', 'div', 'nobr', 'span', 'span', 'span', 'a', 'a', 'a', 'div', 'div', 'center', 'br', 'div', 'img', 'br', 'br', 'form', 'table', 'tr', 'td', 'td', 'input', 'input', 'input', 'input', 'input', 'div', 'input', 'br', 'span', 'span', 'input', 'span', 'span', 'input', 'script', 'input', 'td', 'a', 'input', 'script', 'div', 'div', 'br', 'div', 'style', 'div', 'a', 'a', 'a', 'a', 'a', 'a', 'a', 'a', 'a', 'span', 'div', 'div', 'a', 'a', 'a', 'a', 'p', 'a', 'a', 'script', 'script', 'script']

当然,您可能会得到这样一个列表,其中某个特定标签可能会出现多次。要获得唯一的标签列表(避免重复),请从标签对象列表中构造一个集合。

将上面代码中的print语句更改为

示例

print ({tag.name for tag in tags})

输出

{'body', 'head', 'p', 'a', 'meta', 'tr', 'nobr', 'script', 'br', 'img', 'b', 'form', 'center', 'span', 'div', 'input', 'u', 'title', 'style', 'td', 'table', 'html'}

要获取与某些文本关联的标签,请检查字符串属性,如果它不是None,则打印。

tags = soup.find_all()

for tag in tags:

if tag.string is not None:

print (tag.name, tag.string)

可能有一些不带文本但带有一个或多个属性的单例标签,例如<img>标签。以下循环构建了此类标签的列表。

在以下代码中,HTML字符串不是完整的HTML文档,因为它没有给出<html>和<body>标签。但是,html5lib和lxml解析器在解析文档树时会自行添加这些标签。因此,当我们提取标签列表时,也会看到额外的标签。

示例

html = '''

<h1 style="color:blue;text-align:center;">This is a heading</h1>

<p style="color:red;">This is a paragraph.</p>

<p>This is another paragraph</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, "html5lib")

tags = soup.find_all()

print ({tag.name for tag in tags} )

输出

{'head', 'html', 'p', 'h1', 'body'}

Beautiful Soup - 获取标签内的文本

HTML中有两种类型的标签。许多标签成对出现,分别是开始标签和结束标签。顶级<html>标签具有相应的结束</html>标签,这是一个主要示例。其他的有<body>和</body>、<p>和</p>、<h1>和</h1>等等。其他标签是自闭合标签,例如<img>和<a>。自闭合标签没有文本,就像大多数带有开始和结束符号的标签(例如<b>Hello</b>)一样。在本章中,我们将了解如何借助Beautiful Soup库获取此类标签内部的文本部分。

Beautiful Soup中有多种方法/属性可用于获取与标签对象关联的文本。

| 序号 | 方法及描述 |

|---|---|

| 1 | text属性 获取PageElement的所有子字符串,如果指定则使用分隔符连接。 |

| 2 | string属性 方便地从子元素获取字符串。 |

| 3 | strings属性 从当前PageElement下的所有子对象生成字符串部分。 |

| 4 | stripped_strings属性 与strings属性相同,但删除了换行符和空格。 |

| 5 | get_text()方法 返回此PageElement的所有子字符串,如果指定则使用分隔符连接。 |

考虑以下HTML文档:

<div id="outer">

<div id="inner">

<p>Hello<b>World</b></p>

<img src='logo.jpg'>

</div>

</div>

如果我们检索解析的文档树中每个标签的stripped_string属性,我们会发现两个div标签和p标签有两个NavigableString对象,分别是Hello和World。<b>标签包含world字符串,而<img>没有文本部分。

以下示例从给定HTML文档中的每个标签中获取文本:

示例

html = """

<div id="outer">

<div id="inner">

<p>Hello<b>World</b></p>

<img src='logo.jpg'>

</div>

</div>

"""

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

for tag in soup.find_all():

print ("Tag: {} attributes: {} ".format(tag.name, tag.attrs))

for txt in tag.stripped_strings:

print (txt)

print()

输出

Tag: div attributes: {'id': 'outer'}

Hello

World

Tag: div attributes: {'id': 'inner'}

Hello

World

Tag: p attributes: {}

Hello

World

Tag: b attributes: {}

World

Tag: img attributes: {'src': 'logo.jpg'}

Beautiful Soup - 查找所有标题

在本章中,我们将探讨如何使用BeautifulSoup在HTML文档中查找所有标题元素。HTML定义了从H1到H6的六种标题样式,每种标题样式的字体大小都逐渐减小。不同的页面部分使用合适的标签,例如主标题、章节标题、主题等。让我们以两种不同的方式使用find_all()方法来提取HTML文档中的所有标题元素。

我们将在本章的代码示例中使用以下HTML脚本(保存为index.html):

<html>

<head>

<title>BeautifulSoup - Scraping Headings</title>

</head>

<body>

<h2>Scraping Headings</h2>

<b>The quick, brown fox jumps over a lazy dog.</b>

<h3>Paragraph Heading</h3>

<p>DJs flock by when MTV ax quiz prog.</p>

<h3>List heading</h3>

<ul>

<li>Junk MTV quiz graced by fox whelps.</li>

<li>Bawds jog, flick quartz, vex nymphs.</li>

</ul>

</body>

</html>

示例1

在这种方法中,我们收集解析树中的所有标签,并检查每个标签的名称是否在所有标题标签的列表中找到。

from bs4 import BeautifulSoup

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

headings = ['h1','h2','h3', 'h4', 'h5', 'h6']

tags = soup.find_all()

heads = [(tag.name, tag.contents[0]) for tag in tags if tag.name in headings]

print (heads)

这里,headings是所有标题样式h1到h6的列表。如果标签的名称是其中的任何一个,则该标签及其内容将被收集到名为heads的列表中。

输出

[('h2', 'Scraping Headings'), ('h3', 'Paragraph Heading'), ('h3', 'List heading')]

示例2

您可以将正则表达式传递给find_all()方法。请查看以下正则表达式。

re.compile('^h[1-6]$')

此正则表达式查找以h开头,h后面有一个数字,然后在数字后结束的所有标签。让我们在下面的代码中将其用作find_all()方法的参数:

from bs4 import BeautifulSoup

import re

fp = open('index.html')

soup = BeautifulSoup(fp, 'html.parser')

tags = soup.find_all(re.compile('^h[1-6]$'))

print (tags)

输出

[<h2>Scraping Headings</h2>, <h3>Paragraph Heading</h3>, <h3>List heading</h3>]

Beautiful Soup - 提取标题标签

<title>标签用于为页面提供出现在浏览器标题栏中的文本标题。它不是网页主要内容的一部分。title标签始终位于<head>标签内。

我们可以通过Beautiful Soup提取title标签的内容。我们解析HTML树并获取title标签对象。

示例

html = '''

<html>

<head>

<Title>Python Libraries</title>

</head>

<body>

<p Hello World</p>

</body>

</html>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, "html5lib")

title = soup.title

print (title)

输出

<title>Python Libraries</title>

在HTML中,我们可以将title属性与所有标签一起使用。title属性提供有关元素的附加信息。当鼠标悬停在元素上时,该信息作为工具提示文本显示。

我们可以使用以下代码片段提取每个标签的title属性的文本:

示例

html = '''

<html>

<body>

<p title='parsing HTML and XML'>Beautiful Soup</p>

<p title='HTTP library'>requests</p>

<p title='URL handling'>urllib</p>

</body>

</html>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, "html5lib")

tags = soup.find_all()

for tag in tags:

if tag.has_attr('title'):

print (tag.attrs['title'])

输出

parsing HTML and XML HTTP library URL handling

Beautiful Soup - 提取电子邮件 ID

从网页中提取电子邮件地址是BeautifulSoup等网络抓取库的重要应用。在任何网页中,电子邮件ID通常出现在锚<a>标签的href属性中。电子邮件ID使用mailto URL方案编写。很多时候,电子邮件地址可能作为普通文本出现在页面内容中(没有任何超链接)。在本章中,我们将使用BeautifulSoup库通过简单的技术从HTML页面获取电子邮件ID。

href属性中电子邮件ID的典型用法如下所示:

<a href = "mailto:xyz@abc.com">test link</a>

在第一个示例中,我们将考虑以下HTML文档,以从中提取超链接中的电子邮件ID:

<html>

<head>

<title>BeautifulSoup - Scraping Email IDs</title>

</head>

<body>

<h2>Contact Us</h2>

<ul>

<li><a href = "mailto:sales@company.com">Sales Enquiries</a></li>

<li><a href = "mailto:careers@company.com">Careers</a></li>

<li><a href = "mailto:partner@company.com">Partner with us</a></li>

</ul>

</body>

</html>

以下是查找电子邮件ID的Python代码。我们收集文档中的所有<a>标签,并检查该标签是否具有href属性。如果是,则其值从第6个字符开始的部分就是电子邮件ID。

from bs4 import BeautifulSoup

import re

fp = open("contact.html")

soup = BeautifulSoup(fp, "html.parser")

tags = soup.find_all("a")

for tag in tags:

if tag.has_attr("href") and tag['href'][:7]=='mailto:':

print (tag['href'][7:])

对于给定的HTML文档,电子邮件ID将按如下方式提取:

sales@company.com careers@company.com partner@company.com

在第二个示例中,我们假设电子邮件ID出现在文本中的任何位置。要提取它们,我们使用正则表达式搜索机制。正则表达式是一种复杂的字符模式。Python的re模块有助于处理正则表达式模式。以下正则表达式模式用于搜索电子邮件地址:

pat = r'[\w.+-]+@[\w-]+\.[\w.-]+'

对于此练习,我们将使用以下HTML文档,其中<li>标签包含电子邮件ID。

<html>

<head>

<title>BeautifulSoup - Scraping Email IDs</title>

</head>

<body>

<h2>Contact Us</h2>

<ul>

<li>Sales Enquiries: sales@company.com</a></li>

<li>Careers: careers@company.com</a></li>

<li>Partner with us: partner@company.com</a></li>

</ul>

</body>

</html>

使用电子邮件正则表达式,我们将查找模式在每个<li>标签字符串中的出现情况。以下是Python代码:

示例

from bs4 import BeautifulSoup

import re

def isemail(s):

pat = r'[\w.+-]+@[\w-]+\.[\w.-]+'

grp=re.findall(pat,s)

return (grp)

fp = open("contact.html")

soup = BeautifulSoup(fp, "html.parser")

tags = soup.find_all('li')

for tag in tags:

emails = isemail(tag.string)

if emails:

print (emails)

输出

['sales@company.com'] ['careers@company.com'] ['partner@company.com']

使用上面描述的简单技术,我们可以使用BeautifulSoup从网页中提取电子邮件ID。

Beautiful Soup - 抓取嵌套标签

HTML文档中标签或元素的排列具有层次结构的性质。标签可以嵌套到多个级别。例如,<head>和<body>标签嵌套在<html>标签内。类似地,一个或多个<li>标签可能位于<ul>标签内。在本章中,我们将了解如何抓取具有一个或多个嵌套在其中的子标签的标签。

让我们考虑以下HTML文档:

<div id="outer">

<div id="inner">

<p>Hello<b>World</b></p>

<img src='logo.jpg'>

</div>

</div>

在这种情况下,两个<div>标签和一个<p>标签有一个或多个嵌套在其中的子元素。而<img>和<b>标签没有任何子标签。

findChildren()方法返回标签下所有子元素的ResultSet。因此,如果标签没有任何子元素,则ResultSet将是一个空列表,例如[]。

以此为线索,以下代码查找文档树中每个标签下的标签并显示列表。

示例

html = """

<div id="outer">

<div id="inner">

<p>Hello<b>World</b></p>

<img src='logo.jpg'>

</div>

</div>

"""

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'html.parser')

for tag in soup.find_all():

print ("Tag: {} attributes: {}".format(tag.name, tag.attrs))

print ("Child tags: ", tag.findChildren())

print()

输出

Tag: div attributes: {'id': 'outer'}

Child tags: [<div id="inner">

<p>Hello<b>World</b></p>

<img src="logo.jpg"/>

</div>, <p>Hello<b>World</b></p>, <b>World</b>, <img src="logo.jpg"/>]

Tag: div attributes: {'id': 'inner'}

Child tags: [<p>Hello<b>World</b></p>, <b>World</b>, <img src="logo.jpg"/>]

Tag: p attributes: {}

Child tags: [<b>World</b>]

Tag: b attributes: {}

Child tags: []

Tag: img attributes: {'src': 'logo.jpg'}

Child tags: []

Beautiful Soup - 解析表格

除了文本内容之外,HTML文档还可以以HTML表格的形式包含结构化数据。使用Beautiful Soup,我们可以将表格数据提取到Python对象(例如列表或字典)中,如果需要,可以将其存储在数据库或电子表格中,并执行处理。在本章中,我们将使用Beautiful Soup解析HTML表格。

尽管Beautiful Soup没有用于提取表格数据的任何特殊函数或方法,但我们可以通过简单的抓取技术来实现它。就像任何表格(例如SQL或电子表格中的表格)一样,HTML表格由行和列组成。

HTML使用<table>标签来构建表格结构。有一个或多个嵌套的<tr>标签,每个标签代表一行。每一行都包含<td>标签,用于保存该行每个单元格中的数据。第一行通常用于列标题,标题放在<th>标签而不是<td>标签中。

以下HTML脚本在浏览器窗口中呈现一个简单的表格:

<html>

<body>

<h2>Beautiful Soup - Parse Table</h2>

<table border="1">

<tr>

<th>Name</th>

<th>Age</th>

<th>Marks</th>

</tr>

<tr class='data'>

<td>Ravi</td>

<td>23</td>

<td>67</td>

</tr>

<tr class='data'>

<td>Anil</td>

<td>27</td>

<td>84</td>

</tr>

</table>

</body>

</html>

请注意,数据行的外观使用CSS类data进行了自定义,以便将其与标题行区分开来。

现在我们将了解如何解析表格数据。首先,我们在 BeautifulSoup 对象中获取文档树。然后将所有列标题收集到一个列表中。

示例

from bs4 import BeautifulSoup

soup = BeautifulSoup(markup, "html.parser")

tbltag = soup.find('table')

headers = []

headings = tbltag.find_all('th')

for h in headings: headers.append(h.string)

然后获取在标题行之后具有 class='data' 属性的数据行标签。形成一个字典对象,其中列标题作为键,每个单元格中的对应值作为值,并将该字典对象追加到一个字典对象列表中。

rows = tbltag.find_all_next('tr', {'class':'data'})

trows=[]

for i in rows:

row = {}

data = i.find_all('td')

n=0

for j in data:

row[headers[n]] = j.string

n+=1

trows.append(row)

一个字典对象列表被收集到 trows 中。然后可以将其用于不同的目的,例如存储在 SQL 表中、保存为 JSON 或 pandas DataFrame 对象。

完整的代码如下所示:

markup = """

<html>

<body>

<p>Beautiful Soup - Parse Table</p>

<table>

<tr>

<th>Name</th>

<th>Age</th>

<th>Marks</th>

</tr>

<tr class='data'>

<td>Ravi</td>

<td>23</td>

<td>67</td>

</tr>

<tr class='data'>

<td>Anil</td>

<td>27</td>

<td>84</td>

</tr>

</table>

</body>

</html>

"""

from bs4 import BeautifulSoup

soup = BeautifulSoup(markup, "html.parser")

tbltag = soup.find('table')

headers = []

headings = tbltag.find_all('th')

for h in headings: headers.append(h.string)

print (headers)

rows = tbltag.find_all_next('tr', {'class':'data'})

trows=[]

for i in rows:

row = {}

data = i.find_all('td')

n=0

for j in data:

row[headers[n]] = j.string

n+=1

trows.append(row)

print (trows)

输出

[{'Name': 'Ravi', 'Age': '23', 'Marks': '67'}, {'Name': 'Anil', 'Age': '27', 'Marks': '84'}]

Beautiful Soup - 选择第 n 个子元素

HTML 的特点是标签的层次顺序。例如,<html> 标签包含 <body> 标签,在 <body> 标签内部可能存在 <div> 标签,并且 <div> 标签可能进一步嵌套 <ul> 和 <li> 元素。findChildren() 方法和 .children 属性都返回一个 ResultSet(列表),其中包含元素下所有直接子标签。通过遍历列表,可以获取位于所需位置(第 n 个子元素)的子元素。

下面的代码使用 HTML 文档中 <div> 标签的 children 属性。由于 children 属性的返回类型是列表迭代器,因此我们将从中检索一个 Python 列表。我们还需要从迭代器中删除空格和换行符。完成后,我们可以获取所需的子元素。这里显示了 <div> 标签索引为 1 的子元素。

示例

from bs4 import BeautifulSoup, NavigableString

markup = '''

<div id="Languages">

<p>Java</p> <p>Python</p> <p>C++</p>

</div>

'''

soup = BeautifulSoup(markup, 'html.parser')

tag = soup.div

children = tag.children

childlist = [child for child in children if child not in ['\n', ' ']]

print (childlist[1])

输出

<p>Python</p>

要使用 findChildren() 方法而不是 children 属性,请将语句更改为

children = tag.findChildren()

输出不会有任何变化。

定位第 n 个子元素的更有效方法是使用 select() 方法。select() 方法使用 CSS 选择器从当前元素获取所需的 PageElements。

Soup 和 Tag 对象通过其 .css 属性支持 CSS 选择器,该属性是 CSS 选择器 API 的接口。选择器实现由 Soup Sieve 包处理,该包与 bs4 包一起安装。