如何使用 Matplotlib 正确绘制从 MLPClassifier 获取的损失值 (loss_curve_)?

为了正确绘制从 MLPClassifier 获取的损失值 (loss_curve_),我们可以采取以下步骤:

- 设置图形大小并调整子图之间和周围的填充。

- 创建一个 params,一个字典列表。

- 创建一个标签列表和绘图参数。

- 创建一个图形和一组子图,其中 nrows=2 且 ncols=。

- 加载并返回鸢尾花数据集(分类)。

- 从数据集中获取 x_digits 和 y_digits。

- 获取自定义数据_set,元组列表。

- 迭代 zipped、axes、data_sets 和标题名称列表。

- 在 **plot_on_dataset()** 方法中;设置当前轴的标题。

- 获取多层感知器分类器实例。

- 获取 **mlps**,即 mlpc 实例列表。

- 迭代 **mlps** 并使用 **plot()** 方法绘制 **mlp.loss_curve_**。

- 要显示图形,请使用 **show()** 方法。

示例

import warnings

import matplotlib.pyplot as plt

from sklearn.neural_network import MLPClassifier

from sklearn.preprocessing import MinMaxScaler

from sklearn import datasets

from sklearn.exceptions import ConvergenceWarning

plt.rcParams["figure.figsize"] = [7.50, 3.50]

plt.rcParams["figure.autolayout"] = True

params = [{'solver': 'sgd', 'learning_rate': 'constant', 'momentum': 0, 'learning_rate_init': 0.2},

{'solver': 'sgd', 'learning_rate': 'constant', 'momentum': .9, 'nesterovs_momentum': False, 'learning_rate_init': 0.2},

{'solver': 'sgd', 'learning_rate': 'constant', 'momentum': .9, 'nesterovs_momentum': True, 'learning_rate_init': 0.2},

{'solver': 'sgd', 'learning_rate': 'invscaling', 'momentum': 0, 'learning_rate_init': 0.2},

{'solver': 'sgd', 'learning_rate': 'invscaling', 'momentum': .9, 'nesterovs_momentum': True, 'learning_rate_init': 0.2},

{'solver': 'sgd', 'learning_rate': 'invscaling', 'momentum': .9, 'nesterovs_momentum': False, 'learning_rate_init': 0.2},

{'solver': 'adam', 'learning_rate_init': 0.01}]

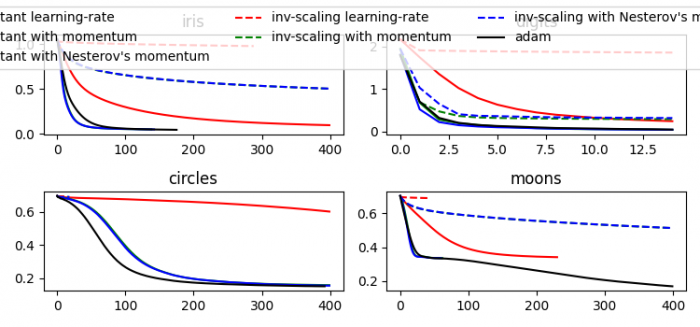

labels = ["constant learning-rate", "constant with momentum", "constant with Nesterov's momentum", "inv-scaling learning-rate", "inv-scaling with momentum", "inv-scaling with Nesterov's momentum", "adam"]

plot_args = [{'c': 'red', 'linestyle': '-'},

{'c': 'green', 'linestyle': '-'},

{'c': 'blue', 'linestyle': '-'},

{'c': 'red', 'linestyle': '--'},

{'c': 'green', 'linestyle': '--'},

{'c': 'blue', 'linestyle': '--'},

{'c': 'black', 'linestyle': '-'}]

def plot_on_dataset(X, y, ax, name):

ax.set_title(name)

X = MinMaxScaler().fit_transform(X)

mlps = []

if name == "digits":

max_iter = 15

else:

max_iter = 400

for label, param in zip(labels, params):

mlp = MLPClassifier(random_state=0, max_iter=max_iter, **param)

with warnings.catch_warnings():

warnings.filterwarnings("ignore", category=ConvergenceWarning, module="sklearn")

mlp.fit(X, y)

mlps.append(mlp)

for mlp, label, args in zip(mlps, labels, plot_args):

ax.plot(mlp.loss_curve_, label=label, **args)

fig, axes = plt.subplots(2, 2)

iris = datasets.load_iris()

X_digits, y_digits = datasets.load_digits(return_X_y=True)

data_sets = [(iris.data, iris.target), (X_digits, y_digits), datasets.make_circles(noise=0.2, factor=0.5, random_state=1), datasets.make_moons(noise=0.3, random_state=0)]

for ax, data, name in zip(axes.ravel(), data_sets,

['iris', 'digits', 'circles', 'moons']):

plot_on_dataset(*data, ax=ax, name=name)

fig.legend(ax.get_lines(), labels, ncol=3, loc="upper center")

plt.show()输出

广告

数据结构

数据结构 网络

网络 关系型数据库管理系统

关系型数据库管理系统 操作系统

操作系统 Java

Java iOS

iOS HTML

HTML CSS

CSS Android

Android Python

Python C 编程

C 编程 C++

C++ C#

C# MongoDB

MongoDB MySQL

MySQL Javascript

Javascript PHP

PHP