- 神经形态计算的应用

- 神经形态计算 - 边缘计算

- 神经形态计算 - 物联网 (IoT)

- 神经形态计算 - 机器人技术

- 神经形态计算 - 自动系统

- 神经形态计算 - AI 和机器学习

- 神经形态计算 - 认知计算

- 神经形态计算资源

- 神经形态计算 - 有用资源

- 神经形态计算 - 讨论

神经形态计算 - 架构

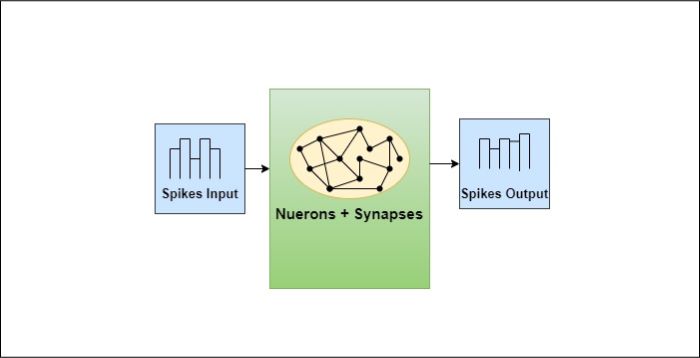

神经形态计算机的架构灵感来源于人脑的功能,其中神经元和突触协同工作,作为一个单元来存储和处理数据。在本节中,我们将讨论神经形态架构的关键组件、工作原理和示例。

神经形态架构的关键组件

- 神经元:神经形态系统中的基本构建块,与生物神经元相同。它们处理信息并通过电脉冲进行通信。

- 突触:神经元之间的连接,允许信号传输。神经形态系统利用可变强度的连接来模拟突触可塑性,从而实现学习和记忆形成。

- 神经元层:正如人脑被组织成层一样,神经形态架构通常具有多层互连的神经元,允许进行复杂的信息处理和表示。

神经形态计算机如何工作?

要理解神经形态计算机的工作原理,首先需要了解大脑中新皮质的功能。新皮质是大脑的一部分,人们认为较高级的认知功能(如感觉知觉、运动指令、空间推理和语言)都发生在新皮质。

新皮质由神经元和突触组成,它们以极快的速度和令人难以置信的效率向大脑发送和传递信息。神经形态计算机通过使用脉冲神经网络 (SNNs) 来实现这种效率。在此处了解更多关于 SNNs 的信息。

示例

这是一个简单的基于 Python 的代码示例,用于解释神经形态计算背后的概念。此示例将模拟人工神经元如何使用脉冲进行通信,这在神经形态系统中可见。我们将使用一个脉冲神经网络模型,其中神经元基于阈值激发,突触权重根据简化的学习规则进行调整。

import numpy as np

# Define parameters

NUM_NEURONS = 5 # Number of neurons in the network

THRESHOLD = 1.0 # Firing threshold for neurons

LEARNING_RATE = 0.1 # Rate at which synaptic weights are adjusted

TIMESTEPS = 10 # Number of simulation steps

# Initialize synaptic weights (connections between neurons)

synaptic_weights = np.random.rand(NUM_NEURONS, NUM_NEURONS)

# Initialize neuron states (0 means no spike, 1 means spike)

neuron_states = np.zeros(NUM_NEURONS)

# Simple learning rule: Update synapse weights based on spikes

def update_weights(pre_neuron, post_neuron):

if neuron_states[pre_neuron] == 1: # Pre-neuron spiked

if neuron_states[post_neuron] == 1: # Post-neuron also spiked

# Strengthen the synapse (positive reinforcement)

synaptic_weights[pre_neuron, post_neuron] += LEARNING_RATE

else:

# Weaken the synapse (negative reinforcement)

synaptic_weights[pre_neuron, post_neuron] -= LEARNING_RATE

synaptic_weights[pre_neuron, post_neuron] = np.clip(synaptic_weights[pre_neuron, post_neuron], 0, 1)

# Simulation loop

for t in range(TIMESTEPS):

print(f"Timestep {t + 1}:")

# Simulate neuron input as random values

inputs = np.random.rand(NUM_NEURONS)

# Update neuron states based on inputs and synaptic weights

for neuron in range(NUM_NEURONS):

# Calculate total input to the neuron from synapses

total_input = np.dot(synaptic_weights[:, neuron], neuron_states) + inputs[neuron]

# Determine if the neuron fires (spikes)

if total_input > THRESHOLD:

neuron_states[neuron] = 1 # Neuron fires

else:

neuron_states[neuron] = 0 # Neuron does not fire

print(f"Neuron states: {neuron_states}")

print(f"Synaptic weights: \n{synaptic_weights}\n")

# Update synaptic weights based on spikes (learning)

for pre_neuron in range(NUM_NEURONS):

for post_neuron in range(NUM_NEURONS):

update_weights(pre_neuron, post_neuron)

解释

这是一个简单的 Python 代码,它实现了一个 Hebbian 学习规则。Hebbian 学习是一种生物启发的学习规则,它指出一起激发的神经元会连接在一起。换句话说,如果两个神经元同时活跃,则它们之间的连接就会加强。该网络由通过突触(具有权重)连接的多个神经元组成,每个神经元都可以根据其接收的总输入而“激发”或“脉冲”。

- 定义参数:最初,我们定义所有参数,例如神经网络的神经元数量、阈值和学习率。

- 学习规则:函数 update_weights(pre_neuron, post_neuron):更新两个神经元之间的突触权重。如果前神经元激发而后神经元也激发,则权重增加(正强化)。如果只有前神经元激发,则权重减小(负强化)。换句话说,此函数实现了上面提到的“一起激发,连接在一起”的功能。

- 仿真循环:在每个时间步长,都会为每个神经元生成随机输入值。此输入模拟神经元的外部刺激。

神经形态芯片示例

- IBM TrueNorth:一种数字神经形态芯片,设计用于模拟一百万个神经元和超过 2.56 亿个突触,从而实现复杂的神经网络计算。

- 英特尔 Loihi:一种研究芯片,它使用脉冲神经网络模型进行片上学习和实时处理能力。

- SpiNNaker:一种神经形态计算平台,设计用于模拟大规模类脑计算,利用数千个低功耗处理核心。

广告