- Chainer 教程

- Chainer - 首页

- Chainer - 简介

- Chainer - 安装

- Chainer 基本概念

- Chainer - 神经网络

- Chainer - 创建神经网络

- Chainer - 核心组件

- Chainer - 计算图

- Chainer - 动态图与静态图

- Chainer - 前向和反向传播

- Chainer - 训练与评估

- Chainer - 高级特性

- Chainer - 与其他框架的集成

- Chainer 有用资源

- Chainer - 有用资源

- Chainer - 讨论

Chainer - 动态图与静态图

动态图

动态图也称为运行时定义 (Define-by-Run) 图,是 Chainer 的核心特性,它将 Chainer 与其他深度学习框架区分开来。与在任何计算之前就预定义的静态图不同,动态图是在计算过程中动态构建的。这种方法提供了一些优势,尤其是在处理需要灵活性和适应性的复杂模型时。

Chainer 中动态图的关键特性

以下是 Chainer 中动态图的关键特性:

- 实时图构建:在 Chainer 中,计算图是在程序执行期间动态构建的。这种实时构建允许图立即适应执行的操作,从而更容易处理需要灵活性的模型。

- 模型设计的灵活性:Chainer 计算图的动态特性支持创建具有可变结构的模型,例如包含循环、条件语句或输入大小不同的模型。这种灵活性对于序列处理和高级神经网络架构等任务特别有利。

- 高效的内存管理:Chainer 的图构建方法允许它更有效地管理内存,因为图只在需要时才存在。一旦操作完成,与其相关的资源就可以释放,从而减少整体内存占用。

- 无缝集成控制流:Chainer 的运行时定义模型允许轻松地将控制流元素(如 if-else 语句和循环)直接整合到网络中。这种集成支持需要动态决策和分支逻辑的复杂模型。

- 即时调试反馈:由于图是在运行时构建的,因此网络中的任何问题或错误都会立即显示出来,从而简化了调试过程。这种即时反馈循环有利于试验不同的模型架构并快速迭代设计。

- 支持复杂和自定义操作:Chainer 的动态图可以通过创建高度专业化的网络组件来处理自定义和复杂的操作。这种能力对于推动标准神经网络设计边界的研发和应用至关重要。

- 简化的梯度计算:在反向传播过程中,Chainer 使用动态生成的图来高效地计算梯度。这确保了模型参数的准确和及时更新,即使网络结构在训练过程中发生变化。

- 易于原型设计和实验:Chainer 的动态图系统非常适合原型设计新想法,因为它允许快速测试和调整不同的模型配置,而无需预定义整个网络结构。

动态图的优势

Chainer 中的动态计算图提供了许多实际优势,增强了模型开发和实验的灵活性和效率。让我们详细了解它们:

- 研究灵活性:Chainer 特别适合需要自由试验不同网络架构或调整现有模型的研究人员和开发人员。动态图特性允许轻松修改,从而实现创新方法并快速测试新想法。

- 处理变长序列:Chainer 的动态图在自然语言处理或时间序列预测等应用中特别有用,其中输入序列的长度可能不同。能够根据需要调整模型以适应这些变化,而无需进行大量的重新配置,这是一个显著的优势。

- 快速原型设计:Chainer 的运行时定义方法支持快速原型设计和迭代开发。开发人员可以根据需要修改模型结构,而无需重新编译或预定义整个计算图,从而简化了开发过程,并允许进行更快的实验。

示例

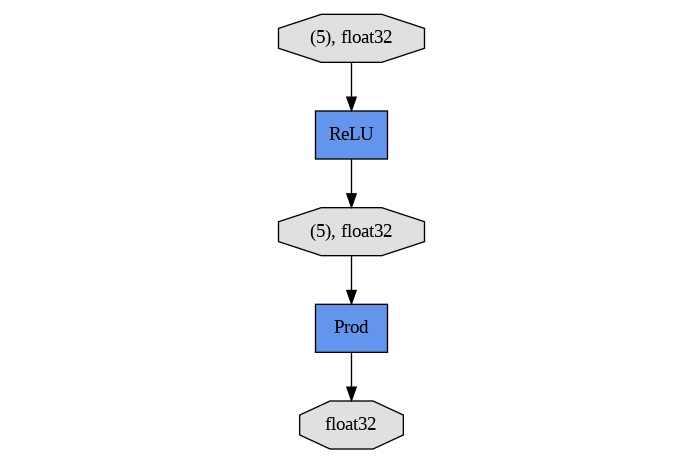

以下是一个演示 Chainer 中动态图概念的示例,其中计算图是根据输入或其他条件动态构建的。这种灵活性对于在执行过程中涉及决策的模型特别有用,例如根据运行时数据选择不同的层或操作:

import chainer

import chainer.functions as F

from chainer import Variable

from chainer.computational_graph import build_computational_graph

import numpy as np

from IPython.display import Image

# Define a function that uses dynamic control flow

def dynamic_graph_example(x, apply_relu):

# Dynamic control flow: If apply_relu is True, use ReLU; otherwise, use Sigmoid

if apply_relu:

h = F.relu(x)

else:

h = F.sigmoid(x)

# Another dynamic decision: apply a different operation

if x.array.mean() > 0:

y = F.sum(h)

else:

y = F.prod(h)

return y

# Create a Variable (input) with random values

x = Variable(np.random.randn(5).astype(np.float32))

# Example 1: Apply ReLU and check the dynamic behavior

apply_relu = True

result_1 = dynamic_graph_example(x, apply_relu)

# Build the computational graph for the first result

g1 = build_computational_graph([result_1])

# Save the graph to a file

with open('dynamic_graph_relu.dot', 'w') as f:

f.write(g1.dump())

print("Graph with ReLU has been saved as dynamic_graph_relu.dot")

# To convert .dot to .png using graphviz (in terminal or command prompt):

!dot -Tpng dynamic_graph_relu.dot -o dynamic_graph_relu.png

Image('dynamic_graph_relu.png')

以下是显示 Chainer 框架中动态图的输出:

Graph with ReLU has been saved as dynamic_graph_relu.dot

静态图

在 Chainer 中,默认行为是动态构建计算图。这意味着图是在前向传播过程中动态构建的,允许灵活地定义和执行模型。但是,静态图是指在执行任何计算之前就预定义并固定的图。

虽然 Chainer 本身并不原生支持静态图作为主要特性,但我们仍然可以通过避免动态控制流和条件操作来在 Chainer 中实现类似静态图的行为。

静态图的特性

在静态图方法中,计算图的结构是在模型执行之前预定义的,并且在整个模型执行过程中保持不变。这种方法与动态图形成对比,在动态图中,图可以根据数据和执行的计算进行调整。以下是静态图的关键特性:

- 预定义结构:计算图在处理任何数据之前都已完全定义。操作和数据流的安排是预先确定的,并且保持不变。

- 固定架构:网络的架构,包括所有层及其连接,都在预先指定。此架构不会根据运行时的输入或中间结果而改变。

- 没有动态行为:静态图不包含控制流结构,例如循环或条件语句,这些结构可能会在执行期间修改图的结构。所有操作都是预先确定和固定的。

- 一致的执行:模型的每次执行都遵循相同的图结构,这可以简化优化和调试。执行的一致性是由于图的性质不变。

- 预定义的执行计划:在任何实际数据处理开始之前,执行计算的计划就已经建立。这允许优化和高效执行,因为执行路径是预先知道的。

在 Chainer 中模拟静态图

虽然 Chainer 的优势在于其动态图构建,但我们可以通过遵循以下原则来设计我们的模型,使其模拟静态图:

- 避免条件操作:确保模型不包含任何根据输入数据或中间计算更改网络结构的条件语句或控制流。

- 预定义所有操作:所有层和操作都应该在模型的开始处定义。数据通过这些操作的流程应该是固定的,并且不依赖于运行时条件。

静态图的优势

- 优化的性能:由于图的结构是固定的,因此可以更有效地应用优化技术,例如图剪枝、操作融合和高效的内存分配。

- 可预测的执行:缺乏动态控制流确保执行路径是一致的,这简化了调试和分析,因为模型行为是可预测的。

- 增强的调试:通过固定的结构,更容易跟踪和诊断计算中的问题,从而导致更直接的调试和错误跟踪。

- 更容易的模型共享:静态图更容易在不同的平台和环境之间共享和重用,因为计算图不会根据输入或运行时条件而改变。

- 高效的资源利用:静态图允许预编译优化和资源分配,这可能会提高运行时效率并减少计算开销。

示例

以下是在 Chainer 中生成静态计算图的示例:

import chainer

import chainer.functions as F

import chainer.links as L

from chainer import Variable, Chain

from chainer.computational_graph import build_computational_graph

import numpy as np

from IPython.display import Image

# Define a model with a fixed architecture

class StaticGraphModel(Chain):

def __init__(self):

super(StaticGraphModel, self).__init__()

with self.init_scope():

self.l1 = L.Linear(None, 5) # Input to hidden layer with 5 units

self.l2 = L.Linear(5, 2) # Hidden layer to output with 2 units

def forward(self, x):

h = F.relu(self.l1(x)) # Apply ReLU activation

y = self.l2(h) # Linear transformation to output

return y

# Instantiate the model

model = StaticGraphModel()

# Create input variables

x = Variable(np.random.rand(3, 4).astype(np.float32)) # Batch of 3, 4 features each

# Forward pass (builds the computational graph)

y = model.forward(x)

# Build the computational graph

g = build_computational_graph([y])

# Save the graph to a file

with open('static_graph.dot', 'w') as f:

f.write(g.dump())

print("Static graph has been saved as static_graph.dot")

# To convert .dot to .png using graphviz (in terminal or command prompt):

!dot -Tpng static_graph.dot -o static_graph.png

Image("static_graph.png")

在 Chainer 中创建的静态图显示如下:

Static graph has been saved as static_graph.dot

动态图与静态图

以下是动态图和静态图的区别:

| 方面 | 动态图 | 静态图 |

|---|---|---|

| 定义 | 在每次前向传播期间动态构建。 | 在执行之前定义一次,之后重复使用。 |

| 灵活性 | 非常灵活,允许每次传递不同的结构。 | 灵活性较低,需要固定的结构。 |

| 示例框架 | Chainer,PyTorch | TensorFlow (2.0 之前版本),Theano |

| 优势 |

|

|

| 劣势 |

|

|

| 用例 | 研究,自然语言处理,序列到序列任务。 | 生产,具有稳定模型结构的任务。 |

| 执行 | 图结构在每次执行期间都可能发生变化。 | 所有执行都使用相同的图结构。 |

| 优化 | 由于动态特性,优化有限。 | 可以进行大量的优化以提高性能。 |