Google Colab:低配置设备运行机器学习

在过去的几年里,计算机视觉、自然语言处理和语音识别等多个领域的进步,使得机器学习 (ML) 领域越来越受欢迎。然而,运行模型和算法需要强大的硬件,这是 ML 从业者面临的最大挑战之一。

这会严重阻碍那些无法使用强大计算机的人完成任务的能力。然而,由于 Google Colab 的出现,在低端设备上运行 ML 模型变得更加容易。

那么,什么是 Google Colab?

Google Colab 是一款基于云的服务,是 Jupyter Notebook 环境中运行代码的最佳选择。Jupyter Notebook 是一款开源的 Web 应用程序,允许你创建和共享包含实时代码、方程式、可视化和叙述性材料的页面。通过 Google Colab,你可以访问预配置的包含 Python 和许多其他流行数据科学工具的 Jupyter Notebook 环境。无需额外的设置时间,你就可以立即开始工作。

但这还不是全部。访问强大的硬件是 Google Colab 最重要的优势之一。告别低端硬件,欢迎使用 GPU 和 TPU!这些硬件资源非常适合加快 ML 模型训练速度,这在处理大型数据集时至关重要。现在,借助 Google Colab,你可以比以往更有效地运行你的 ML 模型。Jupyter Notebook 环境与强大硬件的完美结合将使你的工作提升到一个新的水平。

开始使用 Google Colab

要开始使用 Google Colab,你需要一个 Google 帐户。登录你的 Google 帐户后,单击以下链接访问 Google Colab:

访问 Colaboratory.com!访问 Google Colab 后,要开始一个新的笔记本,请从菜单中选择“新建笔记本”。生成的新的 Jupyter Notebook 可用于创建和运行程序。

使用 Google Colab 进行机器学习

创建 Google Colab 笔记本后,首先要连接到服务。连接按钮位于右上角,它将帮助你使用服务并将 RAM 内存和磁盘空间分配到你的特定项目。

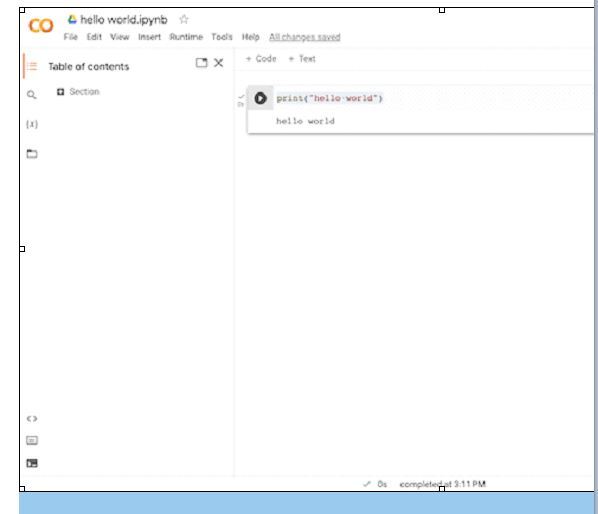

现在你可以编写程序了,这是一个 Python 的“Hello World”程序。

Google Colab for ML 的一个主要优势是它为用户提供了强大的硬件访问权限。对于处理大型数据集的用户来说,这尤其有用,因为训练 ML 模型需要大量的资源。

可以安装所需的库和依赖项。幸运的是,一些流行的数据科学库,如 NumPy、pandas 和 TensorFlow,已经预装在 Google Colab 中。

使用 GPU 和 TPU 的 Google Colab

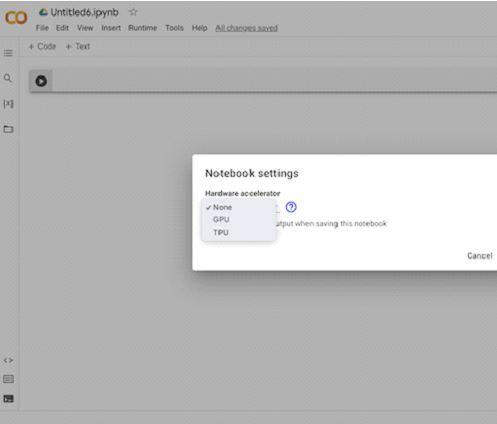

使用 Google Colab 进行 ML 的另一个重要优势是能够访问 GPU 和 TPU。这些工具可以用来加速 ML 模型训练,这对于处理大型数据集的用户非常有用。

你可以通过转到“运行时”>“更改运行时类型”来使用 GPU 和 TPU。

要使用 Google Colab 中的 GPU 或 TPU,必须从“运行时”选项中选择正确的硬件加速器。一旦选择了硬件加速器,你就可以开始使用可用的资源来训练你的模型。在 Google Colab 中使用 GPU 或 TPU 时,需要注意的是,所有用户共享这些资源。因此,如果许多用户都在同一个 GPU 或 TPU 上运行模型,你可能会注意到性能下降。

结论

总之,Google Colab 是一种有效的解决方案,可以帮助 ML 专业人员克服在过时硬件上运行模型相关的挑战。Google Colab 通过其预设环境、对强大硬件的访问以及各种预装库,使 ML 的入门和在云端运行复杂模型变得容易。对于每个数据科学家,无论新手还是专家,Google Colab 都是必不可少的工具。

数据结构

数据结构 网络

网络 关系数据库管理系统 (RDBMS)

关系数据库管理系统 (RDBMS) 操作系统

操作系统 Java

Java iOS

iOS HTML

HTML CSS

CSS Android

Android Python

Python C语言编程

C语言编程 C++

C++ C#

C# MongoDB

MongoDB MySQL

MySQL Javascript

Javascript PHP

PHP