XGBoost - 历史与架构

XGBoost,或极端梯度提升,是一种使用梯度提升框架的机器学习方法。它提供诸如正则化以防止过拟合、缺失数据管理以及允许用户定义自己的优化目标和标准的可定制方法等功能。

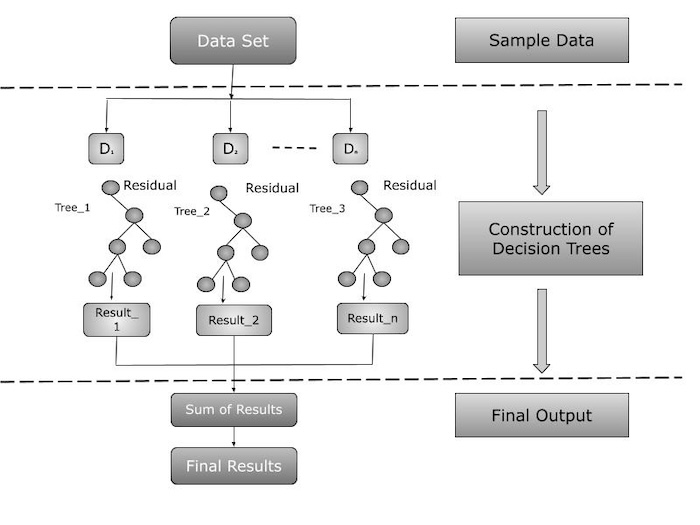

XGBoost 的架构

XGBoost 的架构以其可扩展且高效的梯度提升决策树实现而脱颖而出。它包括诸如正则化以防止过拟合、缺失数据管理以及允许用户创建自己的优化目标和标准的可定制方法等功能。这些功能有助于提高预测模型的稳健性和准确性。

其架构大致可以分为两个主要组成部分:

顺序学习

XGBoost 通常使用决策树作为其基础学习。每个后续树都是建立在上一个树的错误之上的,重点关注被错误分类的数据点。该方法使用梯度下降来查找每棵树的最佳权重,同时最小化损失函数。

集成

XGBoost 生成一个决策树集成,并结合它们的预测以提高整体准确性。最终预测是所有树预测的加权和,并根据性能进行加权。

XGBoost 架构的关键特性

XGBoost 架构显示其主要组件和互连。以下是架构特性的概述:

正则化:XGBoost 使用正则化技术来避免过拟合。

并行处理:它采用并行处理来加速训练。

灵活:它可以处理回归和分类问题。

高性能:XGBoost 在各种机器学习竞赛中 consistently 表现出色。

XGBoost 学习类型

XGBoost 主要依赖于监督学习,这涉及从标记数据中学习。此方法需要在同时具有输入特征和输出标签的数据集上构建模型。此训练帮助模型理解输入和输出之间的关系,从而允许它根据以前未知的数据进行预测或分类。

XGBoost 擅长处理结构化数据,通常用于回归(预测连续值)和分类(预测离散标签)。

XGBoost 算法方法

XGBoost 的算法基础基于基于树的技术,主要是梯度提升。梯度提升是一种集成技术,它按顺序创建多个决策树,每棵树都试图纠正前面树的任何弱点。这从大量弱学习器中创建了一个强学习器,从而提高了模型的整体准确性和稳健性。

XGBoost 以将其正则化技术结合到其梯度提升框架中而闻名。正则化(L1 和 L2)用于防止过拟合并提高模型对新数据的适应性。此外,XGBoost 在树构建过程中优化损失函数,这对于回归和分类任务中的有效学习至关重要。

XGBoost 在许多类型的机器学习应用程序中的有效性和普及性可以归因于其监督学习和复杂的基于树的梯度提升策略的结合,并通过正则化方法得到增强。

总结

XGBoost 是一种强大的机器学习算法,它通过生成和组合多个决策树来改进预测。它在 2010 年代中期赢得了多次竞赛后而流行起来。XGBoost 适用于结构化数据,可以解决回归和分类问题,并使用正则化方法来避免过拟合。