- 生成式AI教程

- 生成式AI - 首页

- 生成式AI基础

- 生成式AI基础

- 生成式AI发展史

- 机器学习与生成式AI

- 生成式AI模型

- 判别式模型与生成式模型

- 生成式AI模型类型

- 概率分布

- 概率密度函数

- 最大似然估计

- 生成式AI网络

- GAN的工作原理?

- GAN - 架构

- 条件GAN

- StyleGAN和CycleGAN

- 训练GAN

- GAN应用

- 生成式AI Transformer

- Transformer在生成式AI中的应用

- Transformer在生成式AI中的架构

- Transformer中的输入嵌入

- 多头注意力机制

- 位置编码

- 前馈神经网络

- Transformer中的残差连接

- 生成式AI自编码器

- 自编码器在生成式AI中的应用

- 自编码器类型及应用

- 使用Python实现自编码器

- 变分自编码器

- 生成式AI与ChatGPT

- 一个生成式AI模型

- 生成式AI杂项

- 生成式AI在制造业中的应用

- 生成式AI为开发者赋能

- 生成式AI在网络安全中的应用

- 生成式AI在软件测试中的应用

- 生成式AI在市场营销中的应用

- 生成式AI在教育领域的应用

- 生成式AI在医疗保健领域的应用

- 生成式AI为学生赋能

- 生成式AI在工业领域的应用

- 生成式AI在电影制作中的应用

- 生成式AI在音乐创作中的应用

- 生成式AI在烹饪领域的应用

- 生成式AI在媒体领域的应用

- 生成式AI在通信领域的应用

- 生成式AI在摄影领域的应用

- 生成式AI资源

- 生成式AI - 有用资源

- 生成式AI - 讨论

自编码器在生成式AI中的应用

自编码器是**机器学习**和**深度学习**领域中必不可少的工具。它们是一种特殊的无监督前馈神经网络,旨在学习数据的有效表示,用于降维、特征提取和生成新数据。

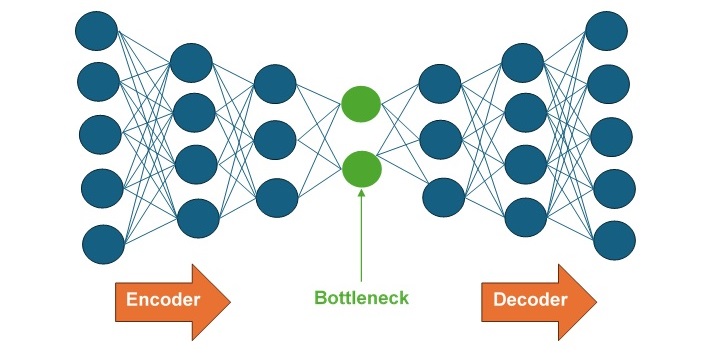

自编码器由两个部分组成:编码器网络和解码器网络。编码器网络充当压缩单元,将输入数据压缩成低维表示。另一方面,解码器网络通过重建来解压缩压缩的输入数据。阅读本章节,了解自编码器、其架构、工作原理、训练过程和超参数调整。

什么是自编码器?

专为无监督学习设计的自编码器属于**人工神经网络**的一种。与任何其他神经网络一样,它由三种不同类型的层组成——输入层、隐藏层和输出层。输入层中的输入单元数量与输出层中的输出单元数量完全相同。但是,该网络中的中间层,即隐藏层,其单元数量少于输入层和输出层。

它首先将输入数据压缩成低维表示。由于隐藏层单元数量较少,因此它包含这种低维表示。最后,在输出层,从这种简化的输入表示中重建输出。

自编码器也被称为自监督机器学习模型,因为它们像监督机器学习模型一样进行训练,但在使用时,它们像无监督机器学习模型一样工作。

自编码器的架构

自编码器的核心架构分为编码器、解码器和瓶颈层,如下图所示:

- 编码器 - 编码器是一个全连接前馈神经网络 (FFNN),它将输入数据压缩成低维表示。

- 瓶颈层 - 瓶颈层包含输入的低维表示,将被馈送到解码器。

- 解码器 - 解码器是一个全连接前馈神经网络 (FFNN),它将输入重建回原始维度。

自编码器的工作原理

自编码器工作原理的核心是训练神经网络从低维表示中重建其输入数据。这涉及两个主要组件:编码器网络和解码器网络。

编码器网络

编码器网络将输入压缩成低维表示。此过程包括以下步骤:

- 输入层 - 输入数据通过输入层馈入网络。

- 隐藏层 - 输入数据现在通过多个隐藏层,其中每一层首先应用线性变换,然后应用非线性激活函数。每一层的神经元数量都少于前一层,从而逐渐降低输入数据的维度。

- 瓶颈层(潜在空间表示) - 瓶颈层是编码器网络的最后一层,存储输入的压缩表示。由于该层的维度远低于输入数据,因此它有助于网络学习输入的最重要特征。

解码器网络

解码器网络从低维表示中重建原始输入数据。这个过程基本上是编码过程的逆过程。它包括以下步骤:

- 瓶颈层(潜在空间表示) - 瓶颈层存储的压缩数据用作解码器网络的输入。

- 隐藏层 - 输入数据现在通过多个隐藏层,其中每一层首先应用线性变换,然后应用非线性激活函数。每一层的神经元数量都多于前一层,从而逐渐将输入数据的维度扩展回原始输入大小。

- 输出层 - 输出层是解码器网络的最后一层,它重建数据以匹配原始输入维度。

训练过程

将网络训练成从低维表示中重建其输入数据,其过程包括以下步骤:

- 初始化 - 首先,网络的权重被随机初始化。

- 前向传播 - 在此步骤中,输入数据首先通过编码器转换为低维数据,然后通过解码器重建为原始数据。

- 损失计算 - 损失函数用于衡量原始输入数据与其重建输出之间的差异。一些常见的损失函数包括用于连续数据的均方误差 (MSE) 或用于二元数据的二元交叉熵。

- 反向传播 - 在此步骤中,为了最小化损失函数,网络会调整其权重。您可以使用梯度下降或任何其他优化算法。

超参数调整

自编码器中的超参数调整是选择控制自编码器工作方式的最佳参数集的过程。适当的超参数调整可以提高自编码器的效率和准确性。

下面列出了一些需要考虑的关键超参数:

- 学习率 - 它决定了使用优化算法最小化损失函数时的步长。较高的学习率可能导致更快的收敛,但稳定性较差。另一方面,较低的学习率可能导致收敛速度较慢,但稳定性更好。

- 批量大小 - 它指定每次迭代中使用的训练样本数量。较大的批量大小可以提供更精确的梯度估计,但需要更多内存和计算资源。

- 层数 - 它指定自编码器架构的深度。更多层可以捕获更复杂的特征,但它们可能导致过拟合。

- 每层神经元数量 - 它决定每一层中的单元数量。每一层中更多的神经元可以学习更多细节,但这会增加模型的复杂性。

- 激活函数 - 这些是应用于每一层输出的数学函数。不同的激活函数(如ReLU、Sigmoid、Tanh)会影响模型的性能。

结论

自编码器将输入数据压缩成低维表示,然后从这种简化的输入表示中重建输出。我们讨论了自编码器的工作原理及其架构。了解自编码器的架构及其工作原理,机器学习从业者可以开启数据分析的新可能性并提高模型性能。

我们还讨论了自编码器中的超参数调整。一些关键的超参数包括学习率、批量大小、层数、每层神经元数量和激活函数。这些超参数的调整会影响自编码器的效率和准确性。