- 生成式AI教程

- 生成式AI - 首页

- 生成式AI基础

- 生成式AI基础

- 生成式AI发展

- 机器学习与生成式AI

- 生成式AI模型

- 判别式模型与生成式模型

- 生成式AI模型类型

- 概率分布

- 概率密度函数

- 最大似然估计

- 生成式AI网络

- GAN的工作原理?

- GAN架构

- 条件GAN

- StyleGAN和CycleGAN

- 训练GAN

- GAN应用

- 生成式AI Transformer

- Transformer在生成式AI中的应用

- Transformer在生成式AI中的架构

- Transformer中的输入嵌入

- 多头注意力机制

- 位置编码

- 前馈神经网络

- Transformer中的残差连接

- 生成式AI自编码器

- 自编码器在生成式AI中的应用

- 自编码器类型及应用

- 使用Python实现自编码器

- 变分自编码器

- 生成式AI和ChatGPT

- 一个生成式AI模型

- 生成式AI杂项

- 生成式AI在制造业中的应用

- 生成式AI在开发人员中的应用

- 生成式AI在网络安全中的应用

- 生成式AI在软件测试中的应用

- 生成式AI在市场营销中的应用

- 生成式AI在教育领域的应用

- 生成式AI在医疗保健领域的应用

- 生成式AI在学生中的应用

- 生成式AI在工业中的应用

- 生成式AI在电影制作中的应用

- 生成式AI在音乐创作中的应用

- 生成式AI在烹饪中的应用

- 生成式AI在媒体领域的应用

- 生成式AI在通信领域的应用

- 生成式AI在摄影领域的应用

- 生成式AI资源

- 生成式AI - 有用资源

- 生成式AI - 讨论

CycleGAN和StyleGAN

阅读本章以了解CycleGAN和StyleGAN,以及它们在生成和转换图像方面的卓越能力。

什么是循环生成对抗网络?

CycleGAN,简称循环一致生成对抗网络,是一种旨在将一个图像的特征转移到另一个图像的GAN框架。换句话说,CycleGAN设计用于非配对图像到图像的转换任务,其中输入和输出图像之间没有关系。

与需要配对训练数据的传统GAN相比,CycleGAN可以在没有任何监督的情况下学习两个不同领域之间的映射。

CycleGAN如何工作?

CycleGAN的工作原理在于它将问题视为图像重建问题。让我们了解它是如何工作的:

- CycleGAN首先获取一个图像输入,例如“X”。然后,它使用生成器,例如“G”,将输入图像转换为重建图像。

- 重建完成后,它借助另一个生成器,例如“F”,将重建图像反向转换为原始图像。

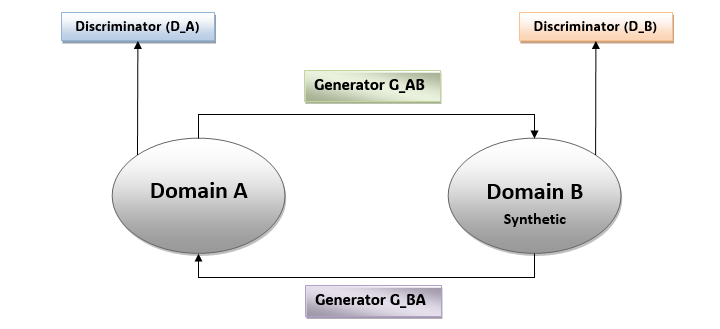

CycleGAN的架构

与传统的GAN一样,CycleGAN也包含两个部分——生成器和判别器。但除了这两个组件之外,CycleGAN还引入了循环一致性的概念。让我们详细了解CycleGAN的这些组件:

生成器网络 (G_AB 和 G_BA)

CycleGAN有两个生成器网络,例如G_AB和G_BA。这些生成器将图像从领域A转换为领域B,反之亦然。它们负责最小化原始图像和转换图像之间的重建误差。

判别器网络 (D_A 和 D_B)

CycleGAN有两个判别器网络,例如D_A和D_B。这些判别器分别区分领域A和B中真实图像和转换图像。它们负责使用对抗性损失来提高生成图像的真实性。

循环一致性损失

CycleGAN引入了第三个组件,称为循环一致性损失。它强制执行领域A和B中真实图像和转换图像之间的一致性。借助循环一致性损失,生成器学习两个领域之间有意义的映射,并确保生成图像的真实性。

下面是CycleGAN的示意图:

CycleGAN的应用

CycleGAN应用于各种图像到图像的转换任务,包括:

- 风格迁移 - CycleGAN可用于在不同领域之间转移图像的风格。这包括将照片转换为绘画、日景转换为夜景以及航拍照片转换为地图等。

- 领域自适应 - CycleGAN可用于将基于合成数据训练的模型适应于真实世界数据。这提高了在各种任务(如目标检测和语义分割)中的泛化能力和性能。

- 图像增强 - CycleGAN可用于通过去除伪影、调整颜色和改善视觉美感来增强图像质量。

什么是StyleGAN?

StyleGAN,简称风格生成对抗网络,是由NVIDIA开发的一种GAN框架。StyleGAN专门设计用于生成逼真的高质量图像。

与传统的GAN相比,StyleGAN引入了一些创新的技术来改进图像合成,并对特定属性具有更好的控制。

StyleGAN的架构

StyleGAN使用传统的渐进式GAN架构,并在其生成器部分进行了一些修改。判别器部分几乎与传统的渐进式GAN相同。让我们了解StyleGAN架构的不同之处:

渐进式增长

与传统的GAN相比,StyleGAN使用渐进式增长策略,在此策略的帮助下,生成器和判别器网络在训练过程中逐渐增加大小和复杂性。这种渐进式增长允许StyleGAN生成更高分辨率的图像(高达1024x1024像素)。

映射网络

为了控制生成图像的风格和外观,StyleGAN使用映射网络。这个映射网络将输入潜在空间向量转换为中间潜在向量。

合成网络

StyleGAN还包含一个合成网络,它接收映射网络生成的中间潜在向量并生成最终图像输出。合成网络由一系列具有自适应实例归一化的卷积层组成,使模型能够生成具有细小细节的高质量图像。

风格混合正则化

StyleGAN还在训练过程中引入了风格混合正则化,它允许模型组合来自多个潜在向量的不同风格。风格混合正则化的优点是它增强了生成输出图像的真实性。

StyleGAN的应用

StyleGAN应用于各种领域,包括:

艺术渲染

由于对年龄、性别和面部表情等特定属性具有更好的控制,StyleGAN可用于创建逼真的肖像、艺术作品和其他类型的图像。

时尚与设计

StyleGAN可用于生成各种服装设计、纹理和风格。此功能使StyleGAN成为时尚设计和虚拟试穿应用中的宝贵模型。

面部变形

StyleGAN为我们提供了不同面部属性之间平滑变形的可能性。此功能使StyleGAN可用于年龄预测、性别转换和面部表情转移等应用。

结论

本章解释了传统生成对抗网络的两个不同变体,即CycleGAN和StyleGAN。

CycleGAN设计用于非配对图像到图像的转换任务,其中输入和输出图像之间没有关系,而StyleGAN专门设计用于生成逼真的高质量图像。

了解CycleGAN和StyleGAN背后的架构和创新,使我们能够深入了解它们创建逼真输出图像的潜力。