- 机器学习基础

- ML - 首页

- ML - 简介

- ML - 入门

- ML - 基本概念

- ML - 生态系统

- ML - Python 库

- ML - 应用

- ML - 生命周期

- ML - 必备技能

- ML - 实现

- ML - 挑战与常见问题

- ML - 限制

- ML - 现实生活中的例子

- ML - 数据结构

- ML - 数学

- ML - 人工智能

- ML - 神经网络

- ML - 深度学习

- ML - 获取数据集

- ML - 分类数据

- ML - 数据加载

- ML - 数据理解

- ML - 数据准备

- ML - 模型

- ML - 监督学习

- ML - 无监督学习

- ML - 半监督学习

- ML - 强化学习

- ML - 监督学习与无监督学习

- 机器学习数据可视化

- ML - 数据可视化

- ML - 直方图

- ML - 密度图

- ML - 箱线图

- ML - 相关矩阵图

- ML - 散点矩阵图

- 机器学习统计学

- ML - 统计学

- ML - 均值、中位数、众数

- ML - 标准差

- ML - 百分位数

- ML - 数据分布

- ML - 偏度和峰度

- ML - 偏差和方差

- ML - 假设

- 机器学习中的回归分析

- ML - 回归分析

- ML - 线性回归

- ML - 简单线性回归

- ML - 多元线性回归

- ML - 多项式回归

- 机器学习中的分类算法

- ML - 分类算法

- ML - 逻辑回归

- ML - K近邻算法 (KNN)

- ML - 朴素贝叶斯算法

- ML - 决策树算法

- ML - 支持向量机

- ML - 随机森林

- ML - 混淆矩阵

- ML - 随机梯度下降

- 机器学习中的聚类算法

- ML - 聚类算法

- ML - 基于中心点的聚类

- ML - K均值聚类

- ML - K中心点聚类

- ML - 均值漂移聚类

- ML - 层次聚类

- ML - 基于密度的聚类

- ML - DBSCAN聚类

- ML - OPTICS聚类

- ML - HDBSCAN聚类

- ML - BIRCH聚类

- ML - 亲和传播

- ML - 基于分布的聚类

- ML - 凝聚层次聚类

- 机器学习中的降维

- ML - 降维

- ML - 特征选择

- ML - 特征提取

- ML - 向后剔除法

- ML - 前向特征构造

- ML - 高相关性过滤器

- ML - 低方差过滤器

- ML - 缺失值比率

- ML - 主成分分析

- 强化学习

- ML - 强化学习算法

- ML - 利用与探索

- ML - Q学习

- ML - REINFORCE算法

- ML - SARSA强化学习

- ML - 演员-评论家方法

- 深度强化学习

- ML - 深度强化学习

- 量子机器学习

- ML - 量子机器学习

- ML - 使用Python的量子机器学习

- 机器学习杂项

- ML - 性能指标

- ML - 自动工作流

- ML - 提升模型性能

- ML - 梯度提升

- ML - 自举汇聚 (Bagging)

- ML - 交叉验证

- ML - AUC-ROC曲线

- ML - 网格搜索

- ML - 数据缩放

- ML - 训练和测试

- ML - 关联规则

- ML - Apriori算法

- ML - 高斯判别分析

- ML - 成本函数

- ML - 贝叶斯定理

- ML - 精确率和召回率

- ML - 对抗性

- ML - 堆叠

- ML - 时期

- ML - 感知器

- ML - 正则化

- ML - 过拟合

- ML - P值

- ML - 熵

- ML - MLOps

- ML - 数据泄露

- ML - 机器学习的盈利化

- ML - 数据类型

- 机器学习 - 资源

- ML - 快速指南

- ML - 速查表

- ML - 面试问题

- ML - 有用资源

- ML - 讨论

机器学习 - 聚类算法

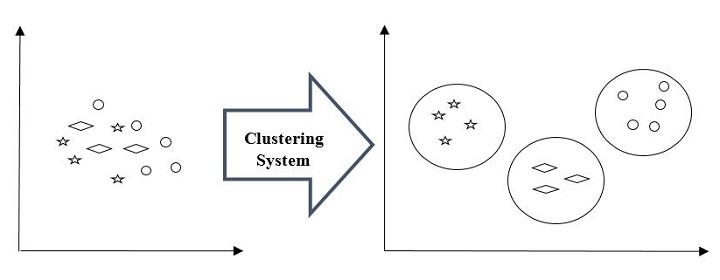

聚类方法是最有用的无监督机器学习方法之一。这些方法用于查找数据样本之间的相似性和关系模式,然后根据特征将这些样本聚类到具有相似性的组中。聚类很重要,因为它确定了当前未标记数据中的内在分组。它们基本上对数据点做出一些假设来构成它们的相似性。每个假设都会构建不同的但同样有效的聚类。

例如,下图显示了聚类系统将相似类型的数据分组到不同聚类中:

聚类形成方法

聚类不必以球形形式形成。以下是其他一些聚类形成方法:

基于密度的 - 在这些方法中,聚类形成密集区域。这些方法的优点是它们具有良好的准确性和良好的合并两个聚类的能力。例如,基于密度的噪声应用空间聚类 (DBSCAN)、排序点以识别聚类结构 (OPTICS) 等。

基于层次的 - 在这些方法中,聚类形成基于层次的树状结构。它们有两个类别,即凝聚的(自下而上的方法)和分裂的(自上而下的方法)。例如,使用代表的聚类 (CURE)、基于层次的平衡迭代减少聚类 (BIRCH) 等。

分区 - 在这些方法中,聚类通过将对象划分为 k 个聚类来形成。聚类数将等于分区数。例如,K均值、基于随机搜索的大型应用程序聚类 (CLARANS)。

网格 - 在这些方法中,聚类形成网格状结构。这些方法的优点是所有在这些网格上完成的聚类操作都很快并且独立于数据对象的数量。例如,统计信息网格 (STING)、聚类查询 (CLIQUE)。

聚类不必以球形形式形成。以下是其他一些聚类形成方法:

基于密度的

在这些方法中,聚类形成密集区域。这些方法的优点是它们具有良好的准确性和良好的合并两个聚类的能力。例如,基于密度的噪声应用空间聚类 (DBSCAN)、排序点以识别聚类结构 (OPTICS) 等。

基于层次的

在这些方法中,聚类形成基于层次的树状结构。它们有两个类别,即凝聚的(自下而上的方法)和分裂的(自上而下的方法)。例如,使用代表的聚类 (CURE)、基于层次的平衡迭代减少聚类 (BIRCH) 等。

分区

在这些方法中,聚类通过将对象划分为 k 个聚类来形成。聚类数将等于分区数。例如,K均值、基于随机搜索的大型应用程序聚类 (CLARANS)。

网格

在这些方法中,聚类形成网格状结构。这些方法的优点是所有在这些网格上完成的聚类操作都很快并且独立于数据对象的数量。例如,统计信息网格 (STING)、聚类查询 (CLIQUE)。

ML 聚类算法的类型

以下是最重要的和有用的 ML 聚类算法:

K均值聚类

此聚类算法计算质心并迭代,直到找到最佳质心。它假设聚类数已知。它也称为平面聚类算法。算法从数据中识别出的聚类数由 K 均值中的“K”表示。

均值漂移算法

它是无监督学习中使用的另一种强大的聚类算法。与 K 均值聚类不同,它不做出任何假设,因此它是一种非参数算法。

层次聚类

它是另一种无监督学习算法,用于将具有相似特征的未标记数据点组合在一起。

我们将在接下来的章节中详细讨论所有这些算法。

聚类的应用

我们可以在以下领域发现聚类很有用:

数据汇总和压缩 - 聚类广泛用于需要数据汇总、压缩和减少的领域。例如,图像处理和矢量量化。

协作系统和客户细分 - 由于聚类可用于查找类似的产品或相同类型的用户,因此可用于协作系统和客户细分领域。

作为其他数据挖掘任务的关键中间步骤 - 聚类分析可以为分类、测试、假设生成生成数据的紧凑摘要;因此,它也作为其他数据挖掘任务的关键中间步骤。

动态数据中的趋势检测 - 通过对类似趋势进行各种聚类,聚类也可用于动态数据中的趋势检测。

社交网络分析 - 聚类可用于社交网络分析。例如,在图像、视频或音频中生成序列。

生物数据分析 - 聚类也可用于对图像、视频进行聚类,因此可成功用于生物数据分析。

现在您已经了解了什么是聚类以及它是如何工作的,让我们在接下来的几章中了解机器学习中使用的一些聚类算法。