- 机器学习基础

- ML - 首页

- ML - 简介

- ML - 入门

- ML - 基本概念

- ML - 生态系统

- ML - Python库

- ML - 应用

- ML - 生命周期

- ML - 所需技能

- ML - 实现

- ML - 挑战与常见问题

- ML - 限制

- ML - 真实案例

- ML - 数据结构

- ML - 数学基础

- ML - 人工智能

- ML - 神经网络

- ML - 深度学习

- ML - 获取数据集

- ML - 分类数据

- ML - 数据加载

- ML - 数据理解

- ML - 数据预处理

- ML - 模型

- ML - 监督学习

- ML - 无监督学习

- ML - 半监督学习

- ML - 强化学习

- ML - 监督学习 vs. 无监督学习

- 机器学习数据可视化

- ML - 数据可视化

- ML - 直方图

- ML - 密度图

- ML - 箱线图

- ML - 相关矩阵图

- ML - 散点矩阵图

- 机器学习统计学

- ML - 统计学

- ML - 均值、中位数、众数

- ML - 标准差

- ML - 百分位数

- ML - 数据分布

- ML - 偏度和峰度

- ML - 偏差与方差

- ML - 假设

- 机器学习中的回归分析

- ML - 回归分析

- ML - 线性回归

- ML - 简单线性回归

- ML - 多元线性回归

- ML - 多项式回归

- 机器学习中的分类算法

- ML - 分类算法

- ML - 逻辑回归

- ML - K近邻算法 (KNN)

- ML - 朴素贝叶斯算法

- ML - 决策树算法

- ML - 支持向量机

- ML - 随机森林

- ML - 混淆矩阵

- ML - 随机梯度下降

- 机器学习中的聚类算法

- ML - 聚类算法

- ML - 基于中心的聚类

- ML - K均值聚类

- ML - K中心点聚类

- ML - 均值漂移聚类

- ML - 层次聚类

- ML - 基于密度的聚类

- ML - DBSCAN聚类

- ML - OPTICS聚类

- ML - HDBSCAN聚类

- ML - BIRCH聚类

- ML - 亲和传播聚类

- ML - 基于分布的聚类

- ML - 凝聚层次聚类

- 机器学习中的降维

- ML - 降维

- ML - 特征选择

- ML - 特征提取

- ML - 向后剔除法

- ML - 向前特征构建

- ML - 高相关性筛选

- ML - 低方差筛选

- ML - 缺失值比率

- ML - 主成分分析

- 强化学习

- ML - 强化学习算法

- ML - 利用与探索

- ML - Q学习

- ML - REINFORCE算法

- ML - SARSA强化学习

- ML - 演员-评论家方法

- 深度强化学习

- ML - 深度强化学习

- 量子机器学习

- ML - 量子机器学习

- ML - 使用Python的量子机器学习

- 机器学习杂项

- ML - 性能指标

- ML - 自动化工作流

- ML - 提升模型性能

- ML - 梯度提升

- ML - 自举汇聚 (Bagging)

- ML - 交叉验证

- ML - AUC-ROC曲线

- ML - 网格搜索

- ML - 数据缩放

- ML - 训练和测试

- ML - 关联规则

- ML - Apriori算法

- ML - 高斯判别分析

- ML - 成本函数

- ML - 贝叶斯定理

- ML - 精度和召回率

- ML - 对抗性

- ML - 堆叠

- ML - 轮次

- ML - 感知器

- ML - 正则化

- ML - 过拟合

- ML - P值

- ML - 熵

- ML - MLOps

- ML - 数据泄露

- ML - 机器学习的货币化

- ML - 数据类型

- 机器学习 - 资源

- ML - 快速指南

- ML - 速查表

- ML - 面试问题

- ML - 有用资源

- ML - 讨论

Q学习

Q学习是一种基于值的强化学习算法,它使模型能够通过采取正确的行动来迭代学习和改进。正确的行动被认为是奖励,而错误的行动则被认为是惩罚。

什么是强化学习中的Q学习?

强化学习是一种机器学习方法,其中学习代理通过持续交互来学习如何在特定环境中做出正确的决策。在学习过程中,代理会在环境中经历各种情况,这些情况被称为“状态”。代理在特定状态下执行从可操作动作集中选择的动作,这些动作会带来奖励或惩罚。随着时间的推移,学习代理会学习最大化这些奖励,以便在任何状态下都能正确地行动。Q学习就是这样一种算法,它使用Q值(也称为动作值)来迭代地改进学习代理的行为。

Q学习的关键组成部分

Q学习模型通过一个迭代过程运行,其中几个组件协同工作来训练模型。迭代过程包括代理通过探索环境进行学习并持续更新模型。Q学习包括以下组件:

- 代理 - 代理是在给定环境中运行和执行任务的实体。

- 状态 - 状态是一个变量,它指定代理在环境中的当前情况。

- 动作 - 代理在特定状态下的行为。

- 奖励 - 强化学习背后的思想是向代理的动作提供正面或负面的反馈。

- 回合 - 当代理达到无法再采取任何行动并终止的点时,就会发生一个回合。

- Q值 - Q值是用于评估特定状态下动作的度量。

Q学习是如何工作的?

Q学习通过反复试验来学习代理在环境中执行的特定动作的结果。Q学习过程包括通过学习称为Q函数的最优动作值函数来模拟最优行为。有两种方法可以确定Q值:

时间差分

时间差分方程通过评估代理的当前状态和动作以及之前的状态和动作来确定Q值,从而确定差异。

时间差分可以表示为:

Q(s,a) = Q(s,a) + ɑ(r + γmaxaQ(s',a)-Q(s,a))

其中:

s 代表代理的当前状态。

a 代表从Q表中选择的当前动作。

s' 代表代理终止的下一个状态。

a' 代表使用当前Q值估计选择的下一个最佳动作。

r 代表环境对当前动作作出的当前奖励。

γ ( &0 and <=1) 是未来奖励的折扣因子。

ɑ 是用于更新Q(s,a)估计值的步长。

贝尔曼方程

数学家理查德·贝尔曼在1957年提出了这个方程,作为一种使用递归做出最优决策的方法。在Q学习的背景下,贝尔曼方程用于确定特定状态的值并评估其相对位置。最优状态由具有最高值的狀態确定。

贝尔曼方程可以表示为:

Q(s,a) = r(s,a) + ɑ maxaQ(s',a)

其中:

Q(s,a) 表示在状态's'中采取动作'a'的预期奖励。

R (s,a) 表示在状态's'中执行动作a时获得的奖励。

ɑ 是折扣因子,表示未来奖励的重要性。

maxaQ(s',a) 表示下一个状态s'和所有可能动作的最大Q值。

Q学习算法

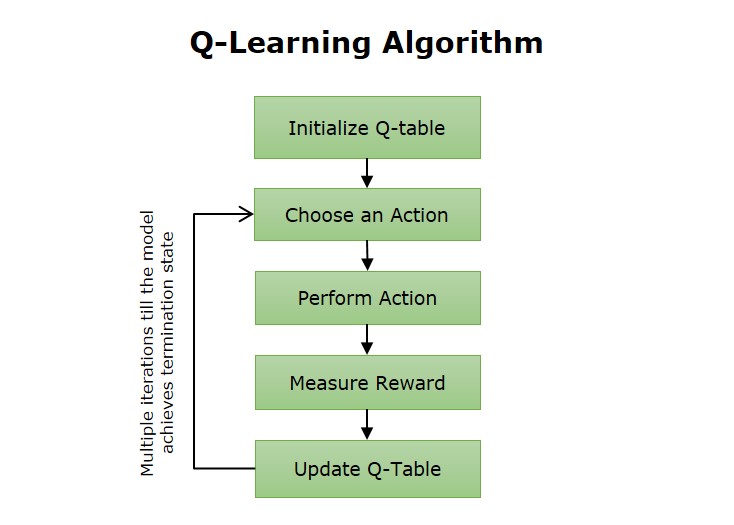

Q学习算法涉及代理通过探索环境并根据收到的奖励更新Q表来进行学习。Q表是一个存储库,用于存储与给定环境中每个状态的最优动作相关的奖励。Q学习算法过程中的步骤包括:

Q学习算法的步骤如下:

- Q表的初始化 - 第一步涉及初始化Q表,以监控与在不同状态下采取的动作相关的进度。

- 观察 - 代理观察环境的当前状态。

- 行动 - 代理决定在环境中采取行动。完成后,模型会观察该行动是否有助于环境。

- 更新 - 行动完成后,是时候使用结果更新Q表了。

- 重复 - 重复执行步骤2-4,直到模型达到终止状态。

Q学习的优点

强化学习中的Q学习方法具有多种优势,例如:

- 这种反复试验的学习方法类似于人们的学习方式,使其几乎是理想的。

- 这种学习方法不依赖于策略,这使其能够充分优化以获得最佳结果。

- 这种无模型、非策略方法提高了在无法动态声明参数的环境中工作的灵活性。

- 该模型能够在训练过程中纠正错误,并且再次发生已纠正错误的可能性非常小。

Q学习的缺点

强化学习中的Q学习方法也有一些缺点,例如:

- 对于这种方法来说,找到尝试新动作和坚持已知内容之间的正确平衡是相当具有挑战性的。

- Q学习模型有时会表现出过度乐观,并高估特定动作或策略的有效性。

- 有时,当Q学习模型面临多个问题解决选项时,确定最优策略会非常耗时。

Q学习的应用

Q学习模型可以改进各种场景中的过程。一些领域包括:

- 游戏 - Q学习算法可以通过学习最佳策略来提高游戏系统的技能水平,使其达到各种游戏的专家级水平。

- 推荐系统 - Q学习算法可以用来改进推荐系统,例如广告平台。

- 机器人技术 - Q学习算法使机器人能够学习如何执行不同的任务,例如操纵物体、避开障碍物和运输物品。

- 自动驾驶汽车 - Q学习算法用于训练自动驾驶汽车做出驾驶决策,例如换道或停车。

- 供应链 - Q学习模型可以通过优化产品进入市场的路径来提高供应链的效率。