- 机器学习基础

- ML - 首页

- ML - 简介

- ML - 入门

- ML - 基本概念

- ML - 生态系统

- ML - Python 库

- ML - 应用

- ML - 生命周期

- ML - 必备技能

- ML - 实现

- ML - 挑战与常见问题

- ML - 局限性

- ML - 现实生活中的例子

- ML - 数据结构

- ML - 数学

- ML - 人工智能

- ML - 神经网络

- ML - 深度学习

- ML - 获取数据集

- ML - 分类数据

- ML - 数据加载

- ML - 数据理解

- ML - 数据准备

- ML - 模型

- ML - 监督学习

- ML - 无监督学习

- ML - 半监督学习

- ML - 强化学习

- ML - 监督学习与无监督学习

- 机器学习数据可视化

- ML - 数据可视化

- ML - 直方图

- ML - 密度图

- ML - 箱线图

- ML - 相关矩阵图

- ML - 散点矩阵图

- 机器学习统计学

- ML - 统计学

- ML - 平均值、中位数、众数

- ML - 标准差

- ML - 百分位数

- ML - 数据分布

- ML - 偏度和峰度

- ML - 偏差和方差

- ML - 假设

- ML中的回归分析

- ML - 回归分析

- ML - 线性回归

- ML - 简单线性回归

- ML - 多元线性回归

- ML - 多项式回归

- ML中的分类算法

- ML - 分类算法

- ML - 逻辑回归

- ML - K近邻算法 (KNN)

- ML - 朴素贝叶斯算法

- ML - 决策树算法

- ML - 支持向量机

- ML - 随机森林

- ML - 混淆矩阵

- ML - 随机梯度下降

- ML中的聚类算法

- ML - 聚类算法

- ML - 基于中心的聚类

- ML - K均值聚类

- ML - K中心点聚类

- ML - 均值漂移聚类

- ML - 层次聚类

- ML - 基于密度的聚类

- ML - DBSCAN聚类

- ML - OPTICS聚类

- ML - HDBSCAN聚类

- ML - BIRCH聚类

- ML - 亲和传播

- ML - 基于分布的聚类

- ML - 凝聚层次聚类

- ML中的降维

- ML - 降维

- ML - 特征选择

- ML - 特征提取

- ML - 向后剔除法

- ML - 前向特征构造

- ML - 高相关性过滤器

- ML - 低方差过滤器

- ML - 缺失值比率

- ML - 主成分分析

- 强化学习

- ML - 强化学习算法

- ML - 开发与探索

- ML - Q学习

- ML - REINFORCE算法

- ML - SARSA强化学习

- ML - 演员-评论家方法

- 深度强化学习

- ML - 深度强化学习

- 量子机器学习

- ML - 量子机器学习

- ML - 使用Python的量子机器学习

- 机器学习杂项

- ML - 性能指标

- ML - 自动工作流

- ML - 提升模型性能

- ML - 梯度提升

- ML - 自举汇聚 (Bagging)

- ML - 交叉验证

- ML - AUC-ROC曲线

- ML - 网格搜索

- ML - 数据缩放

- ML - 训练和测试

- ML - 关联规则

- ML - Apriori算法

- ML - 高斯判别分析

- ML - 成本函数

- ML - 贝叶斯定理

- ML - 精确率和召回率

- ML - 对抗性

- ML - 堆叠

- ML - 时期

- ML - 感知器

- ML - 正则化

- ML - 过拟合

- ML - P值

- ML - 熵

- ML - MLOps

- ML - 数据泄露

- ML - 机器学习的货币化

- ML - 数据类型

- 机器学习 - 资源

- ML - 快速指南

- ML - 速查表

- ML - 面试问题

- ML - 有用资源

- ML - 讨论

机器学习中的开发与探索

在机器学习中,**探索**是指允许智能体发现关于环境的新特征的行为,而**开发**是指让智能体坚持已获得的现有知识。如果智能体持续开发过去的经验,它可能会陷入困境。另一方面,如果它继续探索,它可能永远找不到好的策略,这导致了**探索-开发困境**。

机器学习中的开发

**开发**是强化学习中的一种策略,智能体利用它根据现有知识在一个状态下做出决策,以最大化预期奖励。开发的目标是利用已经了解的环境来获得最佳结果。

开发的关键方面

开发的关键方面包括:

- **最大化奖励:**开发的主要目标是根据对环境的当前理解最大化预期奖励。这涉及根据学习到的值和奖励选择一个动作,这些值和奖励将产生最高的结果。

- **提高决策效率:**开发有助于做出高效的决策,特别是通过专注于高奖励的动作,从而减少执行探索的计算成本。

- **风险管理:**开发本质上具有较低的风险水平,因为它更侧重于经过验证的动作,从而降低了与不太熟悉的选择相关的风险。

机器学习中的探索

探索是一种使智能体能够获取关于环境或模型的知识的行为。探索过程选择具有不可预测结果的动作,以收集关于执行动作将导致的状态和奖励的信息。

探索的关键方面

探索的关键方面包括:

- **获取信息:**探索的主要目标是允许智能体通过在一个状态下执行新的动作来收集信息,从而提高对模型或环境的理解。

- **减少不确定性:**探索的主要目标是允许智能体通过在一个状态下执行新的动作来收集信息,从而提高对模型或环境的理解。

- **状态空间覆盖:**在包含广泛或连续状态空间的特定模型中,探索可确保访问状态空间中足够多样的区域,以防止学习偏向于少量经验。

动作选择

强化学习的目标是教会智能体如何在各种状态下表现。智能体在训练过程中使用各种方法(如贪婪动作选择、ε-贪婪动作选择、置信上限动作选择等)来学习在何种情况下执行何种动作。

探索与开发权衡

使用智能体的现有知识与尝试随机动作的想法称为开发-探索权衡。当智能体探索时,它可以增强其现有知识并随着时间的推移取得改进。在另一种情况下,如果它使用现有知识,它会立即获得更大的奖励。由于智能体无法同时执行这两个任务,因此存在折衷。

资源的分配应取决于这两个流的需求,根据当前状态和学习任务的复杂性交替进行。

平衡探索与开发的技术

以下是平衡强化学习中探索与开发的一些技术:

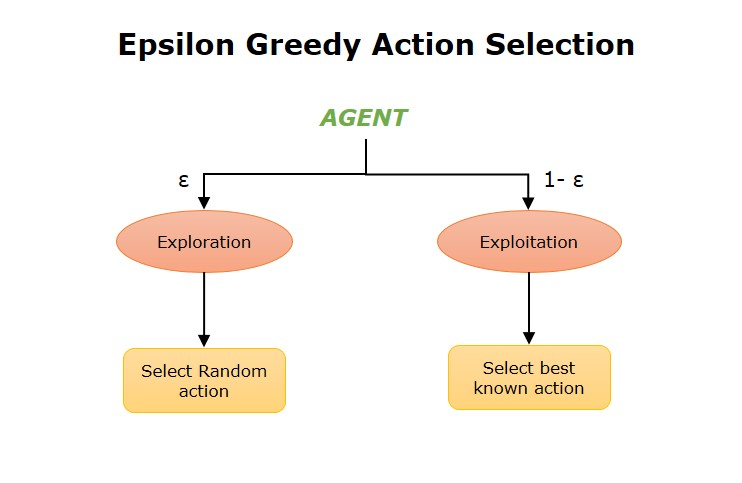

ε-贪婪动作选择

在强化学习中,智能体通常根据其奖励选择一个动作。智能体始终选择最佳动作以产生给定状态下可能的最大奖励。**在ε-贪婪动作选择中,智能体既使用开发来从先前知识中获得见解,又使用探索来寻找新选项。**

ε-贪婪方法通常选择具有最高预期奖励的动作。目标是在探索和开发之间取得平衡。以ε的小概率,我们选择探索而不是开发智能体迄今为止学到的知识。

多臂老虎机框架

多臂老虎机框架为管理顺序决策问题中探索和开发之间的平衡提供了正式的基础。它们提供能够根据各种奖励系统和情况分析探索和开发之间权衡的算法。

置信上限

置信上限 (UCB) 是一种流行的算法,用于平衡强化学习中的探索和开发。该算法基于**面对不确定性的乐观主义**原理。它选择优化预期奖励的置信上限的动作。这表明它既考虑了动作的平均奖励,也考虑了该奖励的不确定性或可变性。