- 机器学习基础

- ML - 首页

- ML - 简介

- ML - 入门

- ML - 基本概念

- ML - 生态系统

- ML - Python 库

- ML - 应用

- ML - 生命周期

- ML - 必备技能

- ML - 实现

- ML - 挑战与常见问题

- ML - 限制

- ML - 现实生活中的例子

- ML - 数据结构

- ML - 数学

- ML - 人工智能

- ML - 神经网络

- ML - 深度学习

- ML - 获取数据集

- ML - 分类数据

- ML - 数据加载

- ML - 数据理解

- ML - 数据准备

- ML - 模型

- ML - 监督学习

- ML - 无监督学习

- ML - 半监督学习

- ML - 强化学习

- ML - 监督学习与无监督学习

- 机器学习数据可视化

- ML - 数据可视化

- ML - 直方图

- ML - 密度图

- ML - 箱线图

- ML - 相关矩阵图

- ML - 散点矩阵图

- 机器学习统计学

- ML - 统计学

- ML - 平均值、中位数、众数

- ML - 标准差

- ML - 百分位数

- ML - 数据分布

- ML - 偏度和峰度

- ML - 偏差和方差

- ML - 假设

- ML中的回归分析

- ML - 回归分析

- ML - 线性回归

- ML - 简单线性回归

- ML - 多元线性回归

- ML - 多项式回归

- ML中的分类算法

- ML - 分类算法

- ML - 逻辑回归

- ML - K近邻算法 (KNN)

- ML - 朴素贝叶斯算法

- ML - 决策树算法

- ML - 支持向量机

- ML - 随机森林

- ML - 混淆矩阵

- ML - 随机梯度下降

- ML中的聚类算法

- ML - 聚类算法

- ML - 基于中心点的聚类

- ML - K均值聚类

- ML - K中心点聚类

- ML - 均值漂移聚类

- ML - 层次聚类

- ML - 基于密度的聚类

- ML - DBSCAN聚类

- ML - OPTICS聚类

- ML - HDBSCAN聚类

- ML - BIRCH聚类

- ML - 亲和传播

- ML - 基于分布的聚类

- ML - 聚合聚类

- ML中的降维

- ML - 降维

- ML - 特征选择

- ML - 特征提取

- ML - 后退消除法

- ML - 前向特征构造

- ML - 高相关性过滤器

- ML - 低方差过滤器

- ML - 缺失值比率

- ML - 主成分分析

- 强化学习

- ML - 强化学习算法

- ML - 利用与探索

- ML - Q学习

- ML - REINFORCE算法

- ML - SARSA强化学习

- ML - 演员-评论家方法

- 深度强化学习

- ML - 深度强化学习

- 量子机器学习

- ML - 量子机器学习

- ML - 使用Python的量子机器学习

- 机器学习杂项

- ML - 性能指标

- ML - 自动工作流

- ML - 提升模型性能

- ML - 梯度提升

- ML - 自举汇聚 (Bagging)

- ML - 交叉验证

- ML - AUC-ROC曲线

- ML - 网格搜索

- ML - 数据缩放

- ML - 训练与测试

- ML - 关联规则

- ML - Apriori算法

- ML - 高斯判别分析

- ML - 成本函数

- ML - 贝叶斯定理

- ML - 精确率和召回率

- ML - 对抗性

- ML - 堆叠

- ML - 时期

- ML - 感知器

- ML - 正则化

- ML - 过拟合

- ML - P值

- ML - 熵

- ML - MLOps

- ML - 数据泄露

- ML - 机器学习的盈利化

- ML - 数据类型

- 机器学习 - 资源

- ML - 快速指南

- ML - 速查表

- ML - 面试问题

- ML - 有用资源

- ML - 讨论

机器学习 - 基于分布的聚类

基于分布的聚类算法,也称为概率聚类算法,是一类机器学习算法,假设数据点是由概率分布的混合生成的。这些算法旨在识别生成数据的潜在概率分布,并利用此信息将数据聚类成具有相似属性的组。

一种常见的基于分布的聚类算法是高斯混合模型 (GMM)。GMM假设数据点是由高斯分布的混合生成的,并旨在估计这些分布的参数,包括每个分布的均值和协方差。下面我们来看看什么是ML中的GMM以及如何在Python编程语言中实现它。

高斯混合模型

高斯混合模型 (GMM) 是一种流行的机器学习聚类算法,它假设数据是由高斯分布的混合生成的。换句话说,GMM试图将一组高斯分布拟合到数据中,其中每个高斯分布代表数据中的一个聚类。

与其他聚类算法相比,GMM 具有几个优势,例如能够处理重叠聚类、对数据的协方差结构进行建模以及为每个数据点提供概率聚类分配。这使得 GMM 成为许多应用中的流行选择,例如图像分割、模式识别和异常检测。

Python实现

在 Python 中,Scikit-learn 库提供了 GaussianMixture 类来实现 GMM 算法。该类接受几个参数,包括组件数量(即要识别的聚类数量)、协方差类型和初始化方法。

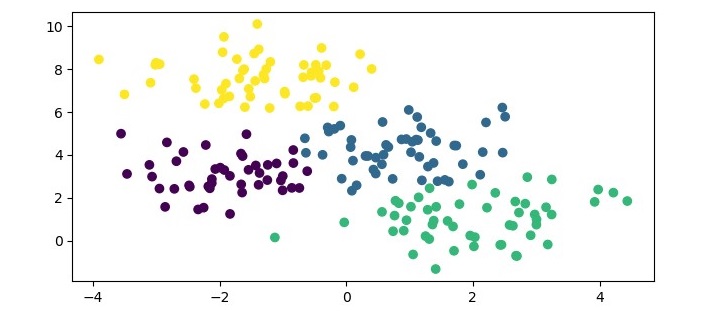

以下是如何使用 Python 中的 Scikit-learn 库实现 GMM 的示例:

示例

from sklearn.mixture import GaussianMixture

from sklearn.datasets import make_blobs

import matplotlib.pyplot as plt

# generate a dataset

X, _ = make_blobs(n_samples=200, centers=4, random_state=0)

# create an instance of the GaussianMixture class

gmm = GaussianMixture(n_components=4)

# fit the model to the dataset

gmm.fit(X)

# predict the cluster labels for the data points

labels = gmm.predict(X)

# print the cluster labels

print("Cluster labels:", labels)

plt.figure(figsize=(7.5, 3.5))

plt.scatter(X[:, 0], X[:, 1], c=labels, cmap='viridis')

plt.show()

在此示例中,我们首先使用 Scikit-learn 中的 make_blobs() 函数生成一个合成数据集。然后,我们创建一个具有 4 个组件的 GaussianMixture 类的实例,并使用 fit() 方法将模型拟合到数据集。最后,我们使用 predict() 方法预测数据点的聚类标签,并打印结果标签。

输出

执行此程序时,它将生成以下图表作为输出:

此外,您将在终端上获得以下输出:

Cluster labels: [2 0 1 3 2 1 0 1 1 1 1 2 0 0 2 1 3 3 3 1 3 1 2 0 2 2 3 2 2 1 3 1 0 2 0 1 0 1 1 3 3 3 3 1 2 0 1 3 3 1 3 0 0 3 2 3 0 2 3 2 3 1 2 1 3 1 2 3 0 0 2 2 1 1 0 3 0 0 2 2 3 1 2 2 0 1 1 2 0 0 3 3 3 1 1 2 0 3 2 1 3 2 2 3 3 0 1 2 2 1 3 0 0 2 2 1 2 0 3 1 3 0 1 2 1 0 1 0 2 1 0 2 1 3 3 0 3 3 2 3 2 0 2 2 2 2 1 2 0 3 3 3 1 0 2 1 3 0 3 2 3 2 2 0 0 3 1 2 2 0 1 1 0 3 3 3 1 3 0 0 1 2 1 2 1 0 0 3 1 3 2 2 1 3 0 0 0 1 3 1]

GMM 中的协方差类型参数控制用于高斯分布的协方差矩阵的类型。可用选项包括“full”(完整协方差矩阵)、“tied”(所有聚类的绑定协方差矩阵)、“diag”(对角协方差矩阵)和“spherical”(所有维度的一个方差参数)。初始化方法参数控制用于初始化高斯分布参数的方法。

高斯混合模型的优点

以下是使用高斯混合模型的优点:

高斯混合模型 (GMM) 可以对任意数据分布进行建模,使其成为一种灵活的聚类算法。

它可以处理具有缺失或不完整数据的数据集。

它为聚类提供了一个概率框架,可以提供有关聚类结果不确定性的更多信息。

它可用于密度估计和生成遵循与原始数据相同分布的新数据点。

它可用于半监督学习,其中一些数据点具有已知的标签并用于训练模型。

高斯混合模型的缺点

以下是使用高斯混合模型的一些缺点:

GMM 对初始参数的选择很敏感,例如聚类数量以及聚类均值和协方差的初始值。

对于高维数据集,它在计算上可能很昂贵,因为它涉及计算协方差矩阵的逆,对于大型矩阵来说,这可能很昂贵。

它假设数据是由高斯分布的混合生成的,这可能不适用于所有数据集。

它可能容易过拟合,尤其是在参数数量很大或数据集很小的情况下。

解释结果聚类可能很困难,尤其是在协方差矩阵很复杂的情况下。